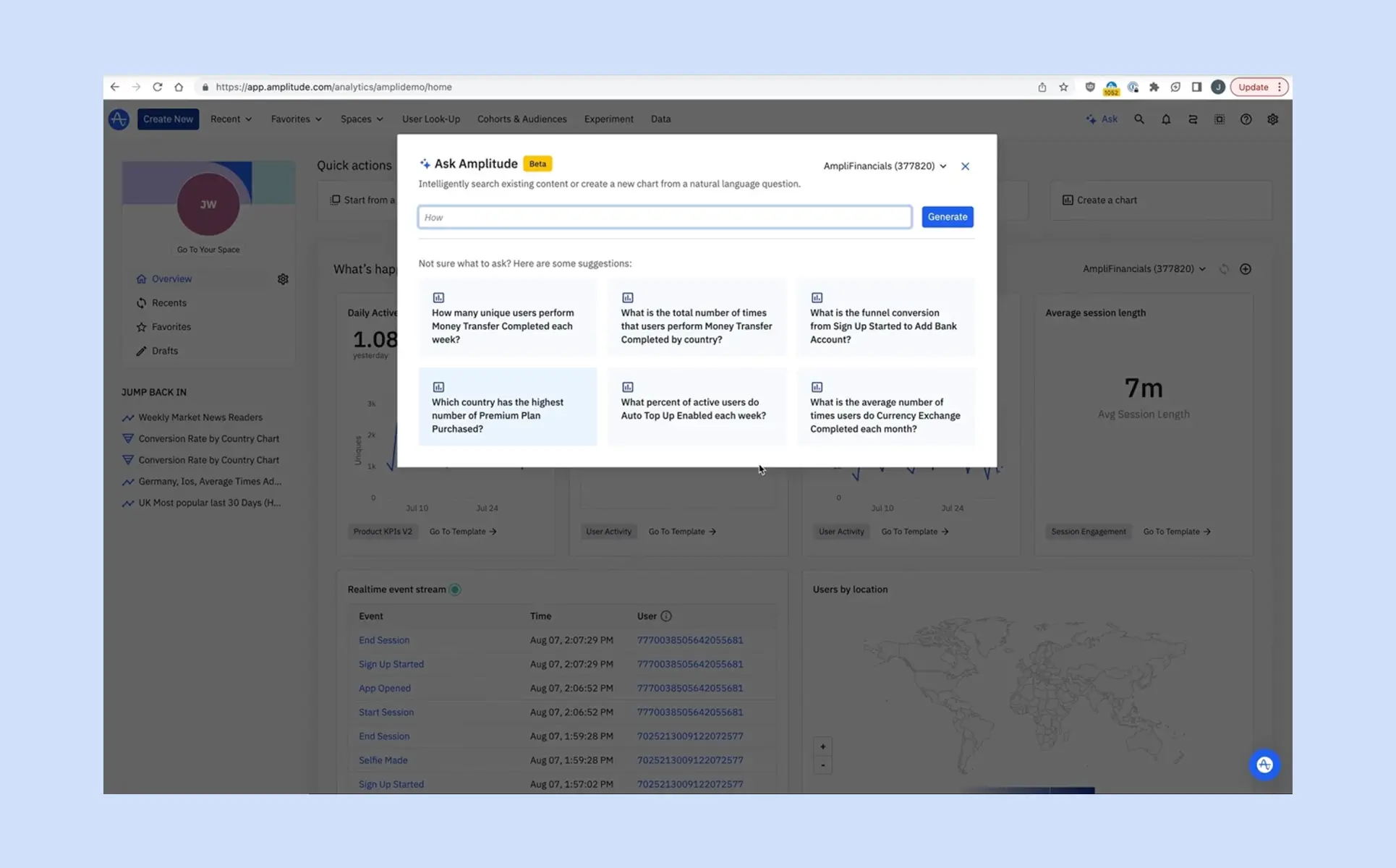

데이터를 분석하다 보면 ‘이 질문에 답하려면 어떤 차트를 만들어야 할까?’라는 고민을 자주 하게 됩니다. 앰플리튜드(Amplitude)는 이러한 고민을 덜어주기 위해 Ask Amplitude를 선보였습니다.

Ask Amplitude는 사용자가 자연어로 질문을 입력하면, 곧바로 적합한 차트를 생성하고 인사이트를 제공합니다. 지금부터 Ask Amplitude를 실무에서 어떻게 활용할 수 있는지, 구체적인 사례를 통해 살펴보겠습니다.

행동 데이터의 핵심 가치는 질문에 답하고, 의사 결정에 필요한 인사이트를 도출하는 데 있습니다. 그러나 지금까지 앰플리튜드를 사용하는 많은 사용자들은 제품 UI에서 차트를 단계별로 직접 구성해야 했습니다.

이제 Ask Amplitude를 통해 이러한 복잡한 차트 작성 과정을 대폭 간소화할 수 있습니다. 여러 단계를 거쳐 차트를 구성할 필요 없이, 아래 예시처럼 궁금한 내용을 질문 형태로 입력하기만 하면 됩니다.

Ask Amplitude는 질문을 이해하고, 적절한 차트 유형과 이벤트, 속성을 자동으로 선택해 결과를 보여줍니다. Amplitude AI Agent 기능과 함께 활용하면, 데이터 분석에 필요한 시간과 노력을 크게 줄일 수 있습니다.

Ask Amplitude는 데이터팀에 의존하지 않고도 누구나 스스로 데이터를 탐색할 수 있도록 설계되었습니다. 단순히 질문에 답하는 AI가 아니라, 실무자가 제품 데이터를 직접 활용할 수 있도록 돕습니다.

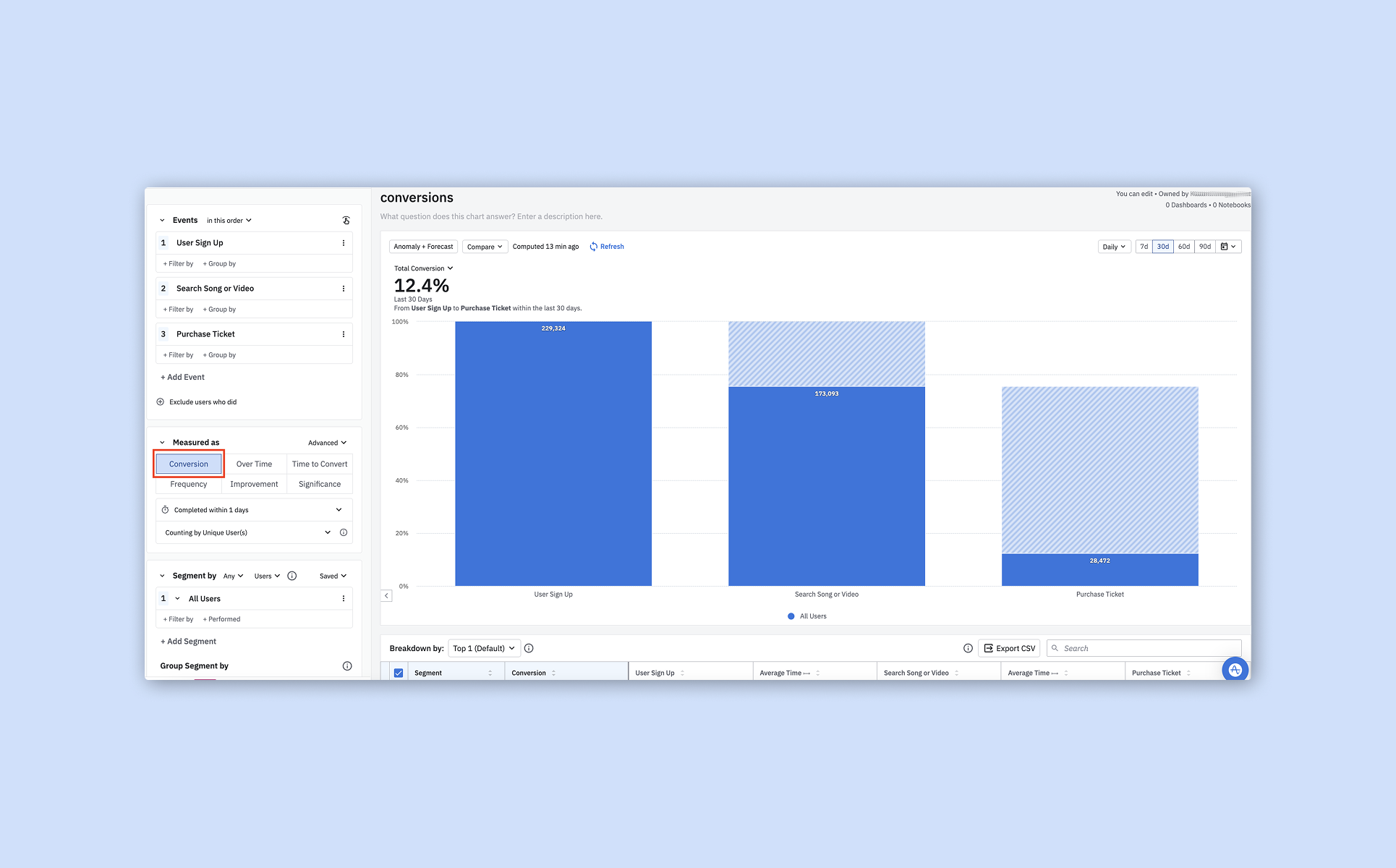

예를 들어 ‘사용자 가입부터 노래 또는 영상 구매까지의 퍼널 전환율은 어떻게 되나요?’라고 질문했다고 가정해 보겠습니다.

Ask Amplitude는 전환율 수치만 제공하는 데서 그치지 않고, A/B 테스트 가입 그룹별로 데이터를 분할하고, 전날 대비 지표를 비교하며, 첫 단계에서 안드로이드(Android)와 iOS 플랫폼만 필터링하는 방법까지 함께 보여줍니다.

또한 자연어 기반으로 데이터 분석을 구성할 수 있게 되면서, 실무자가 필요한 시점에 직접 서비스 데이터를 분석하고 인사이트를 도출할 수 있게 되었습니다. 이렇게 생성된 차트는 단순한 보고용 결과가 아니라, 실무자가 스스로 지식을 쌓고 다음 질문에 주도적으로 답할 수 있는 토대가 됩니다.

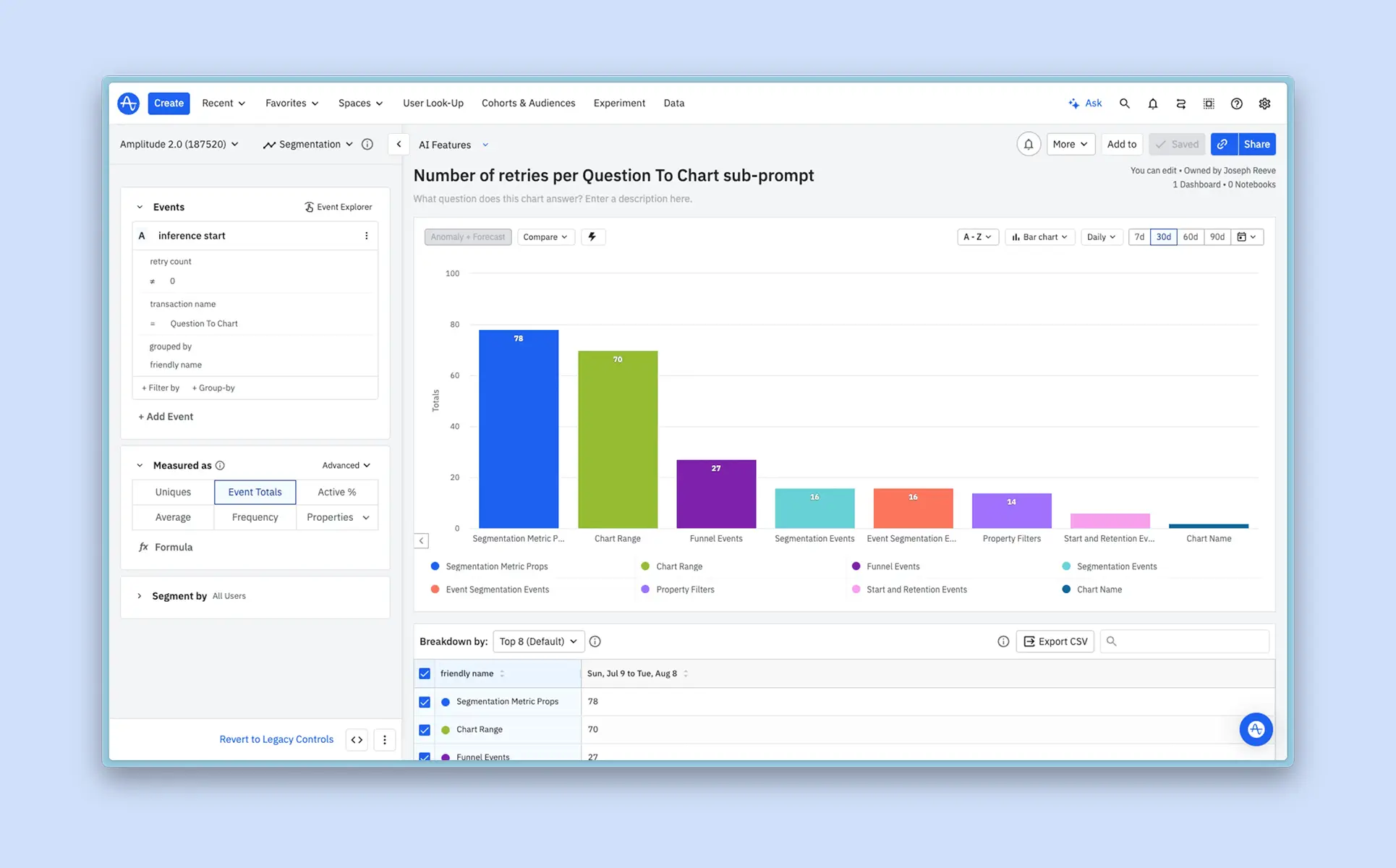

편리함만을 이유로 AI가 차트를 무분별하게 생성하게 두면 문제가 발생할 수 있습니다. 비슷한 내용의 차트가 여러 개가 있으면, 오히려 어떤 차트를 신뢰해야 할지 판단하기 어려워지기 때문입니다.

Ask Amplitude는 시맨틱 검색을 활용해 이러한 문제를 방지합니다. 새로운 차트를 만들기 전에 먼저 앰플리튜드 내에 이미 존재하는 콘텐츠를 검색하고, 동료들이 만들고 검증한 차트 중 유사한 것이 있는지부터 확인합니다.

이러한 검색 기법은 ‘스트리밍된 비디오 시간’과 ‘총 시청 시간’처럼 표현은 다르지만 같은 의미를 가진 용어까지 인식합니다. 덕분에 사용자는 대부분의 경우 새로운 차트를 추가로 생성하지 않고도 필요한 콘텐츠를 찾을 수 있으며, 앰플리튜드 내 콘텐츠의 품질과 신뢰도를 함께 유지할 수 있습니다.

마티니는 앰플리튜드를 활용해 고객사가 데이터에서 인사이트를 얻고, 더 나은 의사결정을 할 수 있도록 돕고 있습니다. 데이터 환경을 구축하고 마케팅 성과를 높이고 싶다면, 지금 바로 마티니와 만나보세요.

상품을 검색하고, 클릭하고, 장바구니에 담고, 결제하기까지. 고객의 쇼핑 여정은 몇 번의 클릭으로, ‘정말 단순하게’ 끝나는 것처럼 보입니다.

하지만 그 짧은 순간 안에는 수십 개의 화면 전환과 수백 개의 기능, 그리고 그보다 더 많은 데이터의 흐름이 얽혀있습니다.

아직도 많은 팀이 이 복잡함을 과소평가한 채 택소노미(Taxonomy)를 설계하거나 이벤트를 수집하기 시작합니다. 그 결과, '데이터 분석' 단계에서 어려움을 호소하시는 분들이 많습니다.

“이 이벤트는 정확히 어디서 발생한 거지?”

“정의된 경로 외에 다른 트리거 포인트가 있나?”

이런 질문은 서비스가 고도화될수록 더 자주 발생합니다. UI·UX가 개편될 때마다 예외 케이스가 생기고, 처음 정의했던 이벤트 구조는 점점 흔들립니다. 결국 데이터 정리는 계속 밀리고, 어느 순간 서비스 변화의 속도를 따라잡지 못하는 악순환에 빠지게 됩니다.

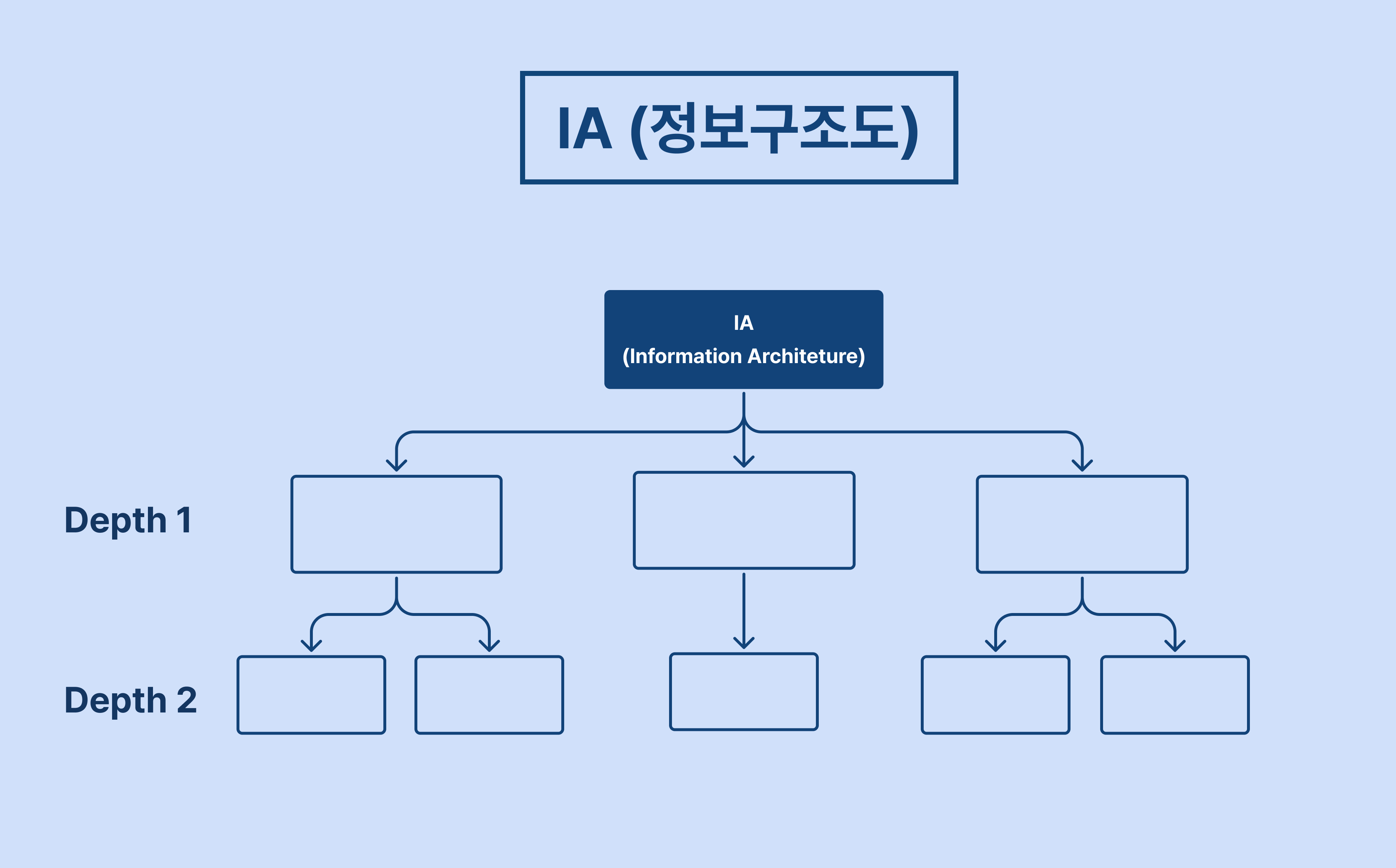

이러한 악순환을 줄이고 서비스 전체의 맥락 속에서 데이터를 이해하기 위해 필요한 첫 번째 단계가 바로 IA(Information Architecture, 정보 구조도) 설계입니다. 이번 글에서는 IA가 데이터 분석에서 왜 중요한지 알아보겠습니다.

IA(Information Architecture)는 보통 서비스 개발 전 기획 단계에서 사용됩니다.

이는 웹이나 앱 안에 존재하는 수많은 화면, 버튼, 기능을 한눈에 볼 수 있도록 체계적으로 정리한 서비스의 지도이자 목차라고 볼 수 있습니다.

이 단계에서는 서비스의 전체 구조를 체계적으로 정리하고, 각 페이지와 기능을 계층적으로 정의하는 데 중점을 둡니다.

.webp)

이렇게 정의된 IA는 와이어프레임과 유저 플로우 설계와 연결되어 발전시킬 수 있는데요.

와이어프레임(Wireframe)이 실제 화면을 기준으로 사용자의 이동 경로를 보여준다면, IA는 그보다 한 단계 위에서 서비스 전체의 계층별 구조를 보여주는 설계도 역할을 합니다.

결국 서비스 구조를 먼저 이해해야만 사용자가 거치는 모든 여정과 흐름을 온전히 파악할 수 있습니다.

그렇다면, 이미 서비스가 출시된 상황에서 다시 IA를 그린다는 건 어떤 의미일까요? 단순히 구조를 정리하거나 문서를 업데이트하기 위한 작업일까요? 사실 그렇지 않습니다.

데이터 분석은 결국 '사용자가 어떤 화면에서 어떤 행동을 했는가'를 해석하는 일입니다. 서비스 구조를 파악하지 않은 채 데이터를 분석하면, 이벤트는 맥락을 잃고 분석은 반복적으로 막힙니다.

IA가 데이터 분석의 출발점인 이유는 명확합니다. 모든 분석의 기준점이 되기 때문입니다. 이제 왜 중요한지, 세 가지로 나눠 알아보겠습니다.

데이터 분석에서 가장 중요한 질문은 이것입니다.

"이 이벤트가 어디서, 어떤 맥락에서 발생했는가?"

IA를 기준으로 각 화면과 기능을 정리해두면, 어떤 페이지에서 어떤 이벤트가 발생해야 하는지를 명확히 정의할 수 있습니다. 즉, IA는 이벤트 매핑의 기준점이 됩니다.

이 기준점이 있으면 분석가는 데이터의 맥락을 잃지 않고, 이벤트가 누락되거나 중복 수집되는 지점을 빠르게 찾아낼 수 있습니다. 문제를 발견하는 시간이 줄어들고, 분석은 더 정확해집니다.

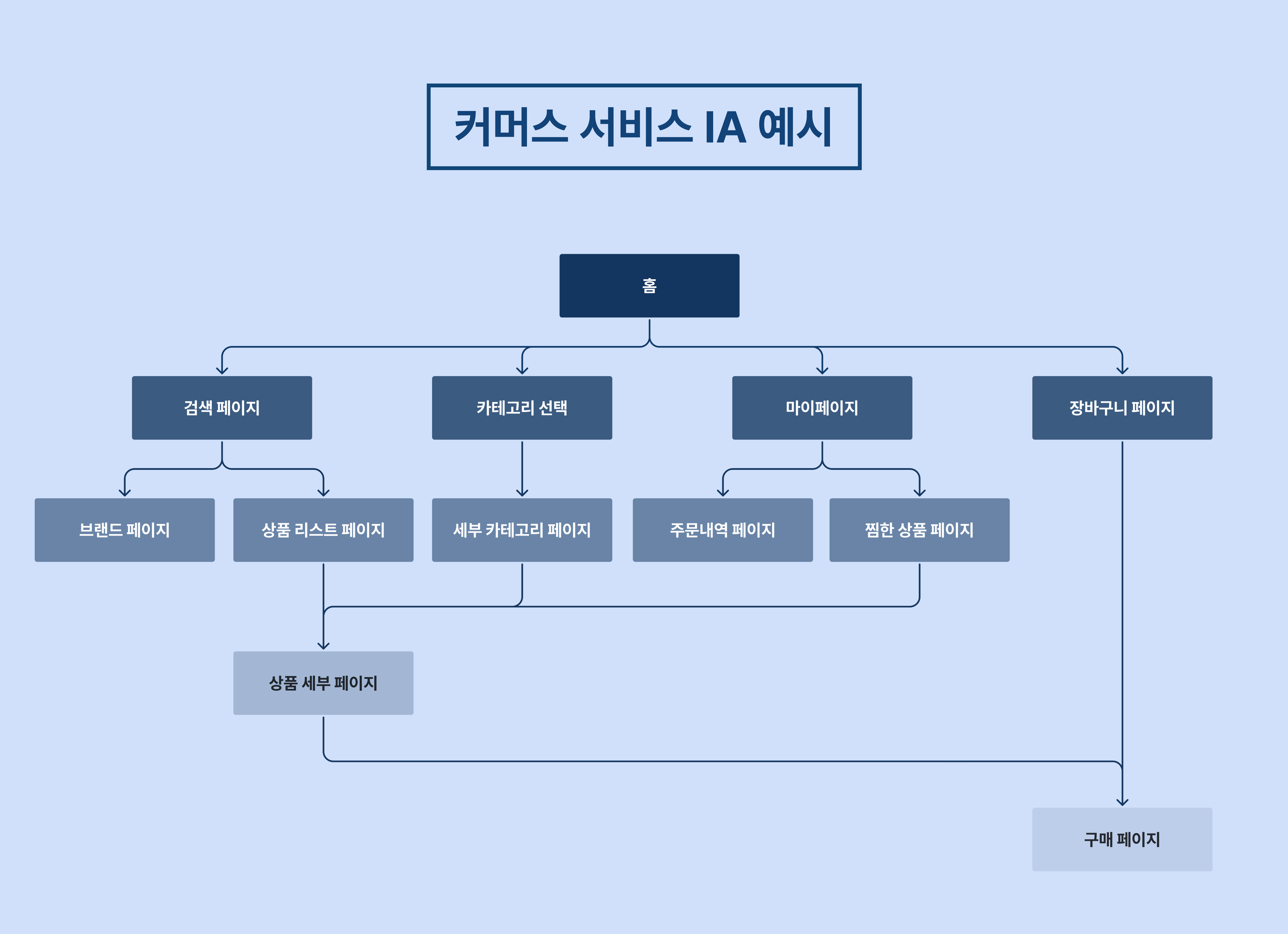

커머스 유저 여정은 단순해 보이지만 꽤 복잡합니다.

일반적인 홈 → 검색 → 상품 상세 → 장바구니 → 주문/결제라는 프로세스에 속하지 않는 예외 케이스와 변형 경로가 많기 때문입니다.

이때 IA로 전체 구조를 보면, 각 단계의 전환과 이탈 지점을 구조적으로 파악할 수 있습니다.

위 사진은 커머스 서비스를 시각화한 IA 예시입니다. 모든 흐름을 한눈에 파악할 수 있습니다.

이처럼 각 화면에서 발생해야 하는 이벤트를 미리 정의해두면, 실제 분석 단계에서 '이 이벤트가 어디서 왔는지' 명확히 정의할 수 있습니다. 또한 서비스가 개편되어도 IA를 기준으로 변경 사항을 추적할 수 있어, 데이터 구조의 일관성을 유지할 수 있습니다.

이처럼 복잡한 사용자 여정 과정을 수반하는 대규모 서비스일수록, IA 설계를 통해 퍼널 설계의 정확도를 높이고 전환율 최적화나 리텐션 분석의 토대를 마련할 수 있습니다.

서비스가 커질수록 이벤트와 프로퍼티는 점점 복잡해집니다.

이때 IA는 전체 서비스의 지도 역할을 합니다. 어떤 화면이 어떤 기능과 연결되는지, 새로운 기능이 추가되면 어디에서 구조가 변하는지를 IA를 통해 빠르게 파악할 수 있습니다.

이런 구조적 기준이 있으면, 이벤트 네이밍, 프로퍼티 정의, 페이지 기준 등 데이터 표준화 작업을 쉽게 검증할 수 있습니다. 결국 IA는 단순한 설계 문서를 넘어, 데이터 분석 유지보수 비용을 줄이는 강력한 도구가 됩니다.

서비스가 커질수록 '어디서 문제가 생겼는지', '이 이벤트가 정확히 어디서 발생했는지'를 빠르게 파악하는 기준이 필요합니다. IA는 바로 그 기준을 만들어주는 작업입니다.

IA를 통해 서비스 흐름을 구조적으로 정리하면, 이벤트 수집 지점을 명확히 파악할 수 있고, 퍼널 설계와 데이터 분석의 정확도를 높일 수 있습니다. 더 나아가 팀 간 커뮤니케이션 비용을 줄이고, 데이터 거버넌스 체계를 탄탄하게 만들 수 있습니다.

결국 IA 설계는 '지금 당장의 효율'을 위한 일이 아닌, 장기적으로 데이터 분석 비용을 줄이기 위한 투자입니다. ‘지속 가능한 데이터 분석 환경' 구축을 시작하고 싶다면, 지금 바로 마티니와 만나보세요.

고객 여정에는 ‘아하 모먼트(Aha Moment)’라는 중요한 순간이 있습니다. 유저가 프로덕트의 핵심 가치를 이해하는 순간입니다.

아하 모먼트를 찾고, 디자인하는 것이 중요한 이유는 아하 모먼트를 통해 목표에 도달하는 데 프로덕트가 어떻게 도움이 되는지 보여주고, 결과적으로 유저가 이탈할 확률을 줄여주기 때문입니다. 아하 모먼트를 파악하기 위해서는 기능 이해, 온보딩 완료와 같은 기본적인 유저 행동을 확인해야 합니다.

이번 아티클에서 더 많은 유저를 장기 고객으로 전환할 수 있는 아하 모먼트란 무엇인지, 그리고 어떻게 아하 모먼트를 찾고, 아하 모먼트로 유저를 유도할 수 있는지 알아보세요.

아하 모먼트는 유저가 프로덕트의 핵심 가치를 파악하고 내면화하는 순간입니다. 활성화(Activation) 모먼트, 유레카 모먼트, 깨달음의 순간(Lightbulb moment)이라고도 합니다. 아하 모먼트는 단일 순간일 수도 있고, 사용자가 프로덕트의 가치를 진정으로 파악할 수 있을만큼 충분히 사용한 시점일 수도 있습니다. 이 갑작스러운 순간은 유저를 활성화시키는 데 아주 중요하며, 일반적으로 유저가 프로덕트에 투자하기로 한 의사결정과 일치합니다.

션 엘리스(Sean Ellis)는 그의 저서 ‘진화된 마케팅 그로스 해킹’에서 아하 모먼트를 ‘유저에게 프로덕트의 유용성이 인식되는 순간, 유저가 핵심 가치를 진정으로 얻을 때’라고 정의합니다. 여기서 핵심 가치란, ‘프로덕트가 무엇을 위한 것인지, 왜 필요한지, 그리고 그것을 사용함으로써 얻을 수 있는 이익은 무엇인지’에 대한 개념입니다.

프로덕트의 아하 모먼트는 만드는 것이 아니라 사용자가 느끼는 것입니다. 아하 모먼트를 만들 수는 없지만 '프로덕트에서 아하 모먼트가 발생할 수 있는 조건'을 만들 수는 있습니다. 프로덕트 팀은 아하 모먼트를 이해하고 더 많은 유저가 아하 모먼트에 도달할 수 있도록 안내해야 합니다.

프로덕트의 아하 모먼트를 알 수 있는 몇 가지 방법을 소개합니다.

유저들은 모두 같은 특성을 갖고 있지 않습니다. 유저는 각자 가지고 있는 니즈와 해결하고자 하는 문제가 다르기 때문에 서로 다른 아하 모먼트를 경험할 수 있습니다. 이러한 아하 모먼트를 알아내려면 유저가 프로덕트를 사용하는 방법과 이유에 따라 서로 다른 페르소나를 파악하고, 그룹화해야 합니다.

몇몇 기업의 경우 유저 세그먼트를 지역과 연령대로 분류합니다. 다른 기업은 유저 역할(엔지니어 vs 디자이너, PM vs 디자이너 등)을 중심으로 세그먼트를 분류하기도 합니다. 유저 세그먼트에 대한 정의를 내리면 각 세그먼트의 라이프사이클을 보다 정확하게 분석할 수 있습니다.

위 질문에 대한 답변은 유저가 프로덕트의 가치를 빠르게 파악하고, 아하 모먼트가 발생하도록 유저를 가이드하는 데 도움을 줄 수 있습니다.

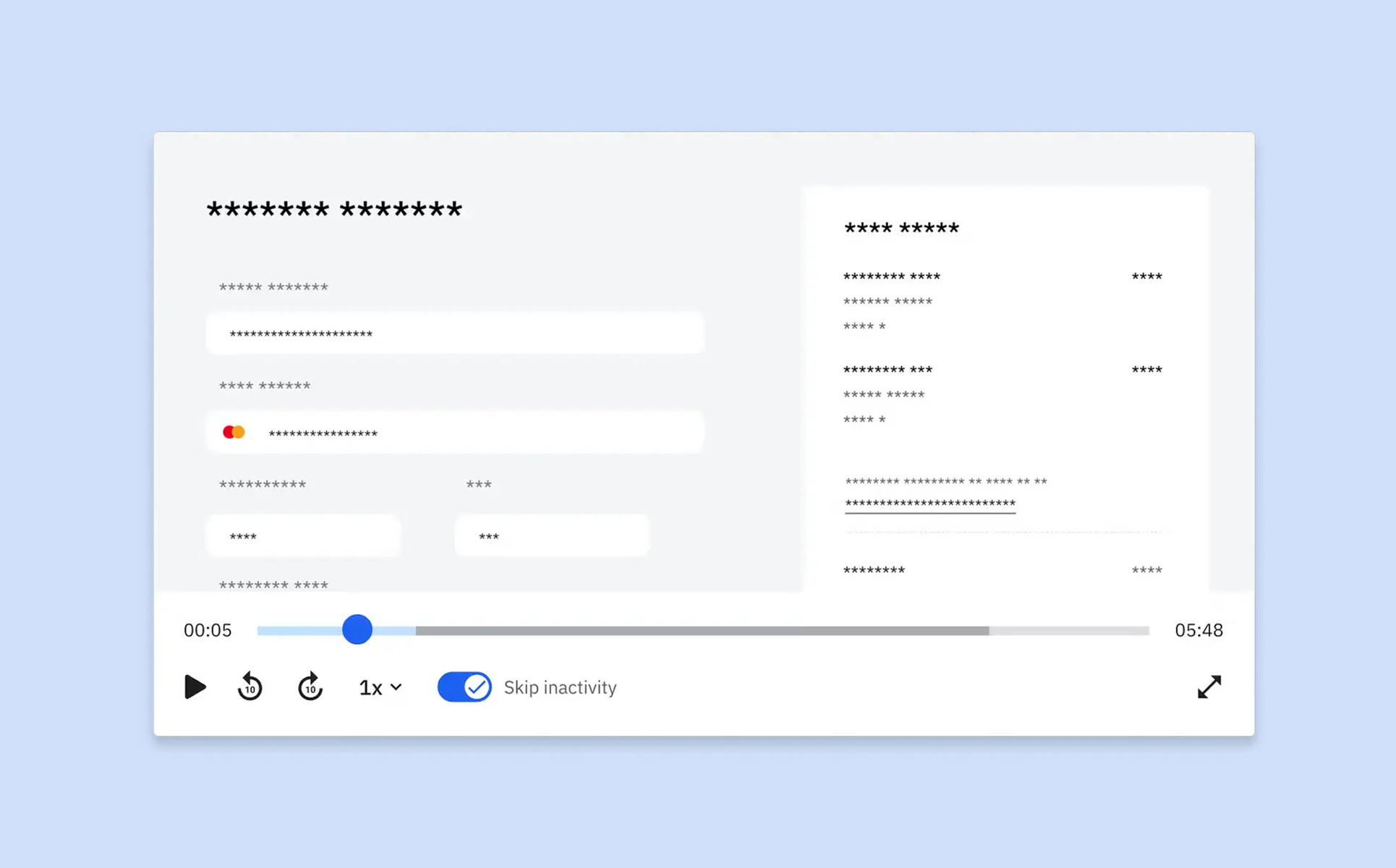

아하 모먼트를 이해하고 최적화하려면 고객 여정 전체를 파악해야 합니다. 앰플리튜드의 ‘세션 리플레이’ 기능은 유저 세션 리플레이(Session Replay)와, 실시간 분석을 결합하여 보여주기 때문에 고객 여정을 쉽게 파악할 수 있습니다.

세션 리플레이를 통해 유저의 ‘돌파구’와 같은 순간을 시각적으로 확인해 보세요. 유저가 인터페이스를 어떻게 탐색하고, 어떤 기능을 주로 사용하며, 어느 시점에 프로덕트에 대한 이해가 높아지는지 관찰할 수 있습니다. 유저 행동을 분석해 아하 모먼트가 발생하는 정확한 지점을 파악하세요. 여기서 유저 경험을 세분화하면 더 많은 유저를 아하 모먼트로 안내할 수 있습니다.

유저 피드백을 사용하여 프로덕트의 아하 모먼트를 발견할 수도 있습니다. 유저의 공감을 불러일으키는 기능을 이해하여 프로덕트 경험을 개선하고, 더 많은 유저에게 이 기능을 안내할 수 있습니다.

분석 도구를 활용해 전환율, 유저 리텐션과 같은 프로덕트 지표를 분석해 보세요. 특정 기능이 선택된 이유, 특정 조건이 적용되는 위치를 통해 리텐션 데이터를 시각화할 수 있습니다. 예를 들어 소셜미디어 앱에서 고객 행동을 분석하면, 처음 며칠 이내에 특정 수의 유저와 연결되는 것이 장기적인 리텐션으로 이어지는 것과 밀접한 관련이 있음을 알 수 있습니다.

프로덕트와 유저에 대한 깊이있는 분석으로 아하 모먼트에 대한 중요한 인사이트를 얻을 수 있습니다. 그러나 ‘선택 편향’을 주의해야 합니다. 예를 들어, 특정 온보딩 플로우를 완료한 유저에게만 초점을 맞추면 그들의 리텐션을 해당 플로우에 대한 기여로만 측정하는 오류를 범할 수 있습니다. 해당 플로우를 건너뛴 유저의 아하 모먼트는 완전히 다를 수 있습니다. 따라서 분석을 할 때에는 다양한 액션과 고객 여정을 포함하여 더 많은 유저에게 리텐션을 유도할 수 있는 아하 모먼트를 정확하게 판단해야 합니다.

아하 모먼트를 정의했다면, 프로덕트에서 유저가 아하 모먼트를 효과적으로 경험하도록 안내해 보세요.

유저를 아하 모먼트로 안내하는 것도 중요하지만 강압적인 전략은 역효과를 낼 수 있습니다. 유저는 정해진 경로대로 따라가는 것을 꺼려하고, 자신의 속도에 맞춰 프로덕트의 가치를 발견하고 싶어하는 경향이 있습니다.

방해가 되는 모달과 툴팁으로 유저 여정을 방해하기보다 직관적인 유저 여정을 설계해 보세요. 잘 설계된 도시에는 명확한 표지판, 유용한 랜드마크, 탐험의 자유를 제공하면서도 목적지까지 쉽게 이동할 수 있는 길이 있습니다.

이와 마찬가지로 프로덕트는 유저가 자연스럽게 아하 모먼트를 경험할 수 있도록 주요 액션과 기능을 부드럽게 연결해야 합니다.

유저를 아하 모먼트로 안내하는 것은 단순히 기능을 보여주는 것이 아닙니다. 새로운 유저가 프로덕트의 핵심 가치를 경험할 수 있도록 명확한 경로를 설계해야 합니다. 이해와 참여를 유도하는 주요 액션과 상호 작용에 우선순위를 두는 ‘유저 저니 맵(User Journey Map)’을 만든다고 생각해 보세요.

사용자를 자연스럽게 안내하는 직관적인 워크플로우를 구축해 보세요. 예를 들어 파일 공유 앱의 아하 모먼트가 ‘어디서든 파일에 액세스 할 수 있다는 것을 인식하는 순간’이라면, 온보딩 플로우를 통해 유저가 다른 장치에서 파일을 업로드하고 액세스할 수 있도록 즉시 유도할 수 있습니다.

프로덕트에 세 가지 일반적인 아하 모먼트가 있다고 가정했을 때, 이 세 가지 순간을 모두 경험하게 하는 것은 어려운 일입니다. 유저가 모든 아하 모먼트에 도달하도록 하는 대신 유저의 의도에 집중해 보세요. 유저가 두 번째 아하 모먼트로 나아가고 있는 것을 발견했다면 그 순간으로 이동시키는 데 집중해야 합니다.

유저의 반응이 예상되는 시점이 있다면 해당 시점에 유저를 안내해야 합니다. 유저가 몇 가지 모달이나 툴팁이 표시되자마자 닫거나 삭제한 경우, 시간차를 두고 다른 내용을 보여주는 것이 효과적입니다.

성공적인 프로덕트는 여러 경험을 통해 유저에게 가치를 제공합니다. 단 하나의 아하 모먼트에만 의존하는 것이 아니라, 유저에게 가치를 제공할 수 있는 다양한 방법을 생각해 보세요.

핵심 가치를 제안하는 주요 아하 모먼트와 유저 참여를 지속할 수 있는 보조 아하 모먼트를 설계하세요. 이를 통해 프로덕트 내에서 여러 경로를 만들어 유저가 프로덕트의 잠재력을 최대한으로 경험할 수 있습니다.

세션 리플레이를 충분히 살펴보면, 프로덕트 내에서 정처 없이 떠돌아 다니는 유저를 발견할 수 있습니다. 유저가 이 지점에 도달하기 전에, 온보딩을 완료하도록 유도해야 합니다. 때로는 유저가 스스로 해낼 수 있도록 도와야 할 때도 있습니다.

‘아하 모먼트’라는 용어는 고객 여정의 다른 성과 지표와 혼동되기도 합니다. 예를 들어, 유저의 원활한 온보딩 경험은 중요하지만 아하 모먼트라고 볼 수는 없습니다. 아하 모먼트는 유저가 프로덕트의 핵심 가치를 처음으로 이해하는 순간입니다. 온보딩 프로세스는 아하 모먼트로 유저를 안내하는 역할이라고 할 수 있습니다.

마찬가지로 단순히 프로덕트 사용 방법을 이해하는 것만으로는 아하 모먼트라고 볼 수 없습니다. 예를 들어 디자인 툴에서 디자인 기능을 이해하는 것은 꼭 필요한 과정이지만, 유저의 아하 모먼트는 툴을 활용해 팀원들과 실시간 협업의 힘을 경험하는 순간일 수 있습니다. 툴팁이나 단계별 온보딩 같은 인앱 가이드도 프로덕트의 가치를 전달하는 데 도움이 될 수는 있습니다. 그러나 아하 모먼트는 이러한 팁의 전달이 아니라 팁을 따를 때 유저가 프로덕트가 왜 필요한지 이해하게 되는 순간입니다.

유저 여정을 분석하여 프로덕트의 아하 모먼트를 정확히 파악해 보세요. 앰플리튜드의 분석 기능은 사용자 경로를 시각화하고, 참여를 유도할 수 있는 주요 기능을 식별하는 데 도움이 됩니다. 퍼널 분석을 사용하여 사용자 이탈 지점을 확인하거나, 여정 분석을 통해 일반적인 액션을 파악할 수 있습니다. 이러한 인사이트를 사용자 리서치와 결합하면 사용자 여정을 최적화하고 더 많은 사용자가 아하 모먼트를 경험하도록 안내할 수 있습니다.

.png)

요즘 물가가 오르면서 패스트푸드를 간편한 한 끼로 즐기는 분들 많으시죠? 그런데 각 브랜드들이 전하려는 메시지가 비슷하면서도 조금씩 다른 느낌을 받으신 적 있으신가요? 이번 시리즈에서는 F&B 브랜드들의 CRM 메시지를 목적별로 비교하고 분석해 드리려고 합니다. 각 브랜드가 어떤 기능을 중심으로 메시지를 전달하는지 함께 살펴보면 더욱 흥미로울 거예요.

[시리즈 목차]

이번 아티클에서는 모바일 앱과 오프라인 매장 연계에 대한 이야기를 나눠보겠습니다.

기존의 프랜차이즈 패스트푸드 브랜드들은 매장 데이터와 온라인 데이터의 통합 관리가 어려웠습니다. 매장별 특성과 문제점을 모두 반영하고, POS 데이터를 온라인과 연계하기 어려웠죠. 그러나 최근에는 지속적인 관리와 개선을 통해 많은 F&B 브랜드들이 매장 데이터를 효과적으로 연계하고 있습니다.

이들은 또한 모바일 앱과 오프라인 매장 데이터를 연계하여 마케팅에 활용해 왔는데요, CRM 마케팅에 있어 활용되는 IT 기술의 대표적인 사례로 모바일 앱 주문 기능과 위치 정보 수집 기능을 들 수 있습니다.

이러한 기능들을 통해 어떻게 고객과의 관계를 강화하고 있는지, 지금부터 자세히 살펴보겠습니다.

모바일 앱 주문 기능은 F&B 브랜드라면 거의 필수라고 할 정도로 모든 브랜드에서 도입하고 있는 기능입니다.

모바일 앱 주문을 통해 매장의 POS 주문 데이터를 온라인상의 멤버십이나 주문 내역 데이터와 매칭시켜 동일한 고객임을 구분할 수 있습니다.

유저를 매칭하여 동일인임을 확인했다면 이제 본격적으로 메시지에 이 데이터들을 활용할 차례입니다. 이제 각 F&B 프랜차이즈 브랜드(A/B/C/D)별로 모바일 앱 주문부터 실제 상품 수령까지의 과정을 비교해 볼게요.

.png)

브랜드 A는 앱 딜리버리 서비스를 자체적으로 운영하지 않고 외부 서비스에 맡기고 있어요. 딜리버리 앱이 별도로 있긴 하지만 활성화되어 있진 않죠. 그래서인지 모바일 앱을 통한 주문 기능에 집중하고 있는 것 같아요.

.jpeg)

.png)

브랜드 B는 주문 현황을 앱 내에 표시하고, 고객이 선택한 픽업 방법에 따라 다른 안내를 제공합니다. 이 표기를 통해 고객에게 이후 과정을 자연스럽게 안내합니다.

.png)

또한 픽업 번호와 주문 번호를 별도의 알림톡으로 발송해 줍니다. 실제로 픽업 번호 안내가 명확해서 매장에서 주문을 찾는 데 어려움이 없었어요. 모든 주문에 대해 유료 채널로 메시지를 발송하면 비용이 부담될 수 있지만, 고객 입장에서는 가장 친절한 방법인 것 같아요.

브랜드 C

.png)

브랜드 C도 모바일 오더와 딜리버리 내역을 앱에서 동시에 제공하고 있어요. 픽업 번호 안내와 주문진행 현황을 실시간으로 확인할 수 있는데요, 조리 중, 조리 완료, 수령 완료 단계로 나뉘어 있어서 매장 데이터와 앱이 잘 연계되어 있음을 보여줍니다.

.png)

브랜드 D 역시 주문진행 현황을 앱 내에서 표시해 줍니다. 자체 딜리버리 서비스를 제공하고 있는데, 배달 예정 시간을 예측하여 안내하는 부분이 인상적이었어요. 다른 배달 앱과 비슷한 예측 로직을 사용하는 것으로 보이는데, 실제로 제품을 받아보는 시간도 예측 시간 범위 내에 들어왔습니다.

.png)

또한 배달이 완료되었을 때 앱 푸시로 알림을 보내주는데요, 배달을 기다리는 고객 입장에서는 메뉴가 언제 도착하는지 실시간으로 알고 싶기 때문에 이런 안내는 매우 유용하다고 생각됩니다. 딜리버리 시스템과 매장 내 POS/조리 상태 데이터, 모바일 앱 주문 데이터가 모두 연동되어 있다는 점을 알 수 있어요.

다음으로는 기기 위치 정보에 기반한 메시지를 살펴볼게요. 네 개의 F&B 브랜드 모두 위치 정보를 수집하고 있는데, 그중 흥미로운 기능과 메시지를 분석해 보았습니다.

.jpeg)

.png)

브랜드 A는 모바일 오더 주문 시 수령 장소 옵션이 다양한 것이 특징이에요. 드라이브 스루 옵션이나 테이블에서 받기 옵션 등이 있는데, 특히 테이블에서 받기 옵션은 고객이 입력한 매장 위치와 테이블 번호를 기반으로 서비스를 제공하기 때문에 오프라인 매장 데이터와 모바일 앱이 잘 연동된 사례라고 볼 수 있어요.

.png)

브랜드 B는 수집한 위치 정보를 이용해 매장 근처에 인접했을 때 매장 방문을 유도하는 앱 푸시를 발송하고 있습니다.

메시지를 살펴보면, 매장의 위치를 상세하게 알려주어 고객이 한 번 더 매장을 눈여겨보고 방문하도록 하는 좋은 사례인 것 같아요.

.png)

브랜드 C는 브랜드 B와 비슷해 보이지만 조금 다른 점을 강조하고 있어요. 브랜드 C는 매장의 위치나 존재를 알리는 것보다 해당 매장에서 판매하는 특정 상품을 소개하는 데 초점을 맞추고 있습니다.

메시지를 보면, 매장 구매 이력이 있는 유저에게 판매하는 특정 상품에 대한 정보를 전달하여 구매를 유도하려는 목적이 강하게 나타나요.

브랜드 D

.png)

마지막으로 브랜드 D입니다.

브랜드 D는 위치 정보를 활용한 CRM 메시지를 발송하지는 않지만, 앱 내에서 각 매장의 혼잡도와 운영 정보를 제공하고 있어요.

점심과 아침 시간대에 확인해 보니, 고객들이 많이 붐비는지, 시간대에 따라 딜리버리 가능 여부를 매장에서 실시간으로 수정할 수 있게 구현되어 있었습니다. 이는 고객 입장에서 대기 시간을 줄이고 더 나은 서비스를 받을 수 있도록 도와주는 좋은 기능이라고 생각됩니다.

이렇게 각 F&B 브랜드들이 강조하는 메시지와 기능들을 살펴보았는데요, 조금 더 이해가 되셨나요? CRM 마케팅은 다양한 경로에서 수집한 데이터를 활용할 수 있다는 점이 가장 큰 장점이자 매력인 것 같아요.

이러한 데이터를 바탕으로 CRM 마케터들은 개인화된 정보를 담은 메시지를 고객들에게 전달할 수 있게 됩니다. 이런 초개인화 메시지는 결국 매출 성장으로 이어지죠. 기계적인 광고 노출에 비해 개인화 요소가 포함된 광고는 피로감이 적게 느껴지기 때문이에요.

본인에게 필요한 정보나 특정한 목적을 가진 광고라면 거부감 없이 받아들였던 경험, 다들 한 번쯤 있으시죠?

저희 마티니 CRM 팀에서는 다양한 기능과 상황에 맞는 메시지를 전달하기 위해 항상 노력하고 고민합니다. CRM 캠페인의 더 자세한 구현 사례가 궁금하시다면, 마티니 CRM 팀의 성공 사례를 확인해 보세요!

데이터마케팅이란 [데이터]를 활용하여 마케팅한다는 뜻으로 데이터드리븐마케팅(Data-driven Marketing)으로도 불릴 수 있습니다.

데이터마케팅과 데이터드리븐마케팅의 차이는 미미하나, 데이터마케팅은 데이터를 [활용] 하나 데이터 드리븐 마케팅은 데이터를 [기반]으로 하기에 후자에서 데이터의 중요성이 좀 더 강조된다고 볼 수 있습니다.

데이터마케팅을 위해서 필수 조건은 (당연하게도) 데이터 분석입니다. 결괏값을 측정하여 데이터를 잘 쌓아두고, 보유한 데이터를 가공하여 상황을 해석하고 문제나 개선점에 대한 인사이트를 도출하는 것이 기본적인 데이터 마케팅의 프로세스라고 할 수 있습니다.

그로스 조직(=그로스팀)은 기본적으로 데이터 드리븐 마케팅을 하기에, 프로세스가 같습니다.

데이터를 기반으로 가설을 세우고, 실험을 바탕으로 검증하고, 배움을 축적하는 과정을 빠르게 반복합니다. (*출처: 양승화 님의 그로스해킹)

![양승화 님의 [그로스해킹] 책을 기반한 이미지 | 그로스 조직이 일하는 방식](https://cdn.prod.website-files.com/656d3c53a795ed37cbbc9e32/66ceb8add44db997abca7b19_66ceb78b6a2e8955782324a8_%25EB%258D%25B0%25EC%259D%25B4%25ED%2584%25B0%25EB%25A7%2588%25EC%25BC%2580%25ED%258C%25851.jpeg)

마티니에서 진행한 컨설팅 프로젝트였던, 패션 커머스를 기준으로 데이터마케팅의 사례를 보겠습니다.

커머스 내에서도 여러 안건의 데이터 분석이 있는데요. 1. 에디토리얼(=콘텐츠), 2. 프로모션 간의 비교 (미드세일 vs 시즌오프세일), 3. 주요 대시보드 (KPI, AARRR) 4. 특정 프로모션 (블랙프라이데이) 등입니다.

블랙프라이데이 프로모션을 세부 사례로 앰플리튜드(Amplitude)를 활용했던 분석을 예시로 들어보겠습니다.

*앰플리튜드는 SaaS(Software as a Service: 클라우드 기반의 소프트웨어 제공 모델) 솔루션으로 웹/앱 서비스 내의 사용자 행동 분석을 할 수 있는 프로덕트 애널리틱스(Product Analytics)입니다.

왜 프로모션 데이터 분석을 해야 할까요? 그 배경부터 먼저 짚고 넘어갑시다.

다양한 형태로 스스로에게 질문을 해봅니다.

Q. 프로모션을 기획하고 운영한 후 가장 궁금한 것은?

Q. 프로모션을 운영한 이유는 무엇일까요?

여러 가설을 세워봅니다.

이렇게 물어보면, 보통은 '셋 다'라고 대답하는 경우가 많은데요. 충분히 이해는 하지만(^^...!) 우선순위는 정해야 합니다. 대개 우선순위는 [매출]이기에, 매출 관련 분석을 먼저 진행합니다.

매출의 기본적인 구성 요소를 먼저 파악합니다.

*건단가와 객단가

건단가와 객단가는 혼용되어 쓰이기도 하는데요. 주문[건]의 건, 고[객]의 [객]을 생각하시면 됩니다.

즉 어제 제가 배민에서 점심 주문 건으로 1.5만 원을 쓰고 저녁 주문 건으로 2.5만 원을 썼다면 일 기준 제 건단가는 [1.5만 원] / [2.5만 원] 두 건일 것이고 제 객단가는 [1.5만 원]+[2.5만 원]의 4만 원이 될 수도 있습니다.

*물론 건단가와 객단가는 내부적으로 정의하기 마련입니다! 일간 건단가를 평균으로 낼 수도 있으니까요.

이에 따라 앰플리튜드(Amplitude)에서 매출, 주문수/건단가, 구매자수/객단가로 그래프를 구성합니다. 우선 매출로 전체적인 추이를 보고 주문수/건단가, 구매자수/객단가를 개별로 쪼개보는 것이죠.

해당 프로모션에서는 객단가와 건단가가 유사한 추이를 보이기에 특이 사항이 없다고 판단되었지만, 가끔 특정 프로모션에서 객단가와 건단가의 차이가 크게 발생하는 경우도 있습니다. (리셀러의 등장?!)

이외 위 그래프에서 두 개의 선이 있는데요. 데이터를 볼 때의 꼭 필요한 [비교 기준]입니다. 비교 기준은 사용자 특성이 될 수도, 행동이 될 수도 있지만 [기간]을 가장 기본적으로 고려합니다.

*비교 기준: 기간(일간, 주간, 월간, 분기, 반기, 연간… 시즌성 고려!

블랙프라이데이 프로모션의 분석이라면 전년도 11월과 비교하는 것 vs 전월인 10월과 비교하는 것 - 어떤 것이 더 합리적일까요? 당연히 전년도일 것입니다.

전월 10월과 당월 11월의 할인율, 마케팅 수준 등이 다를 테니까요. 물론 전년 대비 회원수도 브랜드수도 많아졌고 등의 변동 요인들이 많아 YoY만 비교하는 것이 의미가 없다고 판단된다면 결국 전년도(YoY)/전월(MoM)/전주(WoW) 등 비교 대상들이 많아질 수 있습니다.

현대의 직장인이라면 대개 모든 업무의 결과를 [숫자]로 보긴 합니다. 그렇다면 그냥 숫자를 확인하는 것과 데이터 분석의 가장 큰 차이점은 무엇일까요?

예를 들어 2024년 7월 A 커머스의 구매 전환율 (메인 페이지 조회 > 결제 완료)이 10%라고 했을 때, 어떤 해석을 할 수 있을까요?

전월 대비 높아졌다/낮아졌다, 전년 대비 높아졌다/낮아졌다의 판단을 위해서는 전월 데이터, 전년도 데이터가 필요합니다.

전년, 전월, 전주의 데이터를 보며 추이를 확인했을 때 눈에 띄게 높거나/낮은, 혹은 변동이 생기는 시점을 찾아내어 그 배경이 무엇이었는지 파악하는 것이 필요합니다.

혹은 유사한 프로모션이 진행되었던 시기와 비교하여 구매전환율이나, 구매수, 유입수, 가입수 등의 주요 지표에서 차이가 있었는지를 파악해 보는 것도 좋습니다.

프로모션 vs 프로모션 간의 비교 외에도 uiux를 개선하거나 특정 기능을 배포했을 때 그 시점 이후의 변화가 있는지를 확인할 수 있습니다.

매출을 구매수와 건단가, 구매자수와 객단가로 나눠 전반적인 추이를 파악한 후 세부 분석을 진행합니다.

매출은 결국 [사용자]가 [상품]을 [구매]하여 발생하는 결괏값입니다. 이에 따라 [사용자]와 [상품]의 측면에서도 분석을 진행합니다.

: 카테고리별, 브랜드별, 상품별 매출 추이

프로모션의 매출을 브랜드, 카테고리 등으로 나눠서 확인해 봅니다.

더 개별적으로는 브랜드를 기준으로 매출과 월별 성장률 등을 확인하며 주요 브랜드를 도출하기도 합니다.

프로모션을 진행하고 쌓인 데이터를 분석하고 회고하고 다음 프로모션에 적용하는 것. 그것이 프로모션 측면에서 데이터를 활용한 데이터 마케팅이라고 볼 수 있습니다.

이외 데이터마케팅은 어떤 부문에도 동일하게 적용됩니다. 정량적인 수치로 표현되는 데이터를 쌓고, 데이터를 여러 측면에서 분석하고, 다음 유사 업무 시 배운 점을 적용하고 또 실험하는 것입니다.

MRR 이란?

Monthly Recurring Revenue로 월간 반복 매출 구독형 서비스의 경우 핵심 지표로 활용됩니다.

요즘은 누구나 한 번 쯤은 구독형 서비스를 결제해본 경험이 있을텐데 구독 비즈니스는 사용자가 카드를 등록하면 자동으로 월마다 반복적으로 자동결제가 됩니다. (유튜브 프리미엄 구독, 넷플릭스 등)

MRR 산출 공식은 다음과 같습니다.

예를 들면, 유튜브 프리미엄 월 구독 비용이 10,000원이고 이용자가 10명이라면 MRR 은 100,000원이 되는 겁니다.

그런데 MRR이 100,000원 입니다. 에서 끝나면 안되겠죠?

MRR이 어떻게 변화했는지를 분석하는 것도 굉장히 중요합니다.

MRR 지표를 쪼개보면 아래와 같습니다.

그러면 이 지표를 가지고 우리는 New MRR을 구할 수 있습니다.

실무하면서 MRR calculation 하는데 고생 고생을 했는데 이 방법으로 도움을 받을 수 있는 누군가를 위해 공유합니다.

우선 방법은 DB에 적재된 결제 데이터와 구글 스프레드 시트에서 세금계산서로 처리되는 고객 결제 내역을 바탕으로 Rawdata를 준비하고 파이썬을 활용해서 frequency(월결제, 연결제)를 flatten 해주고 이를 Looker Studio로 시각화해줍니다.

1. DB에서 데이터 불러오기

2. 구글 스프레드시트에서 데이터 불러오기

3. 파이썬으로 데이터 클렌징하기

4. 클렌징한 DB, 스프레드시트 데이터 합치기

5. 클렌징 결과 시각화를 위해 구글 스프레드시트로 보내기

6. Looker Studio로 시각화 하기

아래는 실제 활용했던 MRR 대시보드 입니다.

첫 번째 대시보드는 월매출과, MRR 지표 현황을 살펴보고 고객사별 월간 구독 현황을 확인 해볼 수 있고 ARR, 이번달 예상 매출도 확인 할 수 있게 구성했었습니다.

두 번째 대시보드는 위에서 언급한 대로 MRR 지표를 쪼개서 모니터링하는 대시보드입니다.

이를 통해 MRR 상승하는데 어떤 지표 때문에 상승했는지 한눈에 볼 수 있습니다. 또한 MRR 성장추이도 함께 볼 수 있도록 구성되었습니다. 이제 이 대시보드를 통해서 전사가 우리 서비스의 MRR 현황을 볼 수 있고 이탈한 유저수가 특히 많았던 월에는 고객 인터뷰를 진행해보거나 해당 유저들의 특징을 파악해보면 어떤 지점에서 불편함을 느꼈는지 페인 포인트는 무엇이었는지 원인을 파악하고 제품 개선에 반영해볼 수 있겠죠?

DB에서 결제 데이터를 위의 컬럼만 파이썬 SQLAlchemy 를 활용해서 데이터를 불러옵니다.

SELECT

user_id,

company_name,

sales,

pay_datetime_id,

freq,

user_status

FROM

(SELECT tmp2.user_id,

tmp2.company_name,

tmp2.id,

tmp1.sales,

date_format(tmp1.auth_date, '%Y-%m-01') auth_date,

tmp1.subscription_id,

tmp1.user_status,

tmp1.card_updated_at

FROM

(SELECT B.user_id,

A.sales,

A.auth_date,

A.subscription_id,

A.user_status,

A.card_updated_at

FROM

(SELECT st0.*,

st1.user_status,

st1.card_updated_at

FROM

-- billing_payment_history 테이블에서 조건에 맞는 데이터 가져오기

(SELECT billing_id,

subscription_id,

auth_date,

IF(cancelled_at IS NULL ,amount, IF (amount <= cancellation_cancel_amount,0,cancellation_remain_amt)) AS sales

FROM nicepay_billing_payment_history

) st0

left join

-- nicepay_card_info 테이블에서 가장 최근의 카드 정보(created_at이 최대인)를 가져오며, user_status를 is_deleted와 is_active 값에 따라 ‘churned_user’ 또는 ‘active_user’로 설정

(select t1.billing_id,

t1.created_at,

t1.is_deleted,

t1.is_active,

t1.created_at card_updated_at,

(case when t1.is_deleted = 1 and t1.is_active = 0 then 'churned_user' else 'active_user' END) user_status

from nicepay_card_info t1

inner join (select billing_id,

max(created_at) max_date

from nicepay_card_info

group by 1) t2

on t1.billing_id = t2.billing_id and t1.created_at = t2.max_date) st1

ON (st0.billing_id = st1.billing_id)) A

LEFT OUTER JOIN

(SELECT billing_id,

user_id

FROM nicepay_billing_info) B

ON (A.billing_id = B.billing_id)) tmp1

INNER JOIN (SELECT user_id,

company_name,

id

FROM user

) tmp2

ON (tmp1.user_id = tmp2.user_id)) tmp3

inner join

(select seq,

freq,

date_format(plan_start_datetime_id, '%Y-%m-01') subscription_plan_start_datetime_id

from subscription) tmp4

ON (tmp3.subscription_id = tmp4.seq)

where sales > 0;

먼저 계산을 위해 필요한 데이터를 DB에서 추출해주고 flatten을 해줄껍니다.

flatten이 뭐냐 뜻 그대로 평탄화한다는 의미입니다. 예를들어 고객이 연간 결제를 1,200,000원을 했다고 하면 월별 결제액은 12개월로 나눠서 월별로 데이터를 평탄화 해주는 과정이라고 보시면 됩니다.

#expand the yearly records

mrr_base = mrr_df.loc[np.repeat(mrr_df.index, mrr_df['freq'].map({"years":12,"months": 1}))]

mrr_base.loc[mrr_base["freq"] == "years", "sales"] /= 12

mrr_base.loc[mrr_base["freq"] == "years", "pay_datetime_id"] += \

mrr_base.groupby(["user_id", "freq"]).cumcount().loc[mrr_base["freq"] == "years"]\

.map(lambda i: pd.DateOffset(months=i))

저의 경우 DB에 기록되지 않은 세금계산서 데이터를 가지고 있었는데

해당 데이터는 구글 스프레드시트에 기록하고 있으므로 구글 스프레드시트에서 데이터를 불러옵니다.

#구글 스프레드시트에서 data load하기

scope = ['https://spreadsheets.google.com/feeds',

'https://www.googleapis.com/auth/drive']

credentials = ServiceAccountCredentials.from_json_keyfile_name(

'credential 파일 경로(json파일)', scope)

gc = gspread.authorize(credentials)

spreadsheet_url = "가져올 스프레드시트 주소"

gc1 = gc.open_by_url(spreadsheet_url).worksheet('시트 이름')

#기존에 기록된 데이터 가져와서 리스트 형태로 리턴

gc2 = gc1.get_all_values()

#데이터프레임으로 판다스로 가져오기

gc2 = pd.DataFrame(gc2, columns=gc2[0])

gc2 = gc2.reindex(gc2.index.drop(0))

#날짜 형식으로 변경

gc2['pay_datetime_id'] = pd.to_datetime(gc2['pay_datetime_id'])

#sales 컬럼 숫자로 변경

gc2['sales'] = gc2['sales'].astype(str).astype(int)

#expand the yearly records

gc2_base = gc2.loc[np.repeat(gc2.index, gc2['freq'].map({"years":12, "months": 1, "2years":24}))]

# compute monthly fee and join date

#years 12개월로 나누기

gc2_base.loc[gc2_base["freq"] == "years", "sales"] /= 12

gc2_base.loc[gc2_base["freq"] == "years", "pay_datetime_id"] += \

gc2_base.groupby(["user_id", "freq"]).cumcount().loc[gc2_base["freq"] == "years"] \

.map(lambda i: pd.DateOffset(months=i))

#2years 24개월로 나누기 / years 12개월로 나누기

gc2_base.loc[gc2_base["freq"] == "2years", "sales"] /= 24

gc2_base.loc[gc2_base["freq"] == "2years", "pay_datetime_id"] += \

gc2_base.groupby(["user_id", "freq"]).cumcount().loc[gc2_base["freq"] == "2years"] \

.map(lambda i: pd.DateOffset(months=i))

gc2_base_result = gc2_base[['user_id', 'company_name', 'sales', 'pay_datetime_id', 'freq']]

출처: https://botongsaram.tistory.com/entry/B2B-SaaS-MRR-계산하기 [알랭드보통사람:티스토리]

위의 과정에서 DB에서 불러온 데이터와 구글 스프레드시트의 데이터 형태를 통일 시켰습니다.

이제 Raw Data를 만들기 위해서 합쳐줍니다.

#구글시트rawdata와 DB에서 불러온 데이터의 결합

df_union= pd.concat([mrr_result, gc2_base_result])

데이터를 통합한 다음에 데이터 시각화를 위해 데이터 시각화를 위해 스프레드시트에 최종 정리된 데이터를 다시 구글 스프레드시트로 전달합니다.

# union 된 결과를 다시 구글 스프레드시트로

scope = ['https://spreadsheets.google.com/feeds',

'https://www.googleapis.com/auth/drive']

credentials = ServiceAccountCredentials.from_json_keyfile_name(

'credential 파일 경로(json)', scope)

gc = gspread.authorize(credentials)

spreadsheet_url = '스프레드시트주소

gc_mrr = gc.open_by_url(spreadsheet_url).worksheet('새로 데이터를 업로드할 시트명')

#기존에 기록되어 있던 데이터 삭제(처음 업로드할 때는 필요 없음)

gc_mrr.clear()

# 오늘 가져온 데이터 업로드

gd.set_with_dataframe(gc_mrr,merge)

위의 결과는 MRR 대시보드 예시(1)에서 활용했던 과정입니다.

다음으로 MRR detail view 에 사용될 지표를 만들 차례입니다.

# pay_datetime_id 열에서 월과 연도를 추출하여 새로운 열 생성

mrr_detail_result['month_year'] = mrr_detail_result['pay_datetime_id'].dt.to_period("M")

# max_date 컬럼 만들기

mrr_detail_result['max_date'] = pd.NaT

mrr_detail_result.head()

# user_id를 기준으로 그룹화

grouped = mrr_detail_result.groupby('user_id')

# 각 그룹에서 최대 결제일을 찾고 max_date 열에 할당

for name, group in grouped:

max_date = group['pay_datetime_id'].max()

max_index = group['pay_datetime_id'].idxmax()

mrr_detail_result.loc[group.index, 'max_date'] = max_date

# 데이터프레임을 corporate_id와 pay_datetime_id 기준으로 정렬

transactions_ver2 = mrr_detail_result.sort_values(by=['corporate_id', 'pay_datetime_id'])

# 이전 거래 금액을 저장할 새로운 열 prev_amount 추가

transactions_ver2['prev_amount'] = transactions_ver2.groupby('corporate_id')['sales'].shift(1)

# 사용자 상태를 저장할 새로운 열 user_status 추가

transactions_ver2['mrr_status'] = 'new'

# 이전 거래 금액과 동일한 금액을 가진 사용자에게 'existing' 할당

transactions_ver2.loc[transactions_ver2['sales'] == transactions_ver2['prev_amount'], 'mrr_status'] = 'existing'

# 이전 거래 금액보다 높은 금액을 가진 사용자에게 'upgrade' 할당

transactions_ver2.loc[transactions_ver2['sales'] > transactions_ver2['prev_amount'], 'mrr_status'] = 'upgrade'

# 이전 거래 금액보다 낮은 금액을 가진 사용자에게 'downgrade' 할당

transactions_ver2.loc[transactions_ver2['sales'] < transactions_ver2['prev_amount'], 'mrr_status'] = 'downgrade'

# 이전에 'churned' 상태였고 이제 새로운 거래가 있는 사용자에게 'reactivation' 할당

# 모든 고유한 corporate_id 값을 포함하는 리스트 생성

corporate_ids = transactions_ver2['corporate_id'].unique()

# 각 corporate_id에 대해 루프를 돌며 각 거래의 상태를 업데이트

for corporate_id in corporate_ids:

user_data = transactions_ver2[transactions_ver2['corporate_id'] == corporate_id]

for i in range(1, len(user_data)):

prev_month = user_data.iloc[i-1]['month_year']

curr_month = user_data.iloc[i]['month_year']

if (curr_month - prev_month).n > 1:

transactions_ver2.loc[(transactions_ver2['corporate_id'] == corporate_id) & (transactions_ver2['month_year'] == curr_month), 'mrr_status'] = 'reactivation'

# user_status가 churn_user인 사용자의 마지막 결제일에 'churn' 상태 할당

transactions_ver2.loc[(transactions_ver2['user_status'] == 'churned_user') & (transactions_ver2['pay_datetime_id'] == transactions_ver2['max_date']), 'mrr_status'] = 'churned'

transactions_ver2.head()

이제 MRR 대시보드 예시(2)에 활용된 데이터가 전처리되었고 구글 스프레드시트로 데이터를 적재해주면 됩니다.

이걸 매일 하기는 귀찮으니 Airflow DAG를 활용해서 자동화해주면 됩니다.

여기까지 MRR계산을 위해 SQL, 구글 스프레드시트, python을 활용한 과정을 소개해봤습니다.

누군가 B2B SaaS에서 MRR 계산을 위해 고군분투하고 계시다면 이 코드가 도움이 되시면 좋겠네요

추가로 초기에 대시보드 기획에 많은 참고가 되었던 Baremetrics라는 MRR 대시보드 외산 툴이 있는데 상당히 잘만들었다고 생각되는 서비스입니다.

SaaS 비즈니스를 운영하신다면 참고해보시면 좋을 서비스네요!

분석 데이터의 하위 집합입니다.

사용자, 세션, 이벤트 데이터를 분리해서 세그먼트를 정의하면 분석하고자 하는 대상을 쉽게 정의할 수 있게 만드는 기능입니다.

세그먼트를 정의하게 되면 특정 유저의 그룹 vs 나머지 유저의 특징을 비교 분석해 볼 수 있습니다.

GA4에서 세그먼트 기능을 통해 웬만한 유저들의 특징을 잡아낼 수 있습니다.

그런데 GA4가 어떻게 유저들의 행동 데이터를 수집하고 활용하는지 제대로 알지 못하면 활용하기 힘들겠죠?

이번 글에서는 큰 틀에서 GA4가 어떤 원리로 조건이 설정되는지 알아보려고 합니다.

세그먼트 생성화면을 들여다보면 꽤 많은 조건들을 설정할 수 있는 기능들이 많습니다.

일단 크게 3가지 유형의 세그먼트가 있습니다. (아래 유형에 대한 이해를 잘하셔야 합니다.)

세그먼트 유형 선택은 세그먼트를 조건에 해당하는 결과와 관련이 있는 거라고 생각하시면 이해하시기 쉬울 겁니다.

특히! 각 유형별로 소스 / 매체 선택할 때 주의할 점을 꼭! 숙지하시길 바랍니다!

이렇게 정의는 그럭저럭 이해는 할 수 있지만 역시 예시를 통해 어떻게 데이터가 선택되는지 알아보겠습니다.

특정 유저가 2개의 세션 안에서 몇 가지 이벤트를 발생시켰다고 가정해 보겠습니다.

1. 사용자 세그먼트 예시

사용자 세그먼트 기준으로 구매한 유저를 세그먼트를 만들면 어떻게 데이터가 선택될까요?

총 7개의 이벤트가 모두 선택됩니다. 사용자 기준이니까 조회한 날짜에 있는 이벤트가 모두 포함되기 때문입니다.

2. 세션 세그먼트 예시

최소 한 개의 구매 이벤트가 발생한 모든 세션의 데이터기 때문에 이 기준으로 충족되는 데이터는 purchase(구매) 이벤트가 발생한 session - 2 만 선택됩니다( session - 1 에는 구매 이벤트가 없음)

3. 이벤트 세그먼트 예시

이벤트 기준이면 기준에 맞는 이벤트만 선택한다는 말이기 때문에 session - 2에서 발생한 purchase 이벤트만!! 선택됩니다. 다른 이벤트는 선택 안됩니다!

여기서는 어떤 조건의 유저를 선택할지 셋팅하는 옵션을 선택할 수 있습니다.

여기서 AND, OR 조건을 선택할 수 있는데 회원가입과 구매 이벤트를 발생시킨 유저 선택해 보겠습니다.

그런데 하단에 보면 포함할 조건 그룹 추가라는 버튼이 있습니다.

동일한 방식으로 회원가입과 구매를 한 조건을 설정하면 이렇게 할 수 있죠

즉 하나의 조건 그룹에 회원가입 이벤트와 구매 이벤트를 선택한 것이고 나머지 하나는 두 개의 조건 그룹에 회원가입 이벤트와 구매 이벤트가 각각 설정을 했습니다.

첫 번째 방식과 차이점은 뭘까요? 동일한 결과가 나올까요? 결과는 동일합니다.

???

이게 무슨 말이냐면 그룹 간 영역에서 오른쪽 상단에 보면 사람모양의 드롭다운 버튼이 있습니다.

이걸 클릭하면 조건 범위를 지정할 수 있습니다.

세그먼트 설정할 때랑 동일한 방식이죠? 사용자, 세션, 이벤트 단위로 조건설정이 가능합니다.

세션 및 이벤트 세그먼트에는 조건 지정 범위에 대한 옵션이 더 적습니다. 아래 표는 사용할 수 있는 세그먼트 유형별 조건 범위 간 조합입니다.

다시 예시를 들어볼게요

GA4에서 첫 구매 유저를 따로 이벤트를 개발하지 않으면 특정하기 힘든데 회원가입 후 첫 구매 유저를 세그먼트로 한 번 만들어 보겠습니다.

해당 유저들을 특정하기 위한 필요한 이벤트는 first_visit(첫 방문)과 purchase 이벤트겠죠?

첫 구매 유저를 특정한다고 해도 이를 어떻게 정의하느냐에 따라 결과는 달라집니다! (주의!!)

유저의 행동은 정말 엄청나게 많은 경우의 수로 발생을 하죠.

A유저 : 구매 의사 결정이 빠른 A유저는 동일한 세션 시간 내에서 구매

B유저 : 구매 의사 결정이 느린 B유저는 어제 상품을 처음 둘러보고 내일 구매

이 예시처럼 첫 구매를 동일한 세션 시간내 첫 구매를 한 유저를 특정할 것인지, 세션에 상관없이 첫 구매 유저를 식별한 것인지 정의하기 나름입니다.

첫 구매 유저 세그먼트를 만든다면 어떤 조건을 설정해야 될까요?

사용자 세그먼트를 기준으로 세그먼트를 설정하면 유저의 조건에 해당하지 않는 방문데이터도 포함되게 됩니다.

그러니까 첫 방문 이후 첫 세션에 구매를 하지 않아도 구매를 특정시킨 뒤에 제외 조건을 구매 조건을 2번 이상으로 설정하여 첫 구매한 유저를 식별할 수 있습니다.

그런데 first_visit, 첫 구매 사용자의 방문 데이터만 확인하고자 한다면 사용자 세그먼트가 아닌 세션 세그먼트를 기준으로 동일 세션 내의 조건 범위를 선택하여 세그먼트를 생성해야 합니다.

첫 구매 유저를 모든 세션 범위 조건으로 하여 세그먼트를 생성하고 재구매자(purchase 이벤트가 2번 이상)와 겹치는 부분이 없는지 세그먼트 중복 기능을 활용해 벤다이어그램으로 확인해 보겠습니다.

중복 없이 잘 나뉘었습니다. 이런 식으로 내가 가진 유저의 특징을 세그먼트로 만들어서 비교해 보는 과정이 굉장히 중요한 것 같습니다.

이 개념을 토대로 한 번 만들어 보시면 좋을 것 같습니다.

GA의 세그먼트는 생각보다 할 수 있는 게 많긴 합니다.

하지만 제대로 활용하기 위해서는 위에 설명한 개념들이 잘 정리가 되어 있어야 됩니다.

이번 글을 쓰면서 느낀 건 솔직히 GA4는 사실 Amplitude를 사용해 봤다면 이런게 다 있나 싶을 정도로 불편하고... 뭔가 찜찜한 느낌을 지울 수 없었습니다.

이번 글에서 첫 구매 유저 세그먼트를 예시로 들었는데 GA4에서 First time purchases라는 측정항목이 존재하긴 하지만

이를 세그먼트로 활용은 못합니다... 약간 독립적인 측정항목 같은 느낌입니다.

Amplitude에서는 사실 아주 간단하게 첫 구매 유저를 특정할 수 있는 Historical Count 기능이 있어서.. 아쉬웠습니다.

(물론 제약 조건은 있습니다. 날짜 범위가 시작되기 전 최대 1년까지 기간만 포함됩니다. 그래도 이건 혁명적인 기능!)

본질적으로 GA의 목적은 유저 획득에 초점을 맞춰져 있다면 Amplitude는 Product Analytics 툴로 사용자 행동 분석에 초점이 맞춰져 있긴 합니다. 그래서 목적에 맞지 않아서 해당 기능 개발을 하지 않은 건가 싶기도 합니다.

당장 앰플리튜드를 도입하지 않을 거라면 속 편하게 GA4에서 First Purchase 이벤트 개발을 요청하거나 혹은 일단 소개드린 방식대로 우선 트렌드만 확인하는 용도로 세그먼트를 생성해서 데이터를 분석하시는 걸 권장드립니다.

전 보통 평일 아침에 운동을 하는데, 끝나고 나면 다른 멤버분들과 이야기를 나누게 됩니다. 아무래도 출근 시간이다보니 스몰톡이 직업 쪽으로 흘러갔습니다. [마케팅]을 하고 계신다고 하시더라고요.

반가운 마음에 전 그로스마케팅을 한다 말해더니 모르는 눈치십니다. [퍼포먼스마케팅]을 하시는 거냐 물었더니 그렇다고 합니다. 어떤 매체를 주로 운영하시냐 했더니 말끝을 흐리십니다.

얘기해보니 그 분의 업무는 <인스타그램 계정 육성> 이었습니다. 특정 부문의 콘텐츠만 게재하는 다수의 계정을 생성해서 ~N만의 팔로워를 가진 계정으로 키우고 광고를 받으며 수익화를 하는죠. 즉 [SNS마케팅]이자 [콘텐츠마케팅]이자 [인플루언서 마케팅]입니다. 저 또한 헷갈렸습니다. 이 또한 퍼포먼스 마케팅일까...?

퍼포먼스는 마케팅은 퍼포먼스(Performance)의 실적, 성과라는 뜻에서 파생됩니다. 즉 퍼포먼스 마케팅이란 성과를 확인할 수 있는 마케팅입니다. 성과란 일의 결과를 뜻하고요.

시험을 보고 성적표를 받듯, 마케팅을 하고 이 일에 대한 성적표를 만들 수 있는 것이 퍼포먼스 마케팅입니다. 어떤 요소에서 얼마나 잘했는지에 대해서 수치 기반의 정량적인 기준으로 평가할 수 있는 거죠.

전통적인 마케팅은 주로 ATL (Above The Line)에 속하는 전통적인 매체를 통한 것을 말합니다. TV, 라디오, 옥외 광고, 신문 등이 있겠죠.

이러한 매체들은 몇 명에게 노출되었는지까지는 대략 추산할 수 있지만 실제로 그 중에 몇 명이 어느 정도로 관심을 보였는지를 알 수 없습니다.

즉 TV가 틀어져있는 가구수는 셀 수 있겠지만, 그 가구 내에서 몇 명의 인원이 영상을 보고 있었는지, 다른 일을 하면서 보고 있었는지 아니면 TV 영상에만 집중하고 있었는지, 그래서 TV 광고에 나온 상품을 인지하게 되었는지 상호 작용이 불가능하므로 알기 어렵습니다.

라디오나 옥외광고도 마찬가지로, 라디오가 청취수는 알겠으나 청취수는 청취자수와 일치하지 않고 옥외광고의 경우 그 앞을 지나간 사람들을 추산할 수 있을 뿐입니다. 그러므로 전통적인 마케팅에서의 ATL 매체는 성과를 정확하게 측정하기가 어렵습니다.

그래서 비즈니스에서는 ROI를 묻습니다. 투자금 대비 이익률이죠. (이익-마케팅 비용)/(마케팅 비용)의 수식으로 비용 대비 매출이 아닌 [이익]의 수준을 봅니다.

마케팅에서는 주로 ROAS를 봅니다. (마케팅에 의한 매출)/(마케팅 비용)의 수식입니다. 여기서 주목할 점은 <마케팅에 의한 매출>입니다.

마케팅에 의한 매출 = 마케팅에 의한 성과, 이를 알고 싶었기 때문에 성과(매출)을 측정할 수 있는 퍼포먼스 마케팅이 중요해졌다고 볼 수 있습니다.

특정 브랜드에서 마케팅을 운영한다고 할 때, 사용자는 신규와 기존으로 나눌 수 있습니다. 신규는 우리를 모르는 사람들, 기존은 우리를 아는 사람들로 정의할 수 있겠으나 [안다/모른다]의 상태를 명확하게 구별해줄 수 있는 변인이 필요합니다.

대개 이 상태를 [가입] 행동으로 구분합니다. 즉 이미 우리 브랜드의 회원인 사용자는 기존, 비회원인 사용자는 신규가 되는 것이죠. 이와 같이 신규 사용자를 대상으로 하는 마케팅을 사용자 획득: UA (User Acquisition) 이라고 합니다.

인지도 증대 및 관심 유도에 유효한 [배너 광고]

배너 광고 매체들은 마케터가 아니어도 익숙한 이름들입니다. 말 그대로 '배너'가 노출되어야 하기 때문에 많은 수의 사용자를 확보하고 있는 플랫폼이어야 경쟁력이 있기 때문이죠.

의사결정 및 구매 전환에 유효한 [검색 광고]

A/B 테스트는 원칙적으로 대조군(Control Group)과 실험군(Experimental Group)을 나누어 다른 모든 환경이 동일하다고 할 때, 한 가지의 변인을 다르게 하여 그 변인의 영향도를 실험하는 것입니다.

광고 집행 시, 모든 외부 요인을 통제할 수 없기 때문에 그 부분을 감안하고 광고 셋팅(타겟팅 등)이나 소재를 A/B 테스트 해볼 수 있습니다. 특정 상품의 경우 소재에서 어떤 내용을 강조할지가 주요 테스트 내용이 됩니다. 1. 개발스토리 2. 리뷰 3. USP 4. 가격 등 강조할 수 있을만한 것들을 제일 메인 요소로 활용해보는 것입니다. A/B 테스트는 매우 큰 개념으로 마케팅에서도 매체, 세팅/타겟팅, 소재 기획/제작 등에서 다양하게 적용될 수 있습니다.

1. 인지도 증대 (Awareness)

'트래픽' 캠페인으로도 불립니다. 불특정 다수(오픈타겟, 논타겟)에게 최대한 많은 도달/노출을 이루어 제품의 인지도 향상과 클릭에 의한 유입, 트래픽을 의도합니다.

2. 관심 유도 (Interest)

타겟 세팅 시 관심사를 설정하여, 다른 행동으로 특정 관심사를 가진 것으로 추론되는 사용자들에게 소재를 노출할 수 있습니다. 혹은 관련도가 높은 웹사이트로 노출 위치를 설정할 수 있습니다.

3. 의사 결정 및 구매 전환 (Decision & Action)

구매 의도 있는 상태에서 특정 키워드를 검색했을 시 광고가 노출되거나, 이전에 방문했던 사용자를 대상으로 재방문 등을 유도할 수 있습니다.

배너 광고든 검색 광고든 각 매체를 통해서 광고가 운영이 되면 관심을 가진 사람들이 클릭하여 설정해둔 페이지로 유입됩니다.

이 때, 페이지에 유입된 사용자가 100명이라고 할 때 (이 100명을 정확하게 구분하는 것도 꽤 어려운 일입니다...) 100명이 [배너 광고]를 보고 왔을지 [검색 광고]를 보고 왔을지 [배너 광고]도 보고 [검색 광고]도 보고 왔을지, [배너 광고]만 보고 10일 후에 페이지 주소를 입력해서 들어왔을지...

어떤 채널, 어떤 매체로 들어왔을지 유입 경로를 알고 싶다면 매체에 광고를 세팅할 때 URL에 UTM이라는 변수를 붙여준 후 이를 Google Analytics로 측정해야 합니다.

유상 광고의 경우 모든 광고 매체에서 관리자(Admin) 페이지를 지원하며 성과를 측정하여 보여주는데 굳이 구글 애널리틱스를 봐야하는 이유가 뭘까요?

자사몰에서의 단 한 건의 성과가 메타에서도 성과로 집계하고, 네이버에서도 성과로 집계하고, 구글에서도 성과로 집계될 수 있습니다. 자사몰 데이터 기준 전환 1건이, 광고 관리자 기준 전환 3건이 될 수 있는 것이죠. 그렇기에 매체 별 광고관리자만을 사용해서 성과를 측정하지 않고 웹으로 랜딩되는 경우 구글 애널리틱스(Google Analytics)를 주로 사용하는 것입니다.

광고 매체가 전환에 기여한 기준은 기간과 방식에 따라 달라질 수 있습니다. 기여 기간을 1일로 설정한다면 3일 전 클릭한 성과는 인정되지 않을 수 있습니다. 기여 모델은 라스트 터치, 퍼스트 터치, 멀티 터치 등으로 구분되고 약 일주일 간 광고를 운영했을 때 (메타, 네이버, 구글 등)

- 사용자가 구매하기 전 마지막으로 누른 광고 매체가 가장 크게 기여했다고 한다면 > 라스트 터치 (Last touch) 모델,

- 사용자가 구매하기 전 처음으로 누른 광고 매체가 가장 크게 기여했다고 한다면 > 퍼스트 터치 (First touch) 모델입니다.

그에 따라 MMP(Mobile Measurement Partner)로 통칭되는 Appsflyer, Airbridge, Adjust와 같은 SDK를 붙이는 등의 추가 tracker가 필요합니다.

보통은 이 부분에서 가장 많은 어려움을 겪습니다. GA와 MMP, 여기서 CRM 솔루션(Braze, Insider 등) 이나 PA(Product Analytics: Amplitude, Mixpanel 등) 솔루션까지 쓴다면 솔루션 내의 데이터 정합성을 맞추는 것 등의 관리가 복잡해지기 때문입니다.

마케팅 웹(Web) 캠페인의 성과는 웹페이지로 랜딩되기에 GA만으로도 측정이 수월합니다. 문제는 앱설치를 목표로 앱스토어로 랜딩시키면서 시작됩니다. 그래서 보통 앱 성과 데이터를 측정하기 위핸 MMP (앱스플라이어/Appsflyer, 에어브릿지/Airbridge, 애드저스트/Adjust 등)을 도입하는데요.

위의 데이터파이프라인 예시처럼, 구글 애널리틱스의 웹 데이터 앱스플라이어의 앱 데이터, 기타 광고 매체들의 광고 데이터를 모아 구글 빅쿼리에 적재하고 이를 태블로를 통해서 대시보드로 제작합니다.

다양한 시각적 형태로, 다양한 성과를, 다양한 차원으로 볼 수 있습니다. 커머스의 배너 성과를 볼 수도 있고, 상품/카테고리/브랜드의 매출 성과를 볼 수 도 있고, 광고 성과를 볼 수도 있습니다. 유입된 광고 매체에 따라 유저들의 LTV로 대변되는 충성도가 다른지도 확인할 수 있고요.

처음의 의문으로 돌아가자면, 인스타그램 계정 키우기도 어떤 측면에서는 퍼포먼스 마케팅으로 볼 수 있겠습니다. '측정'이 가능하기 때문입니다. 콘텐츠를 올리면서 올라가는 팔로워수, 피드의 좋아요수 및 댓글수 그리고 릴스의 조회수 등으로 계정의 성장을 숫자로 '측정'할 수 있습니다.

최근 읽은 '순서 파괴'라는 책에서 인상 깊게 읽은 부분이 있습니다. 아마존의 주요 구성원들이 아마존의 일하기 방식에 대해서 쓴 책입니다.

아마존에서는 목표를 설정할 때 아래 다섯 개 요소를 반영한다고 합니다.

이 중 저에게 가장 와닿았던 것은 측정에 관한 것이었습니다.

.png)

Google Analytics를 사용해 보셨다면 ‘세션’이라는 용어에 익숙하실 것입니다. Universal Analytics(GA3)에서는 세션 단위로 데이터를 수집하여 지표를 측정했지만, GA4에서는 데이터 수집 방식이 달라져 주의가 필요합니다. GA4의 세션 관련 지표는 혼란을 일으킬 수 있습니다.

이번 글에서는 세션의 개념을 자세히 살펴보고, GA4에서의 세션이 어떻게 다른지 알아보겠습니다.

세션 관련해서 구글 가이드 문서에 따르면

- 세션은 사용자가 웹사이트 또는 앱과 상호작용하는 기간입니다.

- 세션은 사용자가 앱을 포그라운드에서 열거나 페이지나 화면을 보고 현재 활성화된 세션이 없는 경우 시작됩니다.

- 세션 수 : 고유 세션 ID 수를 추정하여 사이트나 앱에서 발생하는 세션 수를 계산합니다.

예를 들어 유저가 브라우저 탭에서 페이지를 열고 이메일을 확인하거나 다른 일을 하다가 2시간 뒤에 다시 돌아와서 브라우징을 할 수 있겠죠? GA4에서는 이를 페이지 뷰가 있는 세션으로 보고 2시간 뒤에 사용자 참여로 간주하고 새로운 세션으로 기록합니다.

1. 첫 번째 세션:

2. 두 번째 세션:

이때 새로운 세션이 시작되지만 페이지 조회 이벤트는 기록되지 않습니다.→ 두 번째 세션이 사용자 참여로만 기록됩니다

빅쿼리로 실제 어떤 케이스인지 특정 유저의 로그를 한 번 확인 해보겠습니다.

이렇게 페이지뷰 이벤트가 없는 두 번째 세션이 생기며, 이는 참여율(Engagement Rate) 지표로 나타납니다.

참여율 = 참여 세션 수 / 총 세션 수

이런 유저가 많아지면 세션 기반의 지표(예: 세션당 페이지뷰, 세션당 평균 참여시간)가 낮아집니다.

세션당 페이지뷰 수 계산 예시:

페이지뷰 수 / 세션 수 = 10 / 1 = 10

위와 같은 유저의 행동이 늘어나면:

페이지뷰 수 / 세션 수 = 10 / 2 = 5

페이지뷰 이벤트가 포함되지 않은 세션이 발생하니 지표가 감소하게 됩니다.(분모가 커지므로)

따라서 GA3에서 사용하던 세션 기반의 지표는 주의해서 사용해야 하며, 이벤트나 참여 관련 지표(참여 세션)를 보는 것이 좋습니다.

(GA4와 GA3의 데이터 수집 방식도 다릅니다)

자.. 그리고 또 있습니다.

세션 데이터의 현실.. 빅쿼리를 열어보면 .. 더 조심해야겠구나 라는 생각이 들겁니다.

일단 절대 세션수 ≠ session_start 이벤트의 수 가 아닙니다.

왜그런지 직접 조회해보죠!

아래 특정 유저의 세션을 특정해서 조회해봤습니다.

event_name 컬럼에 session_start 이벤트는 없고 다른 이벤트만 있죠?

이런 상황은 빈번하지 않지만 발생할 수 있습니다. 하나의 세션에 두 개의 세션 이벤트가 발생했고, 심지어 사용자 아이디도 다릅니다.

GA4 인터페이스에서는 당연히 단일 세션으로 계산하지 않을 것 같지만 빅쿼리에서는 이런 케이스 때문에 user_pseudo_id와 ga_session_id를 조합해서 각 세션에 대한 고유 식별자를 만들어서 session 을 카운팅 해야됩니다.

concat(user_pseudo_id, (select value.int_value from unnest(event_params) where key = 'ga_session_id')) as session_id,

GA3에서는 세션 윈도우(30분)가 지나면 완전히 새로운 세션이 시작되지만, GA4에서는 기존 세션이 계속 되기 때문에 이렇게 소스가 1개 이상 발생할 수 있습니다.

구글 애널리틱스에서도 세션수를 집계할 때 추정값을 사용합니다.

실제로 빅쿼리에 count(distinct ga_sesssion_id) 를 집계하면 성능에 영향을 줍니다..

그런데 전 세계에서 이걸 조회하는데 이걸 진짜 집계를 ?? 불가능하죠

그래서 HyperLogLog ++ (가이드 링크)라는 알고리즘을 적용해서 추산한 값을 보여줍니다.

실제로 성능을 눈으로 확인해보죠

ga_session_id를 고유하게 카운팅 해보는 쿼리로 비교를 해보겠습니다.

COUNT(DISTINCT ga_session_id)

HLL_COUNT.EXTRACT(HLL_COUNT.INIT(ga_session_id, 14))

차이가 보이시나요? (참고로 데이터 하루치만 조회했고 쿼리 결과는 같습니다)

모든면에서 더 효율적인 처리를 하고 있음을 알 수 있습니다.

사실 GA4에서는 세션이라는 개념은 더 이상 의미가 없고 지금까지 위의 예시를 통해 확인할 수 있었습니다.

그럼에도 세션 지표를 무조건 써야된다면 참여 세션지표를 사용하는게 좋습니다.

이제 이걸 통해서 다음 글에서는 GA4의 꽃 세그먼트 분석에 대해서 알아보겠습니다.

(세그먼트 기능을 쓰려면 세션에 대한 이해가 꼭 필요하기 때문에 이번 글부터 시작하게 되었습니다.)

디지털 전환이란 무엇일까요? DT 또는 DX로도 불리는 디지털 전환은 Digital Transformation에서 유래했습니다. 여기서 Transformation, 전환은 상태의 변화를 말합니다. 즉 디지털이 아니던 것이 디지털 상태로 변화하는 것입니다.

디지털 전환, 어쩐지 거창합니다. 마티니의 그로스팀에서 큰 규모의 회사를 방문했을 때 주로 DX실, DT실이 명함에 기재된 경우가 많더라고요. 즉 큰 곳에서 시도하는 경우가 많다는 것이겠죠.

온라인 비즈니스는 진행 중입니다. 오프라인을 온라인으로 전환시키는 DX와 DT는 상당수 진척되었습니다. 평범한 일상만 생각해 봐도 그렇습니다.

즉 현재의 디지털 트랜스포메이션, 디지털 전환(DT, DX)의 주요 과제는 오프라인의 온라인 전환은 아닌 듯합니다.

우리 프로덕트의 사용자가 10명, 100명, 1,000명일 때는 수기가 가능할 수 있습니다. 10명에게는 매일 전화를 할 수도 있을 것이고, 100명에게는 문자를 보낼 수 있을 것이고, 1,000명까지는 어떻게 수기로 그룹화를 해서 카카오톡을 보낼 수도 있겠죠.

하지만 [10,000명] 에게는요? [100,000명] 에게는요? 예를 들어보겠습니다.

[CRM마케팅/수동]

#1 보유한 데이터베이스(DB)에 접근하여

#2 조건에 맞는 쿼리문을 작성하여#3 '고정된 시점'의 사용자 데이터를 추출함

#4 성과 분석 시, 동일 프로세스를 거쳐 특정 시점의 사용자 데이터를 재추출함

#5 엑셀 등을 활용하여 수기로 데이터 값을 비교함

[CRM마케팅/자동] *솔루션 활용

#1 보유한 데이터베이스(DB)를 CRM 솔루션의 클라우드에 연동하고

#2 CRM 솔루션의 어드민에서 변수를 조절하여 (클릭!)

#3 '실시간'으로 사용자 데이터를 추출함

#4 성과 분석 시 어드민에서 변수를 조절하여 (클릭!)

#4 솔루션에서 제공하는 대시보드/그래프 형태로 데이터 값을 비교함

[퍼포먼스마케팅/수동]

#1 광고 매체 별 광고관리자에서 성과를 엑셀로 다운로드 후

#2 보고용으로 맞춰둔 엑셀 형식에 맞춰 복붙 합니다. (ctrl+C, ctrl+V)

*매체 A, 매체 B, 매체 C, 매체 D.... 매체를 많이 쓸수록 이 절차는 많아집니다.

**혹시 글로벌이라면? 국가별로도 쪼개줘야 합니다.

***신규 사용자와 기존 사용자의 리타겟팅을 나눈다고요? 이것도 쪼개서...

#3 매체 성과와 자사 내부 DB 성과의 숫자가 맞지 않습니다.

기여 모델 및 기여 기간의 설정이 다르거나...

[퍼포먼스마케팅/자동]

#1 광고 매체 별 데이터를 연동합니다.

#2 광고 매체와 MMP, CRM 솔루션의 데이터를 통합합니다. (DW)

마케팅 업무 자동화, 마케팅 오토메이션(Automation)의 효율에 대해서 이야기를 종종 하게 되는데요. 업무 효율성을 높이는 것이 수익 상승에 기여하지는 않는단 의견을 종종 듣습니다.

문제 정의와 해결 방안 제시 및 대응. 문제 해결자(problem-solver)라는 직무도 존재하는 것처럼 사실 모든 직업은 분야와 내용과 형식이 다를 뿐, 어떠한 문제를 해결하는 것 아닐까요?

위의 사례로 들었던 CRM 메시지 수신자 추출도, 퍼포먼스마케팅 성과 분석도 고객(사용자)이 아닌 실무자에게 필요한 디지털 전환, 즉 마케팅 자동화의 일환인데요.

여러 기업들의 디지털 전환을 도우면서 가장 기본적이지만 가장 중요했던 것은 바로 '측정'입니다. 웹과 앱에서의 성과 측정을 위해 필수적인 것, 바로 UTM입니다.

웹페이지의 주소인 URL에 UTM 파라미터를 넣어 유입된 사용자들이 어떤 경로로 들어왔는지 파악할 수 있습니다.

보통 퍼포먼스 광고를 운영할 때 페이스북 광고관리자의 구성에 맞추어 캠페인/그룹/소재 단으로 구성하는 경우도 있습니다.

유상 광고(paid media)를 운영하는 퍼포먼스마케팅 외에, 인플루언서 마케팅(earned media)이나 유튜브/인스타그램/블로그 등에 자체 콘텐츠(owned media)를 게재할 때도 UTM을 삽입한 URL을 활용하면 좋습니다!

개인화 추천 시스템: 고객의 과거 구매 내역 및 검색 기록을 바탕으로 맞춤형 제품 추천

챗봇 및 가상 어시스턴트: 고객 문의 및 지원을 자동화하여 실시간으로 대응

고객 세그멘테이션: 고객 데이터를 분석하여 세분화된 마케팅 전략 수립

실시간 데이터 분석: 판매, 트래픽, 재고 등의 데이터를 실시간으로 분석하여 빠른 의사 결정 지원

스케일러블 인프라: 트래픽 변동에 유연하게 대응할 수 있는 클라우드 기반 인프라.

클라우드 기반 CRM: 고객 관계 관리 시스템을 클라우드에서 운영하여 언제 어디서나 접근 가능.

모바일 최적화 웹사이트 및 앱: 모바일 사용자를 위한 최적화된 사용자 경험 제공.

모바일 결제 시스템: 다양한 모바일 결제 옵션 지원.

온라인 및 오프라인 데이터 통합: 고객의 온/오프라인 행동 데이터를 통합하여 일관된 경험 제공.

클라우드 컴퓨팅, 증강 현실 (AR), 사물 인터넷 (IoT), 결제 기술, 로봇 프로세스 자동화 (RPA) 등이 디지털 전환에 필요한 주요 기술로 여겨집니다.

디지털 전환을 검색하면 정말 방대한 의미의 내용들이 나옵니다. 클라우드 컴퓨팅, 인공지능(AI)과 머신러닝(ML), 빅데이터 분석, 사물인터넷(IoT), 블록체인, 사이버 보안 등이 대표되는 단어죠.

생각해 보면 그로스 컨설팅이라고 꼭 디지털 전환이 완료된 상황에서만 될 수 있는 것은 아닙니다. 어느 영역의 디지털 전환이 그로스 컨설팅의 실행 방안이 될 수도 있는 것이죠.

Chat GPT가 생활화되고 AI에 대한 기사가 쏟아지는 요즘이지만, UTM을 잘 쓰는 것도 생각보다 어렵습니다. 디지털 전환을 위해 AI 도입보다 먼저인 것들이 있지 않을까요?

이 글을 읽고 계시다면 코호트 분석을 이미 하고 계실 건데 측정 기준에 대해서 의문이 생기신 분이 보실 것 같네요

구글에 '코호트 분석 SQL' 라고 검색하면 정말 많은 글들이 많습니다.

글에서 소개하는 쿼리 예시는 대부분 datediff함수를 활용해서 Date Granularity를 계산합니다.

이해하기 쉽게 예를 들어보겠습니다.

유저 1 : 23:30 에 회원가입 후 다음날 다시 들어왔습니다.

유저 2 : 13:30에 회원가입 후 다음날 다시 들어왔습니다.

day 단위로 계산을 하면 유저 1 은 우리 서비스를 30분 경험하고 다음날 재방문했다고 계산됩니다.

유저 2는 약 10시간 30분 서비스를 경험하고 재방문을 했다고 계산됩니다.

동일한 조건일까요? 그렇지 않죠?

만일 시간 단위로 계산을 하게 되면 특정 행동을 수행한 시간부터 다음 행동까지의 Time window를 24시간 뒤로 하면 이 유저는 다음날이 아닌 모레 재방문했다고 계산되겠죠?

DATEDIFF( [first_event_dt], [second_event], DAY )

DATEDIFF( [first_event_dt], [second_event], HOUR ) / 24 )

월단위로 계산할 때도 마찬가지입니다.

월별 일자수가 모두 다릅니다. 1월(31일), 2월(28일), 4월(30일)...

월 단위로 측정할 때도 30일로 모두 통일해줍니다.

DATEDIFF( [first_event_dt], [second_event], HOUR ) / 24 * 30)

이렇게 계산되면 유저별로 경과 시간은 모두 통일 되었습니다!!

실제로 Amplitude(앰플리튜드)의 코호트 분석 기능에는 이런 기능들이 존재합니다. 만약 안 쓰고 계시다면 직접 쿼리를 날려서...

여기 가이드를 보시면 앰플리튜드가 24시간 단위로 경과 시간을 측청 하는 방식을 설명해 두었습니다.

24시간 윈도우 기준, 캘린더 기준으로 경과 시간(t)을 측정하는 옵션이 있죠?

얼마나 차이를 보였는지 가상의 데이터로 확인을 해보았습니다.

(참고로 더미 데이터는 kaggle 이나 Mockaroo 에서 생성하실 수 있습니다)

참고로 해당 데이터 계산 기준은 월별 첫 구매 기준 재구매율입니다.

t = 1 지점부터 차이를 보이기 시작하는데 t = 0 이 100%라서 차이가 잘 안 보입니다. 로그 스케일을 통해 다시 확인해 보면

확실히 달력 기준의 리텐션율이 조금 더 높아 보이네요

얼마나 차이 나는지 두 기준의 리텐션율을 나눠 보겠습니다 최대 1.27배까지 납니다. (아래 차트에서는 0은 무시합니다. t = 0 은 100%이기 때문에)

t = 1 : 1.15배

t = 22 : 1.27배

데이터에 따라서 차이가 달라지겠지만

코호트의 기준이 만일 회원가입일 기준의 재구매율이거나 회원가입일 기준 재방문율을 측정한다면 더 많은 차이를 보일 수 있을 걸로 예상됩니다.

제가 사용한 쿼리는 아래와 같습니다.

WITH tb_pay_first AS (

SELECT country

,user_id

,min(pay_datetime_id) first_pay_datetime_id

FROM order

GROUP BY 1,2

)

, tb_base_ AS (SELECT st0.*

, FLOOR(TIMESTAMPDIFF(HOUR, st1.first_pay_datetime_id, st0.pay_datetime_id) / 24) AS days_since_first_pay

, FLOOR(TIMESTAMPDIFF(HOUR, st1.first_pay_datetime_id, st0.pay_datetime_id) / (24 * 30)) AS months_since_first_pay_period_24h

, (YEAR(pay_datetime_id) - YEAR(first_pay_datetime_id)) * 12 + (MONTH(pay_datetime_id) - MONTH(first_pay_datetime_id)) AS months_since_first_pay_period_day

, st1.first_pay_datetime_id

FROM order st0

LEFT JOIN tb_pay_first st1

ON st0.user_id = st1.user_id

AND st0.country = st1.country

WHERE 1 = 1

)

, tb_base_24h AS (

SELECT time_id_

, country

, since_time_period_24h

, CASE

WHEN 'acc' = 'normal' THEN SUM(SUM(IF(since_time_period_24h = max_since_time_period_24h, repurchase_user_cnt, 0))) OVER

(PARTITION BY time_id_, country ORDER BY since_time_period_24h DESC RANGE BETWEEN UNBOUNDED PRECEDING AND CURRENT ROW)

ELSE SUM(repurchase_user_cnt)

END AS repurchase_user_cnt

, count(1) pay_user_cnt

, sum(sales) AS sales

FROM (SELECT *

, CASE WHEN since_time_period_24h = 0 AND pay_cnt > 1 THEN 1

WHEN since_time_period_24h = 0 AND pay_cnt <= 1 THEN 0

ELSE 1

END AS repurchase_user_cnt

, MAX(since_time_period_24h) OVER (PARTITION BY country, user_id) as max_since_time_period_24h

FROM

(SELECT tmp0.time_id_

, tmp0.country

, tmp0.since_time_period_24h

, tmp0.user_id

, SUM(tmp0.pay_cnt) AS pay_cnt

, SUM(tmp0.sales) AS sales

FROM

(SELECT DATE_FORMAT(first_pay_datetime_id ,'%Y-%m-01') time_id_

, country

-- , months_since_first_pay_period_day AS since_time_period_day

, months_since_first_pay_period_24h AS since_time_period_24h

, user_id

, COUNT(distinct order_id) AS pay_cnt

, SUM(sales) as sales

FROM tb_base_

-- WHERE DATE_FORMAT(first_pay_datetime_id ,'%Y-%m-01') >= '2023-01-01'

GROUP BY 1,2,3,4) tmp0

GROUP BY tmp0.time_id_

, tmp0.country

, tmp0.since_time_period_24h

, tmp0.user_id

) tmp

) tmp1

GROUP BY time_id_

, country

, since_time_period_24h

)

, tb_base_day AS (

SELECT time_id_

, country

, since_time_period_day

, CASE

WHEN 'acc' = 'normal' THEN SUM(SUM(IF(since_time_period_day = max_since_time_period_day, repurchase_user_cnt, 0))) OVER

(PARTITION BY time_id_, country ORDER BY since_time_period_day DESC RANGE BETWEEN UNBOUNDED PRECEDING AND CURRENT ROW)

ELSE SUM(repurchase_user_cnt)

END AS repurchase_user_cnt

, count(1) pay_user_cnt

, sum(sales) AS sales

FROM (SELECT *

, CASE WHEN since_time_period_day = 0 AND pay_cnt > 1 THEN 1

WHEN since_time_period_day = 0 AND pay_cnt <= 1 THEN 0

ELSE 1

END AS repurchase_user_cnt

, MAX(since_time_period_day) OVER (PARTITION BY country, user_id) as max_since_time_period_day

FROM

(SELECT tmp0.time_id_

, tmp0.country

, tmp0.since_time_period_day

, tmp0.user_id

, SUM(tmp0.pay_cnt) AS pay_cnt

, SUM(tmp0.sales) AS sales

FROM

(SELECT DATE_FORMAT(first_pay_datetime_id ,'%Y-%m-01') time_id_

, country

, months_since_first_pay_period_day AS since_time_period_day

-- , months_since_first_pay_period_24h AS since_time_period_24h

, user_id

, COUNT(distinct order_id) AS pay_cnt

, SUM(sales) as sales

FROM tb_base_

GROUP BY 1,2,3,4) tmp0

GROUP BY tmp0.time_id_

, tmp0.country

, tmp0.since_time_period_day

, tmp0.user_id

) tmp

) tmp1

GROUP BY time_id_

, country

, since_time_period_day

)

, cohort_base_24h AS

(SELECT time_id_

, country

, since_time_period_24h

, repurchase_user_cnt

, pay_user_cnt

, sales

, SUM(sales) OVER w AS acc_sales

, FIRST_VALUE(pay_user_cnt) OVER w AS cohort_user_cnt

, COUNT(1) OVER (PARTITION BY country) AS cohort_cnt

FROM tb_base_24h

WINDOW w AS (PARTITION BY time_id_, country ORDER BY since_time_period_24h RANGE BETWEEN UNBOUNDED PRECEDING AND CURRENT ROW

)

)

, cohort_base_day AS

(SELECT time_id_

, country

, since_time_period_day

, repurchase_user_cnt

, pay_user_cnt

, sales

, SUM(sales) OVER w AS acc_sales

, FIRST_VALUE(pay_user_cnt) OVER w AS cohort_user_cnt

, COUNT(1) OVER (PARTITION BY country) AS cohort_cnt

FROM tb_base_day

WINDOW w AS (PARTITION BY time_id_, country ORDER BY since_time_period_day RANGE BETWEEN UNBOUNDED PRECEDING AND CURRENT ROW

)

)

SELECT *

, (pay_user_cnt * 100) / cohort_user_cnt AS retention_rate

FROM

(SELECT 1 AS time_id

, country

, since_time_period_24h

, SUM(repurchase_user_cnt) AS repurchase_user_cnt

, SUM(pay_user_cnt) AS pay_user_cnt

, FIRST_VALUE(sum(cohort_user_cnt)) OVER(PARTITION BY country RANGE BETWEEN UNBOUNDED PRECEDING and CURRENT ROW) as cohort_user_cnt

FROM cohort_base_24h

GROUP BY 1

, country

, since_time_period_24h) tmp3분석의 기준은 굉장히 중요합니다. 어떤 기준으로 분석하느냐에 따라서 의사결정 방향이 달라질 수 있겠죠?

코호트 분석은 시간을 계산해서 집계하는 분석인만큼 시간의 기준을 제대로 설정하는 게 중요합니다.

저도 실제로 분석해 보면서 분석 기준의 중요성을 다시 한번 깨달을 수 있었습니다.

혹시 지금 day 단위로 코호트 활용해 재구매율을 측정하고 계신다면 24시간 단위로 계산해 보시면 어떨까요?

Reference

https://medium.com/@paul.levchuk/how-to-build-user-cohort-properly-b70a74e5e1c8

Modern Growth Stack, 모던 그로스 스택으로 디지털 마케팅 솔루션 에어브릿지(Airbridge)와 브레이즈(Braze), 앰플리튜드(Amplitdue) 등을 다루는 AB180이 개최하는 디지털 마케팅 세미나입니다.

https://www.moderngrowthstack.com/speaker

이번 MGS 2024는 'FUTURE OF GROWTH'라는 주제로 2024.07.31 (수) 9시부터 18시까지 서울 코엑스 1층 그랜드볼룸 & 2층 아셈볼룸에서 진행됩니다.

디지털 마케팅 분야에서 MGS만큼 큰 규모로 개최되는 세미나는 3개+ 정도 있습니다.

1. MGS: Modern Growth Stack by AB180

2. The Maxonomy by CJ Maxonomy

3. MAX Summit by 모비데이즈(MOBIDAYS)

2022년에는 맥스서밋에서 발표를 했었고("온택트 시대, 푸드 테크 기업의 新 마케팅 전략"), 2023년에는 The Maxonomy에서 마티니의 발표 자료("마케팅하는데 개발이 왜 문제일까?")를 만들었고 2024년은 MGS에 마티니의 일원으로 참가하는데요.

MGS와 같은 대형 세미나를 가면 보통 한 장소에 홀이 여러 개 (main, sub1, sub2...) 있고 세션이 나눠서 진행됩니다. 관심사에 맞는 세션을 들으러 시간마다 자리를 이동하곤 하고요.

세션은 다양합니다.

인하우스(브랜드나 플랫폼)에서 마케팅 전략 및 실행안에 대한 인사이트를 나눌 때도 있고 솔루션사(Amplitude, Braze, Airbridge 등 PA, CRM, MMP Soltuion)에서 솔루션의 이점에 대해서 말하기도 하고요. 광고 플랫폼이나 대행사, 컨설팅사 등 주제와 연사도 다양하고 그에 따라 내용과 난이도도 다채롭습니다.

2024년 연사진만 슬쩍 봐도 구글(Google), 메타(Meta), X(엑스: 구 트위터 twitter), 커니(Kearny) 등의 광고 플랫폼들과 컨설팅사 및 29CM 등의 인하우스 눈에 띄네요.

디지털 마케팅 분야에서 유명한 AB180, CJ Maxonomy, 모비데이즈가 개최하는 세미나들인 만큼 운영하는 세션의 주제만으로도 트렌드를 파악하기 충분합니다. 오늘은 MGS 2024의 세션을 통해 최근의 마케팅 트렌드가 무엇인지 알아보려고 합니다.

우선 AB180측에서 분류해 둔 키워드는 #글로벌, #애드테크·마테크, #트렌드 #프라이버시 #게임 #제품분석 #AI #MMP #UA #크리에이티브 #풀퍼널마케팅 #CRM #수익화 등입니다.

키워드가 좀 많다 보니, 세션들을 확인하고 좀 더 포괄적으로 공통되는 주제로 분류하자면 아래 4개의 카테고리 정도입니다. 관련 주제에 어떤 세션들이 준비되어 있는지 짚어봅니다.

디지털 마케팅에서 이제 인공지능(AI)이 빠질 수 없겠죠. AI로 마케팅에 들어가던 인풋을 줄여주거나 성과를 개선하거나 데이터를 활용하는 내용 위주인 듯합니다.

이주원 Meta | Head of Marketing Science, Korea

https://ko-kr.facebook.com/business/ads

안재균 Moloco | 한국 지사장

Andy Carvell Phiture | CEO

이수현, Snowflake | 테크 에반젤리스트

Adrien Kwong, Xtend | Chief Commercial Officer

신창섭 X 코리아 | 대표

CRM: Customer Relationship Management 고객관계관리라는 아주 넓은 의미의 단어로 통용되고 있는 CRM 마케팅은 사용자와 닿는 메시지(팝업 배너, 앱푸시, 카카오톡, 문자, 이메일 등) 위주인데요.

퍼포먼스 마케팅보다는 비용 효율적이고(ex. 광고 소재 클릭당비용 보다는 카톡 발송 비용이 더 저렴한 경우), 웹/앱에서 사용자 행동 기반 개인화가 가능해 그로스해킹/그로스마케팅의 방법론으로도 많이 활용됩니다.

고주연, Braze | Area Vice President of Korea

이건희, 마티니 | 팀장

조형구/강하은, 29CM | Growth Marketer

최동훈, Amplitude | Senior Korea Partner Sales Manager

이재철, 마티니 | 팀장, 이형일, BKR | 이사

조경상, NNT | CEO

민병철, PIEDPIXELS | 사업 이사

오담인, 윤정묵, 장소영, 김형준, AB180 & Airbridge | Customer Success Team

애드테크는 Advertisement+Tech, 마테크는 Marketing+Tech로 광고와 마케팅에 있어 기술을 접목한 형태를 말합니다. 웹이나 앱에서의 성과 측정 및 사용자 행동 분석 등에 필요하죠.

정헌재, AB180 & Airbridge | CPO

김형빈, Viva Republica (Toss) | 부문장

✅ Shaping Android’s Privacy Sandbox

Pan Katsukis, Remerge | Co-Founder & CEO

호명규, Amplitude | 한국영업총괄

진겸, 당근 | 팀장

원하윤, Liner | PM

김동훈, 도소희, 현대카드 | Online Marketing

Bob Wang, PubMatic | Country Manager, Greater China & Korea

이승제, 딜라이트룸 | Product Owner, BD Lead

김나은, AB180 & Airbridge | VP of Growth

최동훈, Amplitude | 한국비즈니스총괄

최준호, Braze | Partner Sales Director

이수현, Snowflake | Tech Evangelist

윤가비, Apptweak | 한국 지사장

#글로벌, #애드테크·마테크, #트렌드 #프라이버시 #게임 #제품분석 #AI #MMP #UA #크리에이티브 #풀퍼널마케팅 #CRM #수익화

그로스마케팅, 그로스해킹, 그로스전략은 아직까지도 유효한 트렌드인 듯합니다. 그렇지만 결국 그로스를 이뤄내기 위해서는 조금 더 세부적인 부문의 실행 방안들이 필요합니다.

실행방안 #풀퍼널 #제품분석 #UA #크리에이티브 #CRM #수익화

사용자 여정의 풀퍼널(Full-Funnel)과 제품을 분석했을 때 프로덕트의 상황에 따라 UA(User Acquisitio, 신규 사용자 획득)에 초점을 맞춰야 할 수도 있고, 크리에이티브를 다변화하며 소재 A/B테스트를 운영해야 할 수도 있고, CRM을 통해서 사용자들에게 다음 단계 혹은 리텐션을 유도해야 할 수도 있고, '구매 전환'을 통한 수익화를 최우선으로 해야 할 수도 있습니다.

.

.

.

최근에 작은 브랜드를 운영하시는 대표님을 만나 뵌 적이 있었는데, 정말 열심히 하는 분이었습니다. 주말이면 온갖 웨비나와 세미나를 섭렵하시고 책도 읽고 강의도 들으시더라고요. 마케팅이 아닌 다른 부문에서 한평생 일하시다가 중장년의 나이에 공부를 하다 보니 따라가고 싶어 노력하신다 하셨어요.

이런저런 이야기를 하다가 저는 대표님께, 이제는 그만 듣고 또 공부하고 그냥 해야 할 때라고 말씀드렸습니다. 지금 수능 보고 낮은 점수받기 싫어서 계속 인터넷 강의 듣는 N수생 같다고요.

할 때는 해야 합니다. 다만 남들이 이미 풀어본 문제를 어떻게 푸는지 알고 가면 좋겠죠. 그 방식이 꼭 나에게도 맞을 거라는 보장은 없지만, 그래도 참고하면 방향성을 잡기에는 훨씬 수월하니까요. 그래서 디지털 마케팅 세미나들이 꽤 유용하지 않나 싶습니다.

앰플리튜드(Amplitude) Product Analytics, PA라고도 불리는 분석 솔루션 중 하나입니다. 구글에 '앰플리튜드'를 검색했을 시 스폰서(광고) 제외 두 번째 위치에 제 브런치의 글이 나옵니다. 어떻게 했을까요?

https://brunch.co.kr/@marketer-emje/8

상위노출 방법 전에 SEO의 개념을 먼저 훑고 갑니다!

Search Engine Optimization의 약자로, 검색엔진을 최적화한다는 뜻입니다. *검색엔진은 Google, Naver와 같이 '검색'을 통해 정보를 찾아주는 플랫폼이죠.

즉 SEO란 검색엔진에 노출되는 페이지를 최적화하여 상위 노출을 시키고, 특정 키워드를 검색한 사용자들이 상위 노출된 페이지를 보고 클릭하여 사이트에 '무료'로 유입될 수 있도록 하는 것을 말합니다.

사실 SEO 최적화라는 말은 Optimiziation의 뜻이 중복되는 말이지만, '최적화'가 가장 중요한 부분이니 만큼 강조된다고 생각할 수 있습니다.

SERP는 Searh Engine Result Page의 약자로 검색 결과 페이지라는 뜻입니다. 검색엔진에 특정 단어를 검색했을 시 노출되는 결과 페이지를 말합니다. 구글에 'SEO 최적화'를 검색했을 시의 SERP를 예시로 보면

1. 추천 스니펫 영역 2. 개별 사이트/페이지 노출 영역으로 구분되어 있네요. 구글 SERP의 구조 상, 스니펫은 없는 경우도 있고, 광고(sponsor)가 추가되는 경우도 많습니다.

CPC가 O원입니다. 배너 광고나 검색 광고처럼 Click per Cost(클릭당 비용)이 발생하지 않습니다. 즉 SEO 최적화에 의해 상위노출된 페이지로 생기는 트래픽은 '무료'로 발생한다는 것이죠.

이는 마케팅에서 중요한 포인트입니다. 구글 검색광고나 네이버 검색 광고 중 경쟁 강도가 높은 키워드들의 경우 한 번의 클릭에 1, OOO원은 기본이며 비싸게는 1O, OOO원~2O, OOO원의 비용이 듭니다. (단 한 번의 클릭인데요! 심지어 그다음 단계로 전환될 것이라는 보장도 없습니다, 실수로 눌려서 예산은 소진됩니다.)

그런데 SEO 최적화로 상위노출이 되는 페이지들은, 맨 처음 페이지 제작에 들어가는 초기 비용을 제외하면 추가 비용이 들지 않습니다. 꾸준히 새로운 사용자가 유입되고, 트래픽이 발생합니다.

앰플리튜드 관련 글은 4월에 조회수 2,000 > 5월에 조회수 3,000 > 7월에 조회수 4,000을 돌파했습니다.

다른 브런치 글들에 비하면 작게는 4배, 크게는 10배 차이입니다.

물론 미미한 숫자이지만 이렇게 생각하면 꽤 크지 않나요? 이런 자연 유입이 여러 키워드에서 잡힌다면 DAU/MAU에 꽤 유효하게 작용하게 됩니다.

클릭당비용(CPC) 외에 클릭률(CTR)을 본다면, 자연 영역에서 최상위 노출이 될 시 클릭률이 최대 53%에 달한다는 결과가 있었습니다. (*제가 사용자일 때도, 전 스폰서/광고가 걸린 페이지는 거의 안 누르긴 합니다.)

SEO 최적화, 즉 검색엔진에 잘 맞는 페이지로 만들어줘야 상위노출이 잘 잡힙니다. 여기서 SEO 방법론은 몇 가지로 나눌 수 있습니다.

웹사이트 내부에서 SEO를 최적화할 수 있는 요소입니다. 타이틀 태그와 메타 설명(meta description), 헤더 태그(header tag: H1, H2, H3...), 키워드 선정 및 사용, 콘텐츠 품질(이미지 포함), 링크 활용, 로딩 속도, 모바일 친화성 등이 있습니다.

내부에서 관리할 수 있는 영역인 것이지, 내부에서의 요소는 외부에도 고스란히 영향을 미칩니다. 무신사의 디스이즈네버댓 브랜드 페이지를 보면 내부에서 기재해 둔 텍스트가 구글 검색 시 동일하게 노출되는 것을 확인할 수 있습니다.

웹사이트 외부에서 SEO를 최적화할 수 있는 요소입니다. 백링크(back-link), On-page SEO에서는 페이지 내에 링크를 걸었던 것과 반대로 링크가 걸림 '당하는 것'입니다. 검색엔진에서 노출에 있어 선호하는 신뢰도가 높은 사이트 등 다른 사이트에서 자신의 사이트로 연결되는 링크가 있으면 좋습니다. 이외 SNS 등의 소셜 미디어, 인플루언서 등의 활용이 있습니다.

제가 더 주요하게 소개하고자 하는 SEO 최적화 방법론은 콘텐츠 SEO와 테크니컬 SEO로 나눌 수 있습니다.

콘텐츠 SEO에 주요한 요소는 키워드와 콘텐츠, 메타데이터입니다.

키워드 최적화는 프로덕트/서비스와 사용자, 시장, 경쟁사(유사 서비스)에서 사용하는 키워드를 분석하고 활용하는 것이 중요합니다.

a. 프로덕트/서비스에서 사용하는 키워드

b. 사용자가 사용하는 키워드

c. 시장에서 사용하는 키워드

d. 경쟁사가 사용하는 키워드

콘텐츠 최적화는 앞서 키워드 분석을 통해 선정한 주요 키워드 위주로 콘텐츠의 내용을 채우는 것과 콘텐츠의 형식을 구조화하는 것이 중요합니다.

a. 콘텐츠의 내용

b. 콘텐츠의 형식

메타 데이터는 웹 페이지 관련 정보를 제공하여 검색 엔진 및 소셜 미디어 플랫폼 내 페이지의 표시 방식에 영향을 미칩니다.

메타 데이터(메타 태그) 최적화

메타 데이터는 웹 페이지의 정보와 속성을 설명하고 검색 엔진 및 소셜 미디어에서 공유할 때 사용되어, 사용자에게 페이지 내용을 이해시키고 검색 엔진이 페이지를 색인화하는 데 도움을 줍니다.

*HTML 구조는 웹 페이지의 레이아웃과 콘텐츠를 정의하고, 시맨틱 태그는 HTML 구조 내에 의미론적으로 중요한 부분을 강조하며 메타 데이터는 검색엔진과 사용자에게 그 정보를 제공하는 것입니다.

자사몰을 보유하고 있을 때는 위와 같은 요소들을 고려하는 것이 필요합니다. 다만 개인의 페이지일 때는 검색엔진에 따라 유리한 사이트들이 있습니다. 예를 들어 똑같이 글을 쓰는 플랫폼이라고 하더라도, '네이버'에서는 네이버 블로그만이 노출되는 것처럼 '구글'에서는 워드프레스, 티스토리, 브런치 등이 유리합니다.

신경 쓰지 않았습니다. 고려했다면 워드프레스 등으로 블로그를 구축했겠으나... 시간을 아끼고자 했습니다. 대신 구글 상위노출을 목표로는 브런치를, 네이버 상위노출을 목표로는 개인 블로그를 활성화시켰습니다.

신경 많이 썼습니다! 키워드를 찾고, 선정하고, 글감을 목록화했습니다.

약 60장의 페이지에 꾹꾹 눌러 만들었습니다. 성함/이메일/회사의 정보를 입력해 주시면 다운로드하실 수 있어요!

.png)

지난 편에서는 각 솔루션별 데이터 수집 방법(바로가기)에 대해서 알아보았습니다.

1. Third Party 데이터 수집 자동화

2. 수집된 데이터 전처리하기

3. 시각화하기

이번에는 수집된 데이터를 활용하여 어떻게 전처리 해야 되는지 알아보겠습니다.

각 데이터 셋들은 분석하려는 차원(dimension)을 기준으로 집계(group by)를 통해서 동일한 형태로 전처리한 후 조인 연산을 통해 데이터를 통합하는 과정이라고 생각하시면 됩니다.

마케팅 성과를 분석하기 위해서 필요한 데이터 다음과 같습니다.

Dimension : 날짜(일별), 유입소스(GA4 = utm_source, Appsflyer = Media_source), 캠페인

Metric : 구매수, 매출, 인스톨 수

GA4가 웹, 앱 모두 트래킹을 할 수 있지만 WEB은 GA4, APP은 MMP로 성과를 합쳐서 보실 겁니다.

GA4, Firebase는 앱과 웹 내 고객 행동 분석에 주로 쓰이는 툴이고 MMP 는 광고 성과를 측정하는 툴이니깐요

그러면 이렇게 됩니다.

<GA4 데이터 집계> - WEB

Dimension : 날짜(일별), 세션 소스, 캠페인

Metric : 구매수, 매출

<MMP 데이터 집계> - APP

Dimension : 날짜(일별), Media_source, 캠페인

Metric : 구매수, 매출, 인스톨 수

집계된 두개의 테이블을 UNION 다시 한번 집계를 해줍니다.

이렇게 하면 집계된 웹앱 데이터 통합이 되었습니다. (MMP 데이터 전처리 과정은 생략)

Dimension : 날짜(일별), Media_source, 캠페인

Metric : 구매수, 매출, 인스톨 수

브레이즈 커런츠(braze currents)데이터는 유저 인게이지먼트 데이터입니다.

여기에는 유저별로 어떻게 우리 서비스로 참여를 하고있는지를 기록한 데이터들이 기록되어 있으니 메시지 발송 수단별로 노출, 클릭 성과들이 들어있습니다. 하지만 우리는 성과(구매) 판단은 MMP, GA4로 해야 하므로 서로 다른 데이터들을 어떻게 통합해서 볼지를 알아보겠습니다.

커런츠 데이터는 아래와 같이 구성이 되어있습니다.

위와 같은 데이터를 일자, 메세지 발송 타입, 캠페인 or 캔버스별 발송수, 노출수, 클릭수 데이터를 집계를 하기 위해서는 유니크한 ID를 나타내는 차원 데이터를 만들어 줘야 합니다.

동일한 유저라도 캠페인, 캔버스, 베리에이션 등 다양한 형태로 타겟이 될 수 있으므로, 아래와 같이 유니크한 차원 데이터를 만들기 위해 새로운 아이디를 생성합니다. (해당 아이디는 발송 타입별로 카운트하기 위해 활용됩니다.)

차원의 이름은 원하시는대로 명명하시면 되고 저는 user_id_dispatch_id 이렇게 명명하였습니다.

-- 태블로 계산식

IFNULL([User Id],'') + '-' +

IFNULL([Campaign Id],'') + '-' +

IFNULL([Message Variation Id],'') + '-' +

IFNULL([Canvas Id],'') + '-' +

IFNULL([Canvas Variation Id],'') + '-' +

IFNULL([Canvas Step Message Variation Id],'') + '-' +

IFNULL([Dispatch Id],'')

다음으로 캠페인 단위로 성과를 집계할 예정이기 때문에 캠페인 차원을 만들어줘야 합니다.

왜냐하면 브레이즈에는 캠페인과 캠버스로 나뉘는데 campaign_name 값이 존재하면 canvas_name 이 빈값이고 거꾸로 canvas_name 값이 존재하면 campaign_name이 빈값이기 때문입니다.

-- 태블로 계산식

IFNULL([Campaign Name],[Canvas Name])

{send_type}_click 이런 식으로 차원 이름을 명명하고 아래와 같은 태블로 계산식으로 차원을 만들어줍니다.

이렇게 되면 email_click, push_click, in_app_message_click 이벤트별로 ID(user_id_dispatch_id)를 생성됩니다.

-- 태블로 계산식

{ FIXED [user_id_dispatch_id],[Event Type] : COUNTD(IF CONTAINS([Event Type], 'inappmessage_click') THEN [user_id_dispatch_id] END)}

최초에 S3에 적재된 currents 데이터(avro 파일)를 DW에 적재할 때 파일별 Event 구분을 위해 Event_Type 칼럼을 생성하였습니다. (이전 글을 참고해 주세요)

['users.messages.email.Open.avro',

'users.messages.email.Click.avro',

'users.messages.pushnotification.Send.avro',

'users.messages.inappmessage.Click.avro',

'users.messages.email.Delivery.avro',

'users.messages.pushnotification.Open.avro',

'users.messages.inappmessage.Impression.avro']

-- 태블로 계산식

IF CONTAINS([Event_Type], 'email') then 'email'

elseif CONTAINS([Event_Type], 'push') then 'push'

elseif CONTAINS([Event_Type], 'inappmessage') then 'iam' end

이제 집계를 위한 전처리는 완료되었습니다(세세한 전처리 과정은 생략됨)

이제 위에서 만들었던 차원을 가지고 집계를 합니다.

일자별, send_type, campaign/canvas, device_category 별 오픈, 클릭, 노출, delivery 데이터는 아래와 같이 집계되었습니다.

통합된 GA4 / MMP 데이터와 커런츠 데이터를 통합해야 되는 과정이 또 남았습니다.

어떻게 이 두 데이터를 엮어야 될까요?

조인키를 위에서 집계한 차원 데이터로 잡고 Full Outer Join으로 데이터를 조인합니다.

이유는 특정 날짜에 브레이즈 커런츠 데이터는 존재하는데 성과 데이터(GA4, MMP) 데이터가 존재하지 않는다면 매칭될 수 없으니 누락이 되어버립니다. 거꾸로 성과 데이터(GA4, MMP) 데이터가 존재하는데 브레이즈 커런츠 데이터가 존재하지 않을 경우 누락이 되어버리기 때문입니다.

광고 성과 데이터 전처리하는 예시를 통해 Full Outer JOIN 이 어떻게 데이터를 처리되는지 예시를 통해 잠깐 확인해 보겠습니다

2024년 1월 1일 twitter 채널의 e 캠페인에서 비용이 1000원 소진했습니다. 그런데 GA4, MMP 데이터에는 해당 광고 채널의 캠페인에서 전환이 아예 일어나질 않았습니다. 하지만 비용이 발생했기 때문에 이 데이터를 버릴 수는 없겠죠? 무조건 살려야 됩니다.

거꾸로 광고 데이터에서 비용은 발생하지 않았는데 Attribution Window로 인해 전환이 발생했습니다. 이것도 버릴 수 없겠죠?

이 두 데이터에서 LEFT JOIN 또는 RIGHT JOIN을 수행하게 되면 조인키에 대응하지 않은 데이터는 매칭이 안되어 누락이 되어 버립니다. 이를 방지하기 위해서 INNER, LEFT OUTER, RIGHT OUTER 조인 집합을 생성하는 FULL OUTER JOIN을 수행합니다.

결과를 보면 각 테이블의 모든 데이터들이 출력이 되는 걸 알 수 있습니다.

본론으로 돌아와서!

Full Outer Join을 수행하기 전에 앞서 GA4, MMP 데이터를 합친 후 우리는 CRM 데이터만 필요하기 때문에 CRM 데이터만 필터를 합니다.

이제 Braze Current 데이터와 성과 데이터(GA4, MMP)를 날짜, 유입소스명, 캠페인명을 조인키로 두고 Full Outer Join 을 수행합니다.(분석하고자 하는 차원데이터가 추가로 더 있다면 추가로 필요한 차원도 조인키로 활용하시면 됩니다.)

이와 같은 방식으로 Paid 성과 데이터를 전처리 할 때도 위와 같은 방법으로 수행하면 됩니다.

데이터를 전처리 할 때 중요한 건 분석하고자 하는 결과물을 먼저 그려본 뒤에 결과를 도출하기 위해서 각 테이블을 어떻게 만들어 갈 것인지 생각하면서 만들어가면 됩니다. 실제로 전처리하다 보면 자잘하게 처리해야 되는 부분이 상당히 많습니다.

특히 데이터를 통합하기 위해서는 무엇보다 네이밍 컨벤션이 가장 중요한 점은 강조하지 않을 수 없습니다.

데이터 수집까지 잘했는데 캠페인 네이밍 컨벤션이 서로 다르다?.. 데이터 통합은 불가능합니다..

네이밍 컨벤션은 말 그대로 명명 규칙입니다.

위에서 언급한 대로 우리가 데이터 통합을 위해 차원 데이터를 조인키로 활용한다고 했었는데 캠페인 차원이 MMP, GA4, Braze or 광고 데이터가 모두 다르면 안 되겠죠? 아래와 같이 통일을 시켜야만 데이터를 연결할 수 있습니다.

여기까지 마케팅 데이터 수집부터 전처리 과정까지 알아보았습니다.

다음 글에서는 이 데이터를 활용해서 시각화 하는 방법을 살펴보겠습니다.

업무 시간을 데이터 수집과 데이터 전처리에 시간을 쓰는 마케터와 데이터 수집 자동화된 환경에서 성과 분석과 기획에 더 많은 시간을 쓰는 마케터 누가 더 많이 성장할까요?

답은 알고 계실 거에요. 당연히 성과 분석과 기획에 더 많은 시간을 쏟는 마케터가 장기적으로 많은 성장을 하겠죠

회사 내에서 GA4, MMP(AppsFlyer), Braze를 사용하고 있는데 엑셀로 데이터 수집해서 가공하는 시간을 대부분을 사용하고 있다면.. 하루 빨리 마케팅 데이터 수집 자동화하고 BI 구축을 시도해보세요.

관련 주제는 내용이 많기도 해서 3개로 나눠서 발행할 예정입니다.

이번 편에서는 MMP(AppsFlyer), GA4, Braze 데이터 수집을 자동화 시키는 프로세스를 설명해보려고 합니다.

데이터를 적재하고 시각화까지의 프로세스를 간단하게 도식화하면 아래와 같습니다.

브레이즈 currents 는 유저의 engagement 이벤트의 실시간 데이터 스트림입니다. 이 데이터를 Avro 파일로 제공해서 BI 및 분석 할 수 있게 지원을 해주는 장점이 있습니다. 단점은 가격이..

브레이즈 어드민에서 아래처럼 어떤 데이터를 보낼지 선택해서 어디에 저장할지 S3, Cloud Storage, Azure Blob Storage 중 선택해서 적재를 시작합니다. (가이드 링크)

예를 들어 Amazon S3 적재를 시작하게 되면 아래처럼 이벤트 별로 폴더가 생성되어 분리 적재됩니다.

브레이즈 Currents 는 At-least-once delivery 정책으로 1시간 단위로 데이터를 적재합니다.

각 폴더 안에는 Avro 파일(각 파일의 Schema는 동일한 형태)이 들어 있는데 이 파일 내에는 이벤트를 구분하는 필드가 없습니다.

일단 여기서 필요한 이벤트 데이터들을 지정해서 합쳐야 되는데 여기서 문제가 있습니다.

그래서 파일 안에 어떤 이벤트의 파일인지 지정해줘야 합니다.

아래와 같이 Avro 파일 명을 확인하여 event_type 필드의 key 값을 추가 필요합니다.

앱 데이터를 측정하는 앱스플라이어도 마찬가지로 데일리 리포트를 만드려면 OS별, UA, RT(리타겟팅)별로 csv 파일을 12번 클릭해서 받아 정리해야 되지만 API 를 활용하면 충분히 자동화 할 수 있습니다.

다만 앱스플라이어 데이터를 어떻게 볼지 기준에 대한 합의를 유관 부서와 먼저 하시는 걸 권장드리고 대행사에게도 우리 기준으로 맞춰 달라고 요청을 해야 되겠죠?

이런 기준으로 데이터를 쌓고 있었는데 데이터를 집계하는 기준이 서로 차이가 있다면 .. 다시 작업해야 되는 불상사가 생길 수 있습니다.

이게 무슨 말이냐면 앱스플라이어 Media Source 중 SRN 매체들의 경우 개인정보 보호 이슈로 rawdata에 포함되지 않아서 집약형 데이터를 활용합니다.(가이드 링크)

그래서 SRN 매체를 사용 중이시라면 집약형 데이터를 활용해서 집계를 해야 하는데 집약형 데이터는 LTV 데이터라서 조회 시점마다 Total Revenue 값이 달라집니다. (관련글 보러가기 링크)

1/1 데이터를 1/7일에 조회했을 때랑 1/14일에 조회했을 때의 total revenue가 달라진다는 의미입니다. 이러게 되면 가장 최근에 조회한 일자일 수록 ROAS가 높게 나오겠죠?

또한 skan 리포트도 마찬가지로 SRN 매체 광고를 운영 중에 있다면 해당 리포트도 받아야겠죠? 이것도 마찬가지로 조회시점마다 성과 숫자가 달라질 수 있습니다

앱스플라이어 데이터 자동화 수집을 위해선 크게 3가지 api 가 필요하고 세부적으로는 인스톨과 인앱이벤트 데이터를 가져와야 합니다. (추후에 앱스플라이어 데이터를 전처리하는 방법에 대해서 포스팅 해보겠습니다.)

GA4 빅쿼리는 실무에서 쓰고 있는 조직이 있나 싶을 정도로 .. 사용하기가 좀 꺼려집니다. 원시 데이터라서 데이터 가공의 자유도가 엄청나게 높지만.. 집계를 하는 입장에서는 굉장히 머리 아픕니다. 정합성을 어디다가 맞춰야 되는지..

그래서 광고 데이터 성과를 집계할 때는 특별한 이유가 없다면 GA4 API 데이터를 소싱하는 게 정합성 의심의 여지가 없기 때문에 무조건 낫다고 봅니다.

GA4 데이터를 소싱할 때 진짜 진짜 주의해야 할 점이 바로 샘플링입니다.

샘플링 진짜 …. 데이터량이 많으면 더 심해집니다.

GA4 API 를 14일치만 호출해도 샘플링된 양이 상당합니다.

GA4 Query Explorer 에서도 조회해도 어드민이랑 큰 차이가 있어서 구글 측에 문의를 해보니 여기도 데이터 조회 일자 범위가 넓으면 샘플링이 적용된다고 합니다. 추후에 해당 이슈 해소하겠다고 합니다.

일단 우리는 샘플링 되지 않을 정도의 날짜 범위로 api 를 호출해서 적재를 하는 것이 좋습니다.

이번 편은 마케팅 데이터 수집 자동화에 대해서 알아보았고 다음 편에서는 인사이트 도출을 위한 데이터 전처리 방법에 대해서 알아보겠습니다!

GA4 데이터를 빅쿼리로 보내면 뭐든 다 해결될 것 같은 이야기들이 많지만 실상은 그렇지 못합니다. GA4 인터페이스와 차이가 많고 많은 데이터 용량으로 ETL 과정으로 생각보다 리소스가 많이 듭니다. 그럼에도 불구하고 빅쿼리를 쓰는 이유가 뭘까요?

GA4 빅쿼리 데이터를 가공하다보면 어? 뭐지? 하는 현상들이 있는데 대표적인 하나의 케이스를 공유해볼까합니다. 바로! 빅쿼리에 저장되는 GA4 데이터에는 구글 관련 트래픽에 가장 큰 문제가 있다는 것입니다ㅜㅜ

gclid 파라미터(구글 애즈 캠페인으로 들어온 트래픽이라는 의미)가 있는 세션이 시작 되었을 때 빅쿼리는 utm_medium, utm_campaign 파라미터를 (organic)으로 기록해버립니다

다시 말하면 구글 애즈로 들어왔다는 데이터라고 식별은 되지만 캠페인 명이 증발해버리는 현상입니다.

with events as (

select

cast(event_date as date format 'YYYYMMDD') as date,

concat(user_pseudo_id, (select value.int_value from unnest(event_params) where key = 'ga_session_id')) as session_id,

user_pseudo_id,

(select value.int_value from unnest(event_params) where key = 'ga_session_id') as session_start,

if(

(select value.string_value from unnest(event_params) where key in ('campaign_id', 'campaign', 'source', 'medium', 'term', 'content', 'gclid', 'dclid', 'srsltid') and value.string_value is not null limit 1) is not null,

(

select as struct

(select value.string_value from unnest(event_params) where key = 'campaign_id') as manual_campaign_id,

(select value.string_value from unnest(event_params) where key = 'campaign') as manual_campaign_name,

(select value.string_value from unnest(event_params) where key = 'source') as manual_source,

(select value.string_value from unnest(event_params) where key = 'medium') as manual_medium,

(select value.string_value from unnest(event_params) where key = 'term') as manual_term,

(select value.string_value from unnest(event_params) where key = 'content') as manual_content,

(select value.string_value from unnest(event_params) where key = 'gclid') as gclid,

(select value.string_value from unnest(event_params) where key = 'dclid') as dclid,

(select value.string_value from unnest(event_params) where key = 'srsltid') as srsltid

),

null

) as collected_traffic_source,

event_timestamp,

stream_id,

(select value.string_value from unnest(event_params) where key = 'device_category') device_category,

event_name,

ecommerce.purchase_revenue_in_usd as purchase_revenue_in_usd,

case

when event_name = 'purchase'

then 1 else 0 end AS purchase

from

`테이블명`

where

_TABLE_SUFFIX >= '20231001' AND _TABLE_SUFFIX <= '20231001'

and (select value.string_value from unnest(event_params) where key = 'source') = 'google'

)

select * from events

order by session_id

이 현상을 해결하려면 UTM 파라미터를 자동 태깅(gclid)를 대신해서 사용하거나 URL에 커스텀 파라미터를 붙여서 해결할 수 있긴 합니다.

유저 레벨 분석이 아닌 마케팅 성과를 집계하기 위한 목적으로 GA4 데이터를 활용하고자 한다면 Bigquery Export 보다는 Google Analytics Data API 를 활용해서 일별로 내부 DataWarehouse에 저장하는 방식이 더 효율적일 것 같습니다.

참고로 Google Analytics Data API 를 활용한다면 집계된 데이터를 받아오기 때문에 Total Users 와 같은 유니크한 집계값 (Count Distinct)를 해야되는 지표는 제외하고 이벤트 단위의 지표만 활용해야합니다. 이유는 아래와 같습니다.

4명의 유저가 2024-01-01 ~ 2024-01-03 에 방문했습니다.(로우 데이터)

일별 Total User 를 집계해보면

전체 기간의 Total User 를 집계해보면

일별, 기간별 집계 했을 때 유니크 사용자수는 완전히 다릅니다. (DAU, MAU 개념과 동일)일별 테이블을 다 더해서 집계를 해서 사용하시면 쓸모없는 지표가 되어버리기 때문입니다.

그래도 유저레벨 단위로 혹은 GA4 인터페이스에서 처리 못하는 방식의 데이터 가공이 필요하다면 위의 케이스를 반드시 고려해서 빅쿼리를 사용하시는 걸 권장드립니다.

Why your BigQuery results don't (exactly) match with Google Analytics reports (GA4)

데이터를 구성하는 형식은 크게 Long format data와 Wide format data로 구분할 수 있습니다.

각 유형 별 특징 및 장단점에 대해 살펴보겠습니다.

Wide Format Data는 각 주제 또는 관찰단위가 단일 행으로 표시되는 구조입니다.

특징:

사용시 장점:

특징:

사용시 장점:

Wide Format 데이터를 태블로에 입력하면 학생Id는 차원에, 점수관련 항목은 측정값으로 구분됩니다.

이를 활용해 하나의 테이블을 생성하기 위해서는 점수관련 항목을 모두 선택해주어야합니다.

반면 Long Format 데이터를 태블로에 입력하면 학생Id와 시험 항목은 차원에, 점수는 측정값으로 구분됩니다. 이를 활용해 하나의 테이블을 생성하기 위해서는 열에 시험 차원을, 행에 학생 Id차원을 올려놓은 후 점수 값을 표에 입력하면 됩니다.

다음은 해당 데이터들을 활용해 그래프를 생성해보겠습니다.

먼저 Wide Format 데이터의 경우 국어시험, 수학시험, 영어시험은 각각 다른 차원에 존재하는 데이터이므로 이를 하나로 합친 차트를 구현하는 것은 불가능합니다.

반면 Long Format 데이터의 경우, 시험이라는 하나의 차원을 기준으로 점수라는 측정값이 적재되어 있기때문에 해당 데이터를 이용해서는 하나의 차트 내에서 3가지 항목을 구분하여 구현할 수 있습니다.

→ 따라서 Tableau를 활용하여 시각화를 구현할 때에는 Long Format형식의 데이터를 사용하는 것이 더욱더 다양한 시각화가 가능합니다.

리텐션(Retention)은 고객이나 사용자가 특정 기간 동안 어떤 제품이나 서비스에 계속 관여하거나 이용하는 비율을 말합니다. 즉, 얼마나 많은 사용자가 시간이 지남에 따라 제품이나 서비스를 계속 사용하는지를 나타내는 지표입니다. 높은 리텐션율은 고객 충성도가 높고, 제품이나 서비스에 대한 만족도가 높음을 의미합니다.

리텐션을 지속적으로 측정하고 관리하는 것이 중요한 이유는 여러가지가 있습니다. 리텐션은 단순히 고객이 제품이나 서비스를 계속 사용하는 것을 넘어서 기업의 지속가능성과 직접적으로 연결되는 핵심 지표입니다. 리텐션이 중요한 이유를 좀 더 자세히 살펴보면 다음과 같습니다.

리텐션을 측정하는 기준에는 다양한 방법이 존재합니다. 그 중 Amplitude에서 확인할 수 있는 리텐션의 종류인 ‘N-day Retention’과 ‘Unbounded Retention’에 대해 좀 더 자세히 알아보려고 합니다.

N-day Retention은 사용자가 처음 제품이나 서비스를 이용한 후 특정 일수(N일) 후에도 계속 이용하는지를 측정하는 방법입니다. 예를 들어, 7-day Retention은 사용자가 서비스를 처음 이용한 후 7일째 되는 날에도 서비스를 이용하는 비율을 의미합니다. 해당 리텐션은 초기 사용자 참여, 온보딩, 새로운 기능, 단기 마케팅 캠페인 분석을 위해 사용됩니다.

Unbounded Retention은 특정 기간 동안 사용자가 최소 한 번이라도 제품이나 서비스를 이용했는지를 측정하는 방법입니다. 이 방법은 시간이 지나도 사용자가 이탈하지 않고 계속해서 제품을 사용했는지의 여부만을 고려합니다. 해당 리텐션은 장기적인 참여, 고객 충성도, 반복 구매, 주기적인 콘텐츠 업데이트 분석을 위해 사용됩니다.

리텐션 차트는 시간에 따른 사용자의 이탈 및 유지 패턴을 시각적으로 표현한 그래프입니다. 이 차트는 특정 기간 동안 사용자 그룹의 리텐션율 변화를 보여줍니다. 리텐션 차트를 통해 크게 행 기준 분석과 열 기준 분석을 수행할 수 있습니다.

리텐션 커브는 시간에 따른 리텐션율의 변화를 나타낸 것입니다. 이 커브는 초기 사용자 참여 이후 리텐션율의 감소 패턴을 한눈에 파악할 수 있게 해줍니다.

리텐션 커브는 감소형태에 따라 유형를 크게 3가지로 나눌 수 있습니다.

시간이 지남에 따라 사용자 참여가 감소되는 패턴의 커브입니다. 이는 가장 흔히 보이는 커브의 형태로, 초기참여 이후 사용자의 관심이 감소됨을 의미합니다.

초기 감소 후 리텐션율이 안정적으로 유지되는 패턴의 커브입니다. 이는 사용자들이 제품이나 서비스에 익숙해지고 일정수준의 참여를 계속해서 유지함을 나타냅니다.

리텐션 감소 후 시간이 지남에 따라 다시 증가하는 패턴의 커브입니다. 이는 매우 긍정적인 상황으로, 사용자들이 초기 이탈후 일정시간이 지나 다시 제품이나 서비스에 관심을 가지기 시작함을 의미합니다.

본업이 그로스마케터이므로... '그로스마케팅'와 관련된 포스팅을 지속적으로 작성하고 있는데요. 관련 키워드로 '패션마케팅'이 검색량이 높아 무신사, 29CM, W컨셉을 사례로 준비해 보았습니다. (좀 더 알아보니 패션마케팅은 대학교 학과가 있어 입시생들의 검색량이 높은 키워드인 듯은 하네요.)

무신사의 브랜드마케터 채용 공고를 먼저 보겠습니다.

cf. https://brunch.co.kr/@marketer-emje/13

퍼포먼스마케팅에서 배너 광고를 운영할 때 그 소재로 브랜드가 강조될 수 있고, 프로모션이 강조될 수도 있고, 인플루언서가 강조될 수도 있고 메인 콘셉트를 무엇으로 하느냐에 따라서 소재 베리에이션은 다채로울 수 있는데요. 예시와 함께 보겠습니다.

페이스북 광고 라이브러리에서 'WConcept'을 검색했을 때 결과 중 일부를 가져왔는데요.

W컨셉에서 W컨셉 페이지로 랜딩 시키는 것은 당연한데, W컨셉에 입점해있는 '브랜드'들이 광고의 랜딩을 랜딩을 W컨셉으로 보내네요!

소규모 브랜드라면 개별 웹사이트를 관리, 운영하는 것보다 수수료를 감안하더라도 의류 플랫폼(W컨셉 등)에서의 매출을 높이는 것이 더 낫다고 판단했다고 추측할 수 있습니다.

신규 가입과 앱 첫 구매의 내용이 담겼다는 것은 해당 광고의 세팅이 '리타겟팅'이 아닐 것이라 추측할 수 있습니다. 아마 성별만 '남성'으로 지정하고 오픈 타겟으로 열지 않았을까 싶네요. 디타겟팅(=타겟에서 제외하는 것)으로 이미 회원인 분들과 앱이 있는 분들을 타겟에서 제외하고요.

해당 업무는 일반적인 퍼포먼스마케터/그로스마케터가 진행하기보다는 무신사의 예시처럼 '인플루언서 마케터'의 직무가 따로 있는 경우가 많습니다.

인스타그래머라면 피드, 스토리의 이미지/워딩 그리고 유튜버라면 유튜브 구성안과 기획안을 검토하면서 논의를 이어가게 됩니다. 일정, 비용, 스토리라인, 강조되어야 하는 점, 해시태그 등을 이야기하고요.

하단 예시처럼 유상 광고 소재(인스타그램 광고 소재)로 인플루언서의 이미지를 활용하는 경우 추가 협의가 필요합니다.

새로운 회원들을 어느 정도 유치했다면, 그 회원들을 계속해서 유지하는 것이 관건이겠죠. 리텐션(=재방문율/재구매율)이 그 지표가 되는데요. 리텐션의 기본으로 여겨지는 것 중 하나가 멤버십입니다.

W컨셉은 5개의 멤버십 등급을 가지고 있고, 그 기준으로는 누적 구매액과 함께 구매'수량'을 같이 보고 있습니다. 해석해 보자면 딱 한 개의 상품만 샀는데 - 그 상품이 100만 원짜리였다 -라고 했을 때 한 번에 VIP로 가는 것을 방지하기 위함이라고 볼 수 있습니다. 한 번 들어와서 비싼 것 한 개 산 사람보다, 여러 번 들어와서 중고가를 여러 개 산 사람이 더 충성도가 높다고 판단하는 것이겠죠?

29CM의 경우 동일한 워딩에 여러 브랜드X상품 이미지를 활용하기 위해 조금 포괄적인 내용을 광고 워딩으로 썼는데요. 29CM의 아이덴티티 + 매월 멤버십 쿠폰 ~15% 혜택을 강조합니다. 여기엔 신규 회원 가입이나 앱 설치 쿠폰이 없는 것을 보아 신규를 대상으로만 하는 광고가 아님을 알 수 있고요.

무신사스탠다드(무신사의 PB브랜드)의 마케팅 팀장 채용 공고에도 '중요 이벤트와 프로모션 지원을 통해' 라는 워딩을 통해 마케팅과 연계된 프로모션의 중요성을 인지할 수 있습니다.

상품 할인과 쿠폰 할인(상품 쿠폰, 장바구니 쿠폰)의 구분은 커머스에서 혜택을 설계할 때나 손익을 계산할 떄 때 그리고 심지어 프로덕트 애널리틱스에서 이벤트/프로퍼티의 택소노미를 설계할 때도 아주 중요한 요소입니다.

앱 설치 쿠폰 및 가입 혜택 프로모션은 Always-on 올웨이즈온 캠페인에 속하고, 홀리데이 프로모션은 팝업/애드훅 캠페인으로 볼 수 있겠죠? (와 쉽다!)

보통 앱 설치, 가입의 경우 장기적인 관점의 KPI 달성을 위해 진행되는 캠페인으로 일간/주간/월간 성과를 지속적으로 모니터링하고요. 팝업/애드훅 캠페인의 경우 정해진 기간 동안 최대 매출 등의 목표치를 달성하는 것이 중요합니다. (무신사의 무진장세일이 매년 역대급 매출을 갱신한다고 하죠...? 그렇지만 무진장 정도면 이제는 정규 캠페인이라고도 볼 수 있겠네요)

CRM 수단으로는 앱 중심의 서비스인 경우 앱푸시, 카카오톡을 위주로 사용하고 웹의 경우 배너/팝업 또한 CRM의 일환으로 볼 수 있겠습니다. 문자 및 이메일은 조금 더 전통적인 수단이겠죠?

CRM 마케팅은 CRM 마케터 직무로도 많이 채용하지만, 그로스마케터의 수행 업무에 수반되는 경우도 꽤 있습니다. 29CM의 그로스 마케터 채용 공고를 보면 '고객 커뮤니케이션 타겟 / 채널 / 메시지 테스트 및 운영' 이라는 워딩을 볼 수 있는데요. 하단처럼 쪼개서 생각할 수 있고, 결국 CRM 마케팅에 대한 내용이라는 것을 알 수 있습니다.

CRM 마케팅이 최근 뜨는 이유는 개인 정보 보호 트렌드 때문인데요. 과거 퍼포먼스마케팅에서는 정교한 타겟팅을 위해 사용자가 웹 내에서 행동했던 것들을 추적하는 (cookie, 쿠키! 한 번쯤은 지워보셨죠?) 것이 중요했는데 이 쿠키 정보의 제공이 중단되면서 일반적인 퍼포먼스마케팅의 효율이 낮아지며 비용이 높아진 것도 일부 원인이 있고요.

상대적으로 CRM은 이미 보유한 회원 모수를 대상으로 메시지를 보내기에, 신규 사용자를 획득하는 것보다 효율이 높고(=비용이 낮고) 운영에 필요한 실 비용이 메시지 발송 비용 정도로 상대적으로 비용이 낮기 때문도 있습니다. CRM마케팅은 기회가 된다면 다음에 좀 더 자세하게 풀어보도록 할게요!

이렇게 패션 플랫폼의 그로스 마케팅 (ft. 무신사, 29CM, W컨셉)을 광고 소재와 채용 공고, 프로덕트를 통해서 Acquisition과 Retention 위주로 알아봤습니다.

[다른 글 보러 가기]

그로스마케팅과 AARRR 퍼널 분석 (ft. 29CM)

https://brunch.co.kr/@marketer-emje/11

그로스마케팅이란? 콘텐츠도 퍼포먼스도 UIUX개선도!

https://brunch.co.kr/@marketer-emje/10

그로스마케팅과 AARRR:Acquisition 획득

https://brunch.co.kr/@marketer-emje/13

풀스택 마케팅 컨설팅펌 마티니아이오

구글 애널리틱스와 앰플리튜드의 기능, 추적 방식, 분석 항목, 의의와 장단점, 담당자를 비교하자면 하단과 같습니다. 해당 내용의 이해를 위해 차근히 퍼포먼스마케터, 그로스마케터의 직무 요건에서부터 왜 애널리틱스가 중요한지(GA든 Amplitude든) 알아보도록 하겠습니다.

마케터로 생각하는 직무는 주로 퍼포먼스 마케터일 것입니다. 퍼포먼스마케터, 소위 퍼포마는 브랜드나 대행사(에이전시)에서 마케팅 전략을 수립하고 미디어믹스를 짜고 (매체 별/광고 상품 별로 얼마나 쓸 건지를 짜는 것) 이후 해당 미디어믹스에 따라 광고를 집행한 후에 광고 성과를 관리합니다.

그렇다면 퍼포마의 채용 공고를 분석해 보겠습니다. 퍼포먼스 마케터의 직무 요건 및 우대 사항에는 Google Analytics와 Amplitude가 꽤 자주 등장합니다. 심지어 데이터 분석가 직무에도 있네요. 왜일까요?

한 건의 전환이 일어나기까지, 한 명의 사용자에게 노출되는 광고는 수도 없이 많습니다. 마케팅을 열심히 할수록 그렇습니다. 사용자가 1) 인스타그램 광고도 볼 거고, 2) 유튜브 콘텐츠를 봤을 수도 있고, 3) 카카오 배너 광고를 봤을 수도 있고, 4) 네이버 검색 광고를 봤을 수도 있습니다. 이렇게 수많은 광고 매체를 거쳐, 한 건의 전환이 일어났을 때 가장 중요한 질문은 무엇일까요?

다수의 광고 매체들은 다 자기가 기여를 했다고 말합니다. 그래서 광고 관리자로만 광고 성과를 보면 과도하게 성과가 집계될 수밖에 없고, 중복 집계될 수밖에 없는 것입니다.

일주일 안에 저 광고 매체들에 다 노출되었던 사용자가 전환을 했다고 가정해 볼까요? 그렇다면 기여 기간은 7일인 것이고 (광고 매체의 성과를 인정해 주는 기간) 노출된 매체는 4개, 그중 유상(Paid) 광고 매체 3개입니다. (유튜브 콘텐츠는 자사의 브랜딩이었다고 하면요.)

그럼 그중 누가 이 전환의 성과를 가져갈까요?

이렇게 광고 성과의 기여값을 보다 정확하게 측정하기 위해서 Attribution Tool(어트리뷰션툴), Analytics(애널리틱스)가 존재합니다. Web Analytics로 가장 유명한 것이 구글 애널리틱스인 것이고요.

글의 초반 앰플리튜드 vs 구글애널리틱스 비교표에서 언급했었죠. 구글 애널리틱스는 이처럼 광고 매체들의 전환값의 기여도를 측정하여 마케팅을 효율화하는 것을 목적으로 많이 활용합니다.

여기서 또 하나 짚어야 할 것이 있습니다. 그 광고, 클릭하면 어디로 가나요? 클릭해서 이동한 페이지에서 보통 전환이 일어날 테니까요.

마케팅 캠페인이 '웹'에 치중되어 있을 때는 구글애널리틱스의 시대였습니다. 그렇지만 '앱'이 뜨기 시작하고 앱마케팅이 활성화되면서 구글애널리틱스 또한 한계에 부딪힙니다.

웹으로 랜딩 된 후 구매라는 전환 행동이 일어날 때 구글 애널리틱스는 Last touch 기여 설정에 의해서, 해당 전환의 성과는 '페이스북'에게 있다고 측정했습니다.

그런데 웹 랜딩 이후 앱 설치가 진행되고 앱에서 구매가 일어나면 어떻게 될까요? 사용자의 흔적을 파악할 수 있던 utm (광고 매체의 소스값)이 유실되며 광고 매체의 성과를 잡지 못하고, organic (자연 유입)으로 측정하게 됩니다.

cf. 여기서 utm의 광고 매체 소스값이란...?

구글에 나이키를 검색하면 '스폰서' 광고로 나이키가 뜹니다. 이걸 클릭하면 url이 이렇게 나옵니다.

https://www.nike.com/kr?utm_source=Google&utm_medium=PS&utm_campaign=365DIGITAL_Google_SA_Keyword_Main_PC&cp=72646825390.... > utm_source=Google이라고 알려줍니다. (소스값) utm_medium=PS라고 알려줍니다. (매체) 이 두 개의 조합을 광고 매체의 소스값이라고 합니다.

그래서 앱 마케팅이 중요해질수록 MMP와 PA의 인지도 또한 높아질 수밖에 없습니다. MMP는 Mobile Measurement Partners로 앱스토어에 SDK를 붙여 앱 설치 성과를 측정해 주는 솔루션을 말하고, PA(Product Analytics)는 이러한 MMP들을 연동하여 앱 설치 성과를 분석할 수 있도록 도와줍니다.

서비스가 Web 위주인 경우 구글애널리틱스만 사용해도 충분합니다. 다만 App 위주인 경우 App 설치 성과를 분석하는 MMP (Appsflyer, Adjust, Airbridge 등)와 Web to App을 추적하고, App 내 사용자 행동을 분석하는 PA(Amplitude, Mixpanel 등)가 필요합니다!

풀스택 마케팅 컨설팅펌 마티니아이오

그로스해킹은 Growth와 Hacking의 조합, 그로스마케팅은 Growth와 Marketing의 조합으로 두 개념 다 '성장'을 위함이지만 해킹은 어떤 수단을 동원할지 한정짓지 않는 것이고 마케팅은 마케팅 측면에 집중한 것입니다.

AARRR 프레임워크가 왜 중요할까요? 그로스마케팅의 범위가 모든 마케팅을 포괄하는 만큼, 업무의 우선순위를 정해야 하기 때문입니다. 비즈니스의 특성, 규모, 성숙도에 따라 AARRR 중 현재 집중해야하는 단계를 파악하고 그 부분을 활성화하기 위한 마케팅 캠페인을 운영해야 합니다.

(1) A: Acquisition 획득

(2) A: Activation 활성화

(3) R: Retention 유지(리텐션)

(4) R: Revenue 수익화(매출)

(5) R: Referral 추천

▶️ AARRR 프레임워크 관련된 더 자세한 글은 여기서 확인해주세요.

https://brunch.co.kr/@marketer-emje/11

AARRR 프레임워크의 첫번째 약자인 Acquisition(획득)을 알아보겠습니다. 사용자 획득을 위한 마케팅을 UA 마케팅 (User Acquisition Marketing)이라고 자주 부르는데요. UA마케팅에서 사용하는 광고 매체, 성과 분석 툴, KPI(유입, 가입, 앱설치, 첫구매 등)에 따라 봐야하는 지표, 실제 사례 등을 공유해보겠습니다.

잡코리아에 'UA마케팅'을 검색했을 때의 결과페이지입니다. 넷마블, 크래프톤 등 유명 게임 회사가 좀 보이고, 이외 앱 중심의 커머스 회사인 브랜디도 있네요. UA 마케팅이란 단어를 게임 업계에서 많이 쓴다고는 하는데요, UA 마케터라는 포지션명은 잘 쓰지 않기 때문에 UA 마케팅을 하는 퍼포먼스마케터로 생각할 수 있겠습니다.

AARRR의 첫 단어인 만큼 '획득'은 마케팅 초기 단계로, 유저(사용자)가 서비스에 '획득'되게 만드는 것입니다. 여기서 획득은 서비스 내에서 정의하기 나름이지만 단순히 유입(Traffic, 트래픽)이 될 수도 있고 유입 이후의 가입(Signup, 등록/계정 생성) 혹은 앱 설치 (App Install) 혹은 첫구매 (1st Purchase)일 수도 있습니다. KPI가 무엇이냐에 따라 주의 깊게 봐야하는 지표 또한 달라집니다.

사용자를 획득하고자 하는 UA 마케팅에서는 주로 어떤 광고 매체를 활용할까요? 힌트는 UA마케팅을 검색했을 시 나오는 퍼포먼스마케터의 채용 공고에 있습니다!

· 글로벌 UA 매체 Self-serve: Google, Meta 등

Self-serve: 광고 대행사를 통한 운영이 아닌 직접 운영을 말합니다.

· 마케팅 성과 분석 툴 활용 역량 (Singular, Appsflyer, Firebase, Gamesight, GA 등)

MMP(Mobile Measurement Partners)인 싱귤러와 앱스플라이어가 등장하네요.

· 1st Party Data 활용을 통한 광고 <> 내부 성과 분석

1st Party Data란 우리 서비스에 쌓이는 데이터를 기반으로, 자사 내부 데이터라고 할 수 있습니다. 이에 반대되는 개념이 3rd Party Data로 외부 데이터로, 광고 매체들의 데이터들을 예시로 들 수 있습니다.

· 광고 매체: 메타, 구글, 네이버 SA/DA, 카카오 등

DA는 Display Advertisement(Ads)로 배너 광고, SA는 Search Advertisement(Ads)로 검색 광고를 뜻합니다.

· 분석 트래킹 툴 활용 통한 데이터 분석 (Appsflyer, GA 등)

MMP(Mobile Measurement Partners)인 앱스플라이어가 등장하네요.

· User Acquisition - Activation 퍼널 단계에서 KPI 달성

그로스마케팅은 그로스(Growth)를 위해 무엇이든 하기에 AARRR 프레임워크의 모든 단계와 관련된 업무를 하지만 주로 퍼포먼스마케팅은 AARRR 중의 초기 단계인 Acquisition과 Activation 위주의 업무를 합니다.

· 주요 매체 (Google, NAver, Meta, Kakao) Self-Serve

(*Self-serve: 광고 대행사를 통한 운영이 아닌 직접 운영을 말합니다.)

· 3rd + 1st Party 데이터 분석을 통한 UA 성과 관리

1st Party Data란 우리 서비스에 쌓이는 데이터를 기반으로, 자사 내부 데이터라고 할 수 있습니다. 이에 반대되는 개념이 3rd Party Data로 외부 데이터로, 광고 매체들의 데이터들을 예시로 들 수 있습니다.

보통의 광고 매체(3rd Party)에서는 자신의 매체를 기준으로 성과를 측정하기 때문에 내부 데이터(1st Party)와 수치가 맞지 않는 경우가 많습니다.

ex. 사용자가 3일 전 인스타 배너 광고를 보고 클릭해서 유입되었다가 이탈된 후 다시 네이버 검색 광고를 통해 오늘 유입되어 가입한 경우를 생각해봅시다. 기여기간이 7일이라고 할 때, 인스타그램 및 네이버 매체의 광고 관리자에서 해당 가입이 모두 각자의 성과라고 계수할 수 있습니다. 이렇게 되면 광고 관리자에서 확인된(3rd Party) 가입자 수치는 2명이고, 실제 내부 데이터(1st Party)에서는 1명이겠죠?

'지표'는 특정 현상을 나타내는 수치입니다. 쉽게 말하면 클릭률(CTR:Click-Through Rate)), 클릭당비용(CPC:Cost Per Click), CPM(노출당비용), CPI(설치당비용), PV(페이지뷰), CAC(가입당비용).. 이런 것들 인데요. 배너 광고 및 검색 광고의 효율을 판단할 때 지표들을 기준으로 성과가 좋다/나쁘다를 이야기할 수 있습니다.

지표를 AARRR 프레임워크에 맞추어 구분하고 확인할 수도 있습니다.

Acquisition 관련 대표 지표들

액션을 무엇으로 설정해두었느냐에 따라 달라집니다.

보통 유입/트래픽 캠페인은 일회성 모수인 경우가 많아 (즉 사용자가 서비스를 장기적으로 사용하지 않고 유입만 되었다가 이탈하는 경우) 커머스에서는 가입 및 첫구매를 독려하고, 앱의 중요도가 큰 경우는 앱설치까지 유도하는 경우가 많습니다.

그로스해킹과 그로스마케팅 그리고 그로스마케팅에서의 AARRR 프레임워크 개념을 넘어서 이제는 조금 더 구체적으로 Acquisition 단계의 UA마케팅에 대해서 다뤄봤습니다. 광고 매체나 성과 분석 툴의 경우는 다른 단계에서도 크게 달라지지 않지만 그만큼 중요한 내용이기에 계속 이야기하겠습니다!

풀스택 마케팅 컨설팅펌 마티니아이오

퍼포먼스 마케팅에서는 다양한 최적화 전략을 사용하여 목표를 달성할 수 있습니다. 특히, 머신러닝이 주요하게 작용하는 상품들은 최적화를 무엇을 적용하느냐에 따라 성과 결과가 다르게 나타나는데요. 오늘은 매출 증대를 위한 최적화 2가지에 대해 얘기해보고자 합니다. 구매 최적화와 ROAS 최적화. 이 두 최적화는 매출 증대의 목적으로 운영되긴 하지만, 분명한 차이가 존재합니다. 간단하지만, 각 최적화별 정의와 차이점, 어떤 상황에 적용하는게 더 효과가 좋을지에 대해 작성해보고자 합니다.

구매 최적화는 구매 이벤트 최적화, 즉 광고 캠페인을 통해 직접적인 구매 전환을 최대화 하는 것을 목표로 하며, 주로 비용 효율 보다는 구매 자체에 집중합니다. 흔히 알고 있는 이벤트 최적화이며, 이벤트들 중 구매 이벤트 발생에 집중하여, 머신러닝 합니다.

ROAS 최적화는 광고 비용 대비 매출 최대화 하는 것을 목표로 하며, 효율적인 비용 관리와 최대 매출 포커싱하여 최적화 합니다.

ROAS는 위와 같이 계산하며, ROAS은 두 최적화 모두 산출 가능하지만, ROAS 최적화는 ROAS에 보다 집중하여 머신 학습이 진행되는 것을 의미합니다.

구매 최적화는 많은 구매 이벤트를 발생 시키는 것을 목적으로 머신러닝이 작동하여, 상대적으로 객단가가 낮은 상품 운영에 보다 적합하며, ROAS 최적화 대비 더 많은 유저들의 구매를 기대할 수 있습니다.

또한 높은 LTV가 기대되는 산업/제품군의 경우, 구매 최적화 활용이 긍정적입니다.

초기 CPA가 다소 높을 수 있지만, 산업/서비스 특성상 반복 구매를 통한 높은 수익 창출이 가능하여, 구매 최적화를 통해 구매를 이끌어 내는 것이 중요합니다.

ROAS 최적화는 광고비가 제한적이거나 특정 ROI 목표가 있을 때, 주로 적용합니다. 구매 금액에 포커싱하여 학습하여, 비교적 구매 객단가가 높거나, 한명의 유저가 다양한 상품을 구매할 수 있는 경우에 ROAS 최적화가 적합합니다.

특히 게임 업종에서 고래 유저라는 용어를 사용하는데, 고래 유저란 일반 사용자에 비해 높은 구매력을 가지고 있으며, 한번의 결제로도 큰 금액을 소비하는 유저를 의미합니다. 장르별로 고래 유저의 비중은 다르지면, 평균적으로 1%미만, 구매 금액은 과반 내외를 차지합니다. 쇼핑 업종에서는 VVIP라고도 하는 이 고객들은 한번의 구매로도 높은 수익을 창출하여, ROAS 최적화는 이들을 타겟하여 머신 학습 진행하여 상대적으로 적은 광고 비용으로도 높은 매출을 기대할 수 있습니다.

정액제/구독형과 같은 서비스에는 ROAS 최적화 적용에 부적합 합니다.

물론 앞서 말한 상황별 예시가 100% 정답은 아닙니다. 게임 업종이라도, 구매 객단가가 낮은 편이거나, 매칭을 위한 많은 유저가 필요한 경우에는 구매 최적화 상품이 게임에는 더 적합할 수 있습니다. 예산의 여유가 있고, 가설을 테스트해보고자 한다면, 각 최적화별 A/B테스트도 하나의 방안입니다.

캠페인 성과에는 최적화 방식 뿐만 아니라, 타겟에게 소구할 메세지, 크리에이티브의 품질, 어떤 매체를 활용할지, 지면별 경쟁 상황, 시즈널리티 등 다양한 요소들이 작용합니다. 적합한 최적화를 선택하는 것은 성공적인 캠페인을 위한 하나의 옵션이지만, 각 특성을 고려하여 시행착오를 줄이고, 상황에 맞게 적용하여 우수한 성과를 거둘 수 있습니다.

그로스해킹은 말 그대로 성장(Growth)을 위해서 어떤 수단(Hacking)이든 동원하여 문제를 해결한다는 뜻입니다.

즉 그로스마케팅 또한 성장을 위해 하는 모든 마케팅이라 해석할 수 있습니다. 그로스마케팅의 세부 방법으로는 유입을 증가시키는 노출/트래픽 캠페인(퍼포먼스마케팅)이 될 수도 있고, 메인페이지의 배너 클릭률을 높이는 콘텐츠 제안이 될 수도 있고, 장바구니에서 결제 전환율을 높이는 UIUX 개선이 될 수도 있습니다. 이를 위해서는 사용자의 반응을 확인할 수 있는 데이터가 중요합니다.

최근 그로스마케팅의 중요성은 원티드의 채용 직무만 봐도 알 수 있습니다. '그로스'를 검색해보세요!

그로스마케팅을 한다고 할 때, 성장을 위해 어떤 일을 먼저 해야할까요?

대다수의 스타트업에서는 개발팀 인력이 소중합니다. 소위, 개발팀의 인풋이 부족하다고 많이들 이야기합니다. 마케팅팀에서도, 서비스기획팀에서, 디자인팀에서도, 상품팀에서도 개발팀에게 요청을 하기 때문이죠. 그렇다면 개발팀은 이들의 요청 중 누구의 업무를 먼저 해야 할까요?

정답은... 알 수 없습니다. 이 회사의 최우선순위 목표(OKR: Objective and Key Results)를 모르기 때문입니다. 목표를 정하기 위해서 AARRR Framework를 사용할 수 있습니다. AARRR의 단계 중 어느 단계를 목표로 해야할지 대략적으로 정해보는 것이죠. 우리 회사의 OKR이 '매출'이라면 2.의 업무가 우선이 되겠습니다.

마케팅을 할 때에도 이 단계에 맞춰 업무의 우선순위를 정해 일할 수 있습니다. 퍼널(Funnel)이라고도 부르는 이유는 깔대기 형태이기 때문입니다. 초반 사용자들은 많으나 단계를 거치며 사용자들의 이탈이 반복되어 마지막 지점에 남는 사용자는 급격히 적어집니다.

그냥 데려오기만 하는 (=유입시키는, 트래픽을 발생시키는) 것이 있고 데려와서 가입을 시키는 것 (=계정을 생성하는 것)을 포함하기도 합니다.

토스에서 진행하는 머니알림이 '트래픽'을 위한 경우가 많습니다. 토스의 앱푸시를 누르면 토스로 트래픽이 발생하고 (10원) 토스가 유도하는 외부 페이지로 랜딩되면 트래픽이 발생하니까요. (10원!) 이렇게 토스는 한 명의 사용자를 유입시키는 데에 20원이라는 가격을 책정하고 있는 것입니다. (물론 업체에게는 더 많이 받죠!)

29CM에 핸드폰으로 (앱을 깔지 않고) 들어가면 앱설치를 하라는 팝업이 뜹니다. 앱설치를 유도하여 이후 29CM를 더 자주 들어오기를 장려하는 것이죠.

이외 29LIVE 라는 기능을 콘텐츠로 소개하는데요. 이 때 혜택을 위해 '알림 신청'을 하게끔 합니다. 알림 신청을 해두면 앱푸시나 카카오 플러스친구로 메시지를 받게 되어 또 들어오게 되겠죠!

CRM으로 높은 할인율의 프로모션을 홍보하면서 다시 방문해달라고 유도합니다. 토스의 경우 만보기 같은 기능을 통해 사용자가 매일 매일 들어오게끔 하구요.

CRM 외에도 리타겟팅 캠페인은 퍼포먼스마케팅으로도 많이 활용됩니다. 그래서 한 번이라도 들어갔던 웹사이트의 광고가 나에게 계속 계속~~~ 뜨는 것이죠!

커머스라면 구매 전환이겠죠. 최종 목표인 만큼 이전 단계와도 밀접하게 연관되어 있습니다. 활성화(Activation)나 유지(Retention)에서도 방문으로 그치는 것이 아닌 구매 전환까지 일어날 수 있도록 혜택을 촘촘히 설계하는 것이죠.

보유한 쿠폰의 만료일이 얼마 안 남았다고 카카오톡으로 알림을 주는 CRM 캠페인도, 블랙프라이데이라고 인스타 스토리에도 광고가 엄청 뜨는데요. 이런 것이 바로 전환 캠페인이라고 할 수 있겠습니다.

카톡으로 친구에게 상품을 추천하기도 하고, 서비스 내에서 후기 작성을 독려하기도 합니다. 작성된 후기는 아직 상품을 사지 않은 사용자들에게 좋은 추천 콘텐츠가 되기 때문입니다.

위는 사용자 측면에서의 AARRR 프레임워크가 적용되는 상황이었다면, 마케터의 측면에서는 AARRR 관점에서 어떻게 업무해야할까요? 간단하게는 문제 정의와 현황 분석, 측정 지표 이해, 목표 수준 설정 및 개선안 실행으로 AARRR 프레임워크를 활용할 수 있습니다.

단계별 문제를 확인합니다.

핵심 주요 지표를 선정하고 현황을 확인합니다.

측정 지표의 의미를 이해합니다.

목표 수준을 정하고 실험을 통해 개선합니다.

추천을 받고 유입된다면 Referral이 먼저, Acquisition이 후자가 되는 것이고요. 가입하지 않고 비회원으로 상품을 구매한 후에 상품이 마음에 들어 가입을 하고 다른 상품도 차차 둘러본다면, Revenue > Acquisition > Activation의 단계를 밟은 것으로 볼 수도 있습니다.

AARRR 프레임워크를 발표한 Dave McClure도 활성화(Activation)와 유지(Retention) 이후 고객 유치(Acquisition)과 추천(Referral) 마지막으로 수익화(Revenue)의 순서를 추천하기도 했습니다. 회사의 상황에 따라 더 중요한 AARRR 단계가 있을 수 있습니다.

우리 회사는 어떤 단계의 AARRR이 가장 중요할까요? 리텐션은 나날이 감소하는데 획득에만 치중하고 있는 것은 아닐까요?

풀스택 마케팅 컨설팅펌 마티니아이오