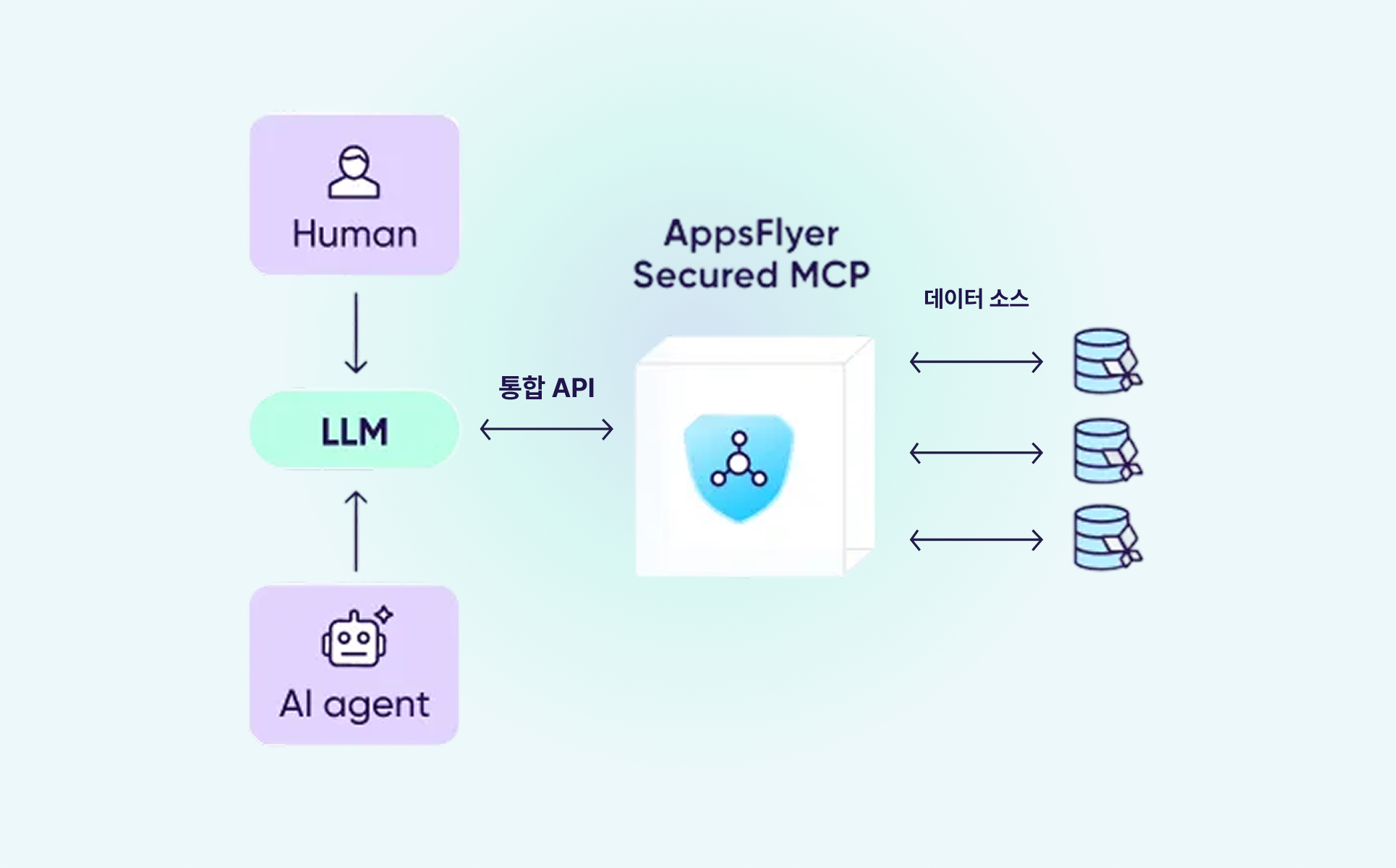

MCP(Model Context Protocol)는 AI가 외부 데이터를 활용할 수 있도록 연결해 주는 개방형 표준 프로토콜입니다. 쉽게 말해, AI 도구가 실시간으로 필요한 데이터를 가져와 활용할 수 있게 만드는 기술입니다.

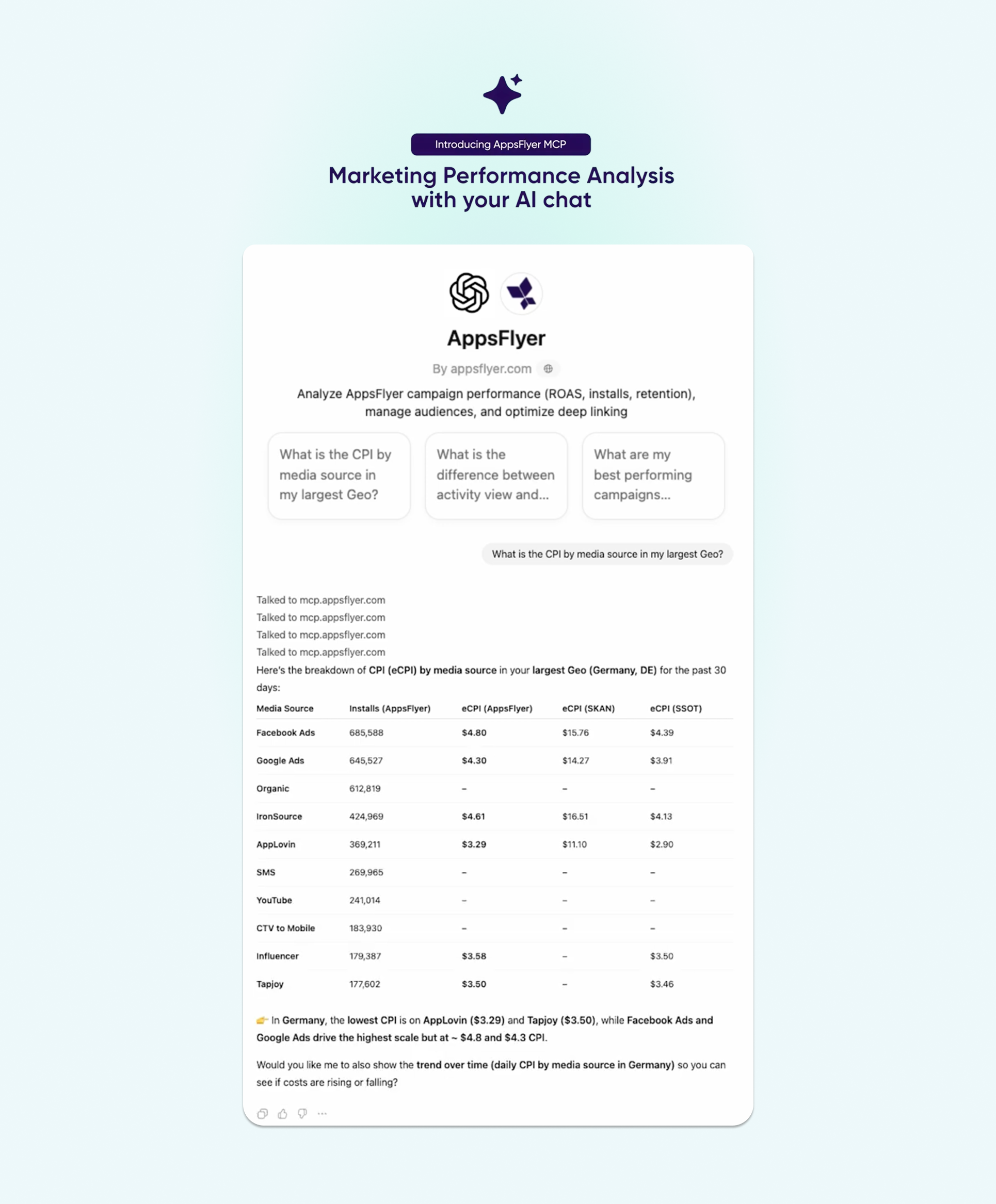

앱스플라이어는 이 기술을 활용해 자연어만으로 마케팅 데이터에 바로 접근 가능한 MCP를 선보였습니다. Claude, ChatGPT 같은 AI 도구와 앱스플라이어를 연결하면, 캠페인 성과 분석부터 오디언스 관리, 딥링크 문제 해결까지 질문만으로 처리할 수 있습니다.

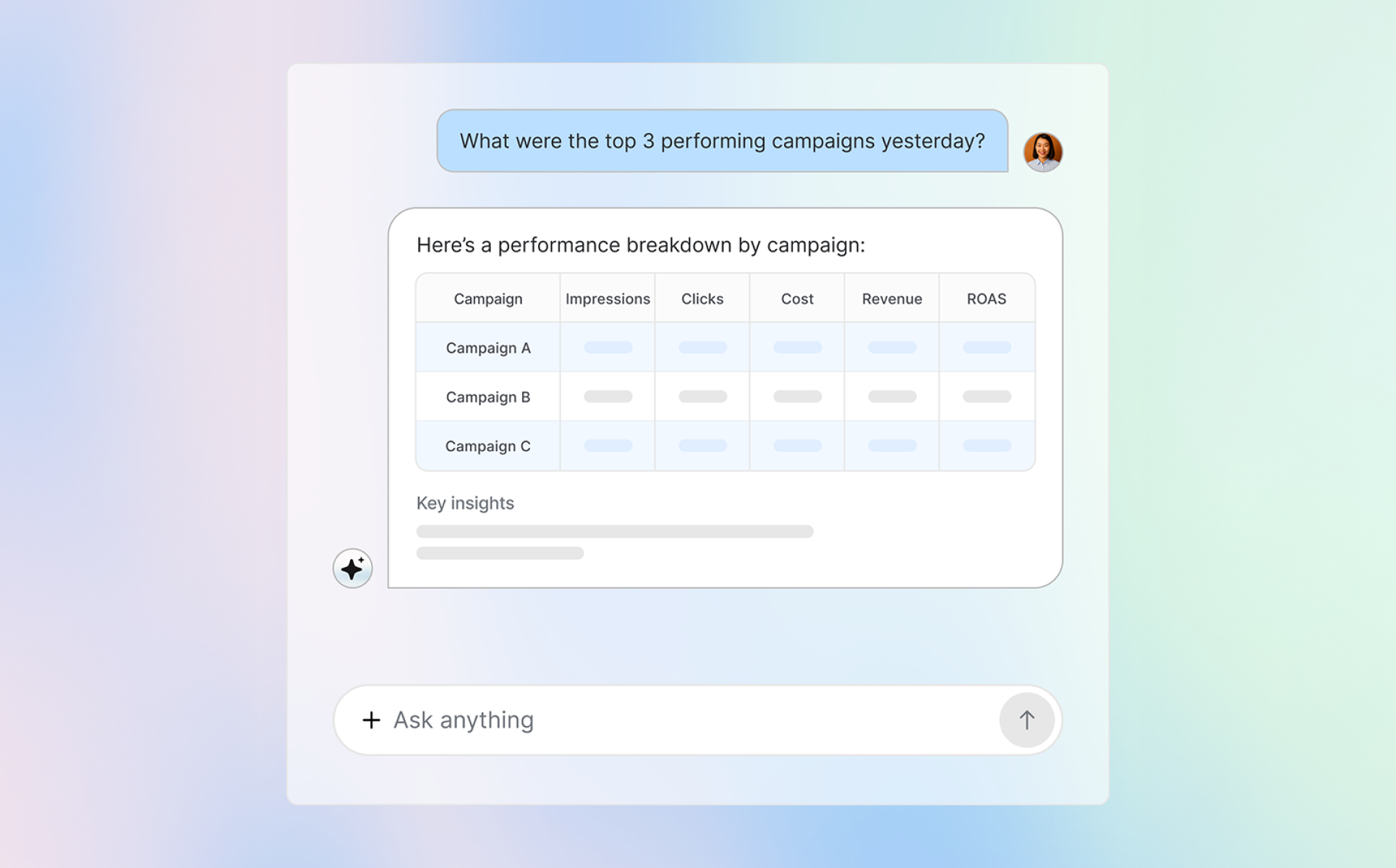

또한 앱스플라이어 MCP는 기술적 배경과 관계없이 누구나 필요한 데이터를 즉시 확인할 수 있도록 지원합니다. 사용자가 직접 질문하든, AI 에이전트에게 작업을 맡기든, 대기 시간 없이 명확한 정보와 실행 결과를 바로 받아볼 수 있습니다.

앱스플라이어 MCP는 Claude, ChatGPT, Gemini 같은 사용자가 선호하는 LLM(Large Language Model) 도구와 앱스플라이어를 연결합니다. 사용자가 질문을 입력하면 MCP가 자동으로 필요한 데이터를 찾아 이해하기 쉬운 형태로 보여줍니다. 어트리뷰션, 분석, 오디언스, OneLink(원링크) 등 앱스플라이어의 모든 기능을 자연어로 바로 활용할 수 있습니다.

또한 앱스플라이어는 7,000개 이상의 주요 브랜드가 신뢰하는 풍부하고 정확한 데이터를 제공하기 때문에 개인정보 보호를 철저히 준수하며 마케터가 필요한 인사이트를 즉시 확인하고 빠르게 의사결정을 내릴 수 있도록 돕습니다.

앱스플라이어 MCP는 개방형 구조로 설계되어 있어, 원하는 방식으로 커스터마이징할 수 있습니다. 미디어 믹스를 최적화하는 AI를 만들거나, 오디언스를 자동으로 관리하는 시스템을 구축하거나, 내부 도구에 MCP를 연결하는 등 복잡한 설정 없이도 필요한 기능을 유연하고 자유롭게 구현할 수 있습니다.

채널별 ROAS를 확인하고 싶거나, 어떤 캠페인이 가장 높은 LTV를 만드는지 알고 싶을 때 앱스플라이어 MCP를 활용해 보세요. 질문만 입력하면 필요한 데이터를 바로 확인할 수 있습니다.

앱스플라이어 MCP는 사람이 직접 질문하거나 AI 에이전트가 자동으로 작업하는 방식 모두 지원합니다. Growth, CRM, 제품, 마케팅 팀 등 어떤 팀이든 별도의 설정이나 개발 작업 없이 필요한 인사이트를 바로 확인할 수 있습니다.

앱스플라이어 MCP는 앱스플라이어의 어트리뷰션 기술을 기반으로 만들어졌습니다. 모든 데이터는 개인정보 보호 규정을 철저히 준수하며, 설계 단계부터 암호화와 보안을 적용했습니다.

캠페인 성과를 실시간으로 확인하고, ROI를 비교할 수 있습니다. 채팅창에서 직접 확인하거나, AI 에이전트를 활용해 성과 모니터링부터 최적화, 작업 실행까지 자동으로 처리하세요.

오디언스가 어떻게 나뉘고 활용되는지 한눈에 확인할 수 있습니다. 질문만으로 오디언스 현황을 조회하거나 실시간 성과를 분석할 수 있으며, 중복된 오디언스를 찾아내고 개선 방안을 제안하는 AI를 직접 만들 수도 있습니다. 필요하다면 여러 채널의 오디언스 정보를 자동으로 동기화하거나 작업을 실행할 수도 있습니다.

대화형 인터페이스로 OneLink 템플릿과 링크 동작을 간편하게 점검하거나, 에이전트를 활용해 링크 상태를 지속적으로 모니터링할 수 있습니다. 문제가 있는 링크를 자동으로 찾아내고, 모든 캠페인이 올바르게 운영되도록 관리할 수 있습니다.

앱 설정이나 구현 방법이 궁금할 때 질문만으로 바로 확인할 수 있습니다. AI 어시스턴트가 설정 오류를 찾아내 해결 방법을 알려주거나, 상황에 맞는 가이드 문서를 자동으로 보여줍니다.

앱스플라이어 MCP는 AI 기반 마케팅을 향한 중요한 첫걸음입니다. 사람의 창의성과 AI의 분석 능력이 결합되면, 마케터는 더 나은 의사결정을 내릴 수 있습니다.

MCP는 캠페인 분석, 오디언스 확인, 딥링크 관리 같은 마케터들의 핵심 업무를 지원하고 있으며, 추후 예측 분석과 에이전트 기반 자동화까지 확대 될 예정입니다. 데이터 기반으로 더 빠르고 정확한 의사결정을 내리고 싶다면, 지금 바로 앱스플라이어 MCP를 경험해 보세요.

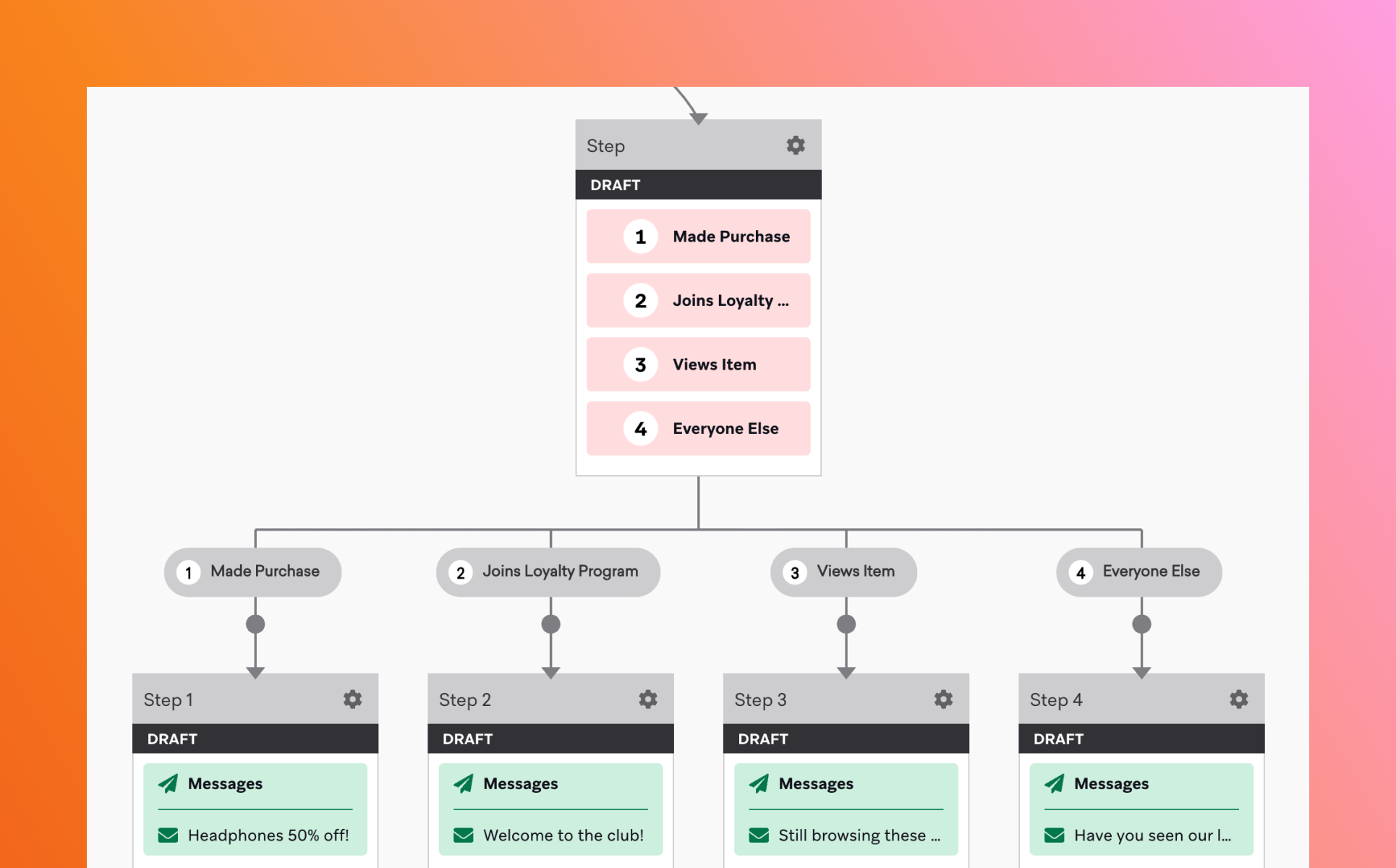

브레이즈 캔버스(Canvas)는 고객의 행동과 속성을 기준으로 개인화된 메시지 흐름을 설계하는 고객 여정 오케스트레이션 도구입니다. 단일 캠페인이 하나의 캠페인을 특정 조건에 따라 발송하는 데 초점을 맞춘다면, 캔버스는 고객의 행동에 따라 여러 메시지와 채널을 유기적으로 연결합니다.

예를 들어, 회원가입 후 7일까지의 유저 저니 설계, 첫 구매까지의 지속적인 구매 유도 메시지 발송 등 단일 순간에 그치지 않고 지속되는 기간 동안 유저 저니에 따라 메시지를 보낼 수 있습니다.

캔버스를 활용하면, CRM 마케팅을 ‘단발성 메시지 발송’에서, 지속적인 고객 경험 관리로 확장할 수 있습니다.

특히 고객 행동이 빠르게 변화하는 환경에서는, 잘 설계된 캔버스가 마케터의 반복적인 운영 부담을 크게 줄여줍니다.

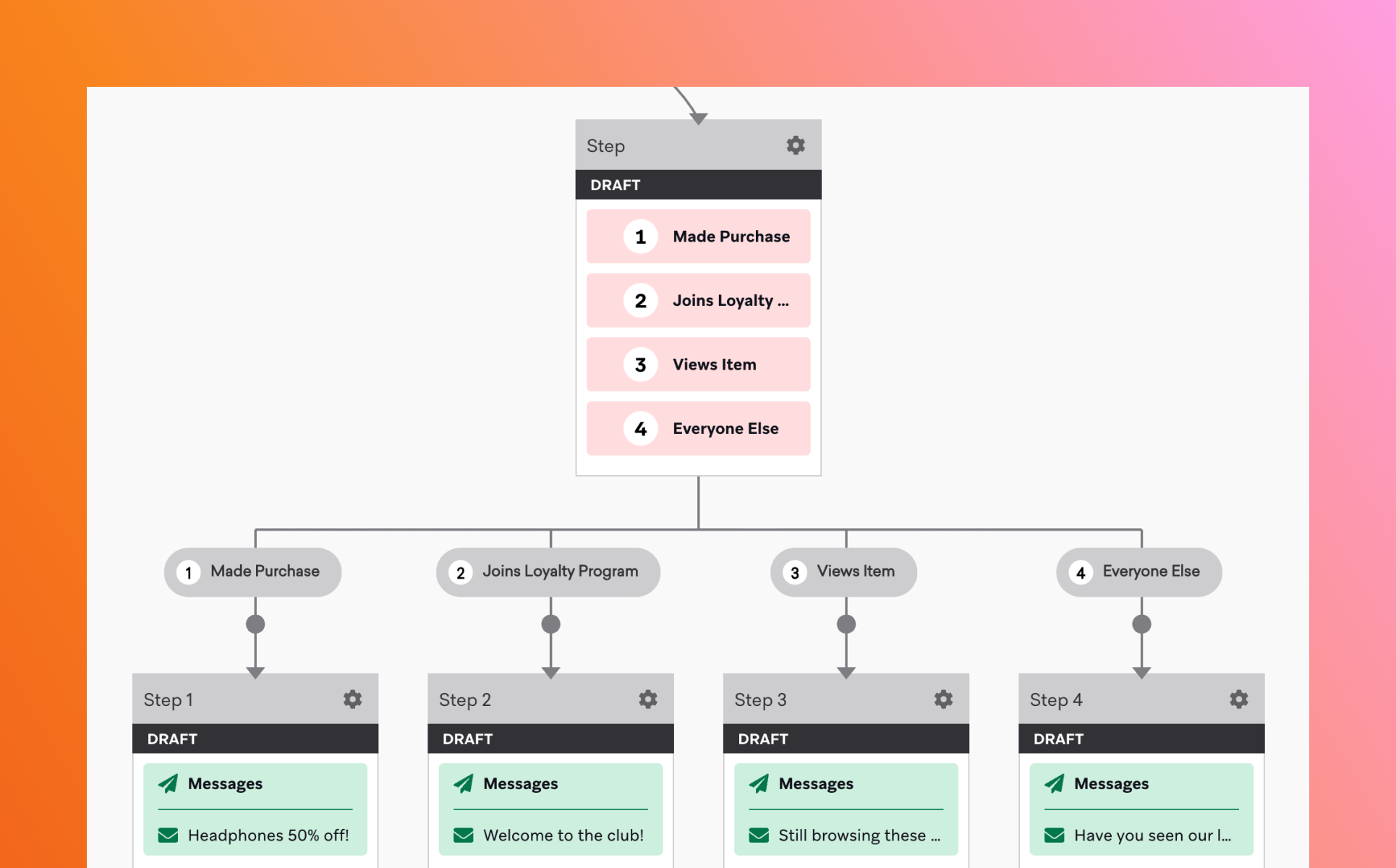

브레이즈 캔버스는 크게 진입 조건(Entry), 액션(Step), 분기(Split)으로 이루어져 있습니다.

해당 속성을 잘 활용하면, CRM 마케터는 하나의 캔버스 안에서 다양한 시나리오를 운영할 수 있습니다. 그뿐만 아니라 고객의 입장에서도 ‘자연스러운 경험’이 가능해져 더 높은 전환 성과를 기대할 수도 있습니다.

브레이즈 캔버스는 강력한 도구이지만, 설계 목적이 명확하지 않으면 오히려 캠페인 운영이 복잡해질 수 있습니다. 하나의 캔버스에는 하나의 목표를 두고, 온보딩•전환•리텐션 등 목적별로 캔버스를 분리해 설계하는 것이 효과적입니다.

또한, 지나치게 많은 분기와 조건은 운영 중 오류나 누락을 유발할 수 있습니다. 초기에는 단순한 구조로 시작하고, 성과와 데이터를 기반으로 점진적으로 고도화하는 방법이 안정적입니다.

마지막으로 데이터 반영 시점을 고려하여 적절한 대기 시간과 조건을 설정해야 합니다.

캔버스는 한 번 만들고 끝나는 것이 아니라, 운영 후 지속적으로 점검하고 개선해야 성과로 이어집니다.

CRM 마케팅의 중요성이 높아지면서, 많은 기업에서 브레이즈(Braze)를 활용해 CRM 마케팅을 진행하고 있습니다. 간단하게는 푸시 메시지 발송부터, 깊게는 캠페인 자동화까지. 브레이즈는 많은 CRM 마케터들에게 익숙한 도구가 되었습니다. 하지만 실제로 현장에서 듣는 이야기는 조금 다릅니다.

“기능은 많은데, 어디까지 쓰고 있는지 모르겠다”

”이 정도면 잘 쓰고 있는 건지 감이 안 온다”

브레이즈를 사용하는 것과 잘 ‘활용’하는 것은 다른 문제이기 때문입니다.

마티니는 이러한 고민에서 출발해, 브레이즈 활용도를 자가진단 해볼 수 있는 질문을 마련했습니다. 자가진단의 목적은 단순히 점수를 매기는 것이 아니라, 현재 우리 팀의 CRM 운영이 어느 단계에 와 있는지, 그리고 다음 단계로 나아가기 위해 무엇이 필요한지를 스스로 인식할 수 있도록 돕는 데 있습니다.

실제로 자가진단에 참여한 기업들을 살펴보면, 캠페인과 자동화는 잘 운영되고 있지만, 데이터 활용, AI 기능, 신규 채널(RCS 등)은 아직 충분히 활용되지 못하고 있는 경우가 많았습니다.

브레이즈를 사용하고 있다면, 이제는 ‘얼마나 잘 활용하고 있는지’를 점검해야 할 시점입니다. 지금 바로 우리 팀의 브레이즈 활용도를 진단해 보세요.

자가진단 점수 구간에 따라 현재 브레이즈 활용도가 어느 수준인지 쉽게 확인해볼 수 있습니다. 결과 페이지에서는 현재 활용 단계에 따른 제안도 함께 확인해볼 수 있습니다.

마티니가 정리한 브레이즈 활용 인사이트와 실제 사례를 통해, CRM을 한 단계 더 고도화하는 방법을 확인해 보세요.

%20(1).webp)

CRM 마케팅은 'Customer Relationship Management Marketing'의 약자로, 기존 고객과의 관계를 체계적으로 관리하고 강화하는 마케팅 활동을 의미합니다.

신규 고객을 유입시키는 퍼포먼스 마케팅과 달리, CRM 마케팅은 이미 우리 서비스를 경험한 고객들이 다시 찾아오도록 만드는 것에 집중합니다.

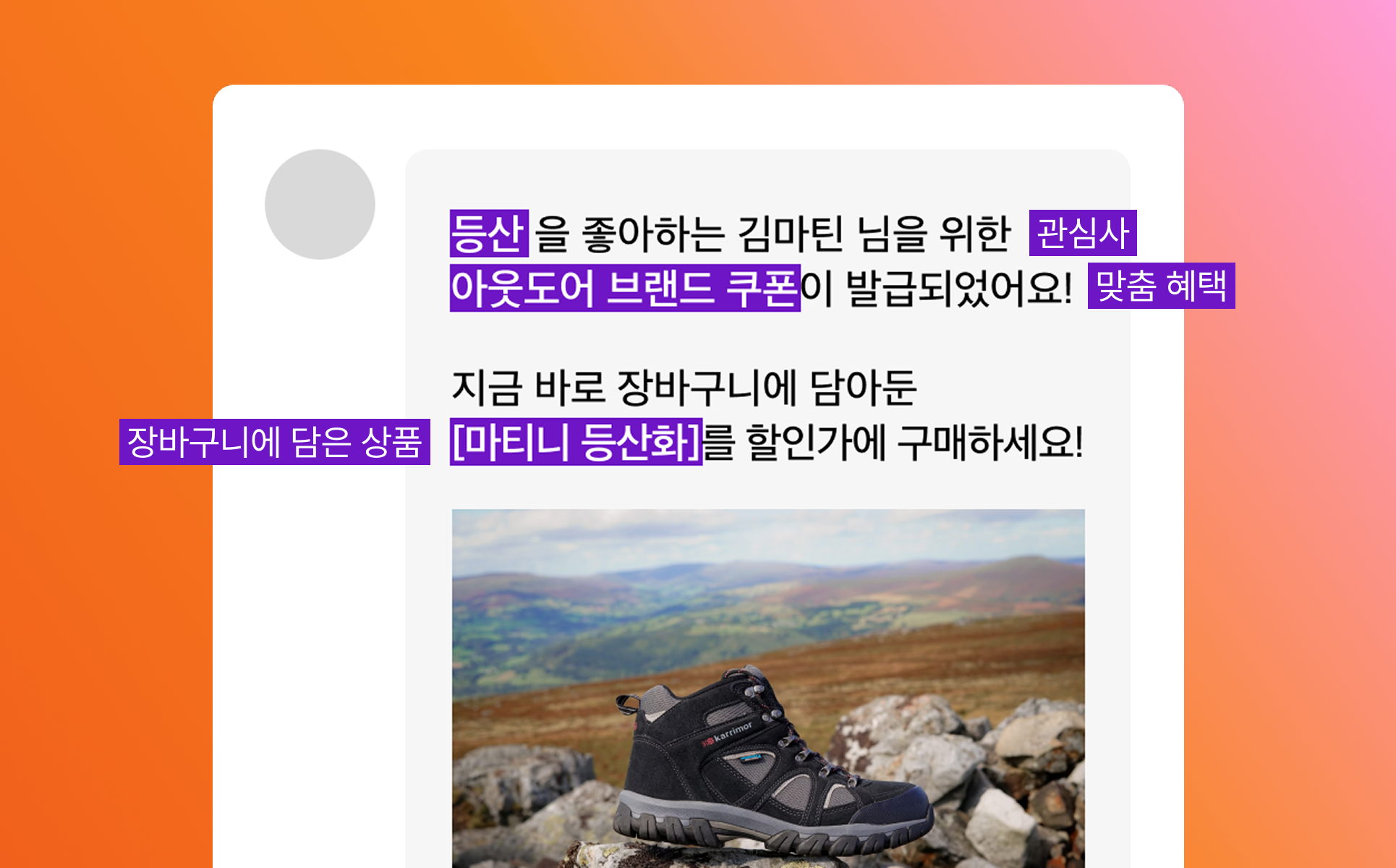

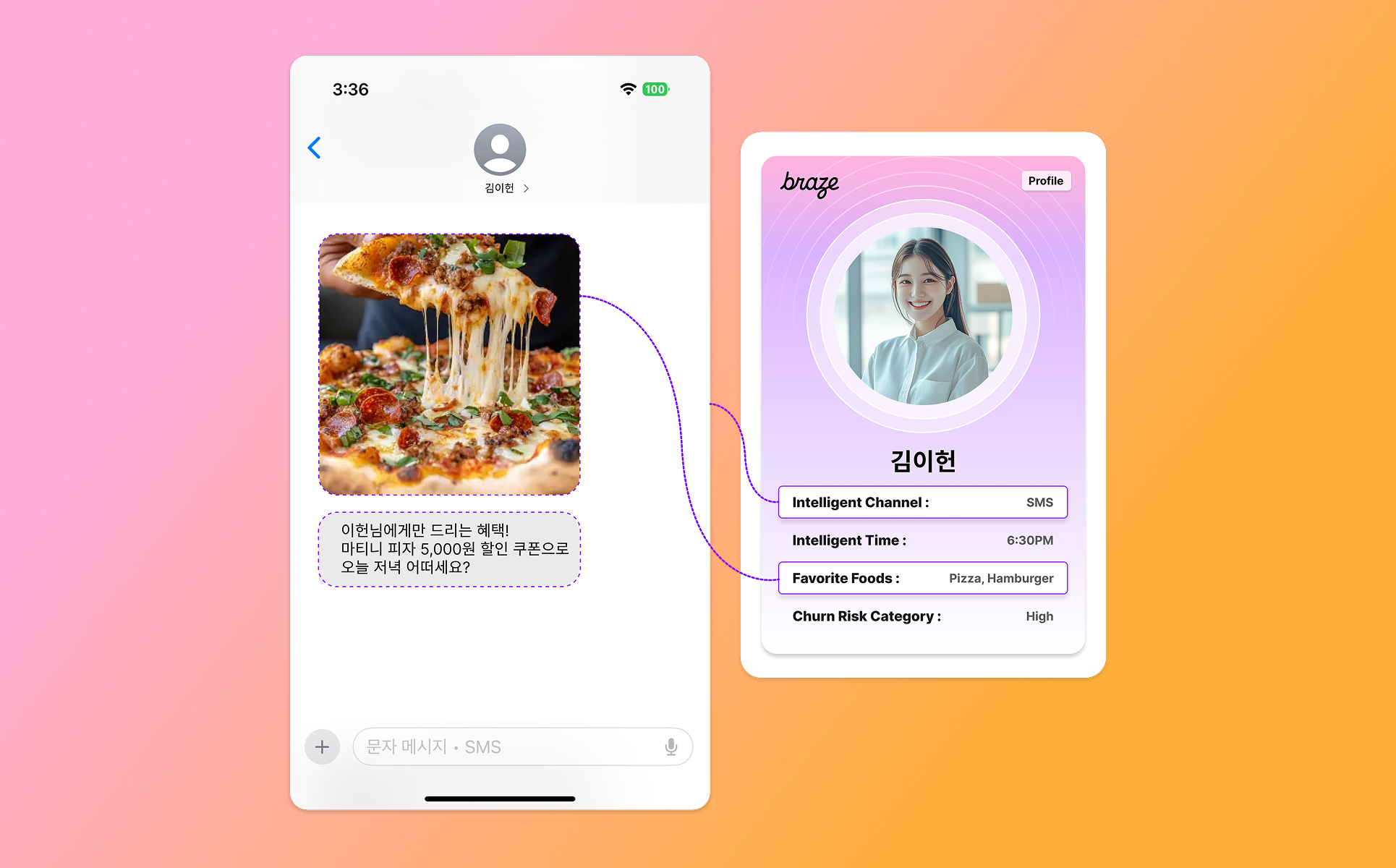

CRM 마케팅의 핵심은 '적절한 시점에, 적절한 채널로, 개인화된 메시지를 전달하는 것'입니다. 고객의 구매 이력, 관심사, 행동 패턴을 분석해 각 고객에게 필요한 정보를 적절한 시점에 전달합니다. 이를 통해 자연스럽게 재방문과 재구매를 유도하고, 궁극적으로 브랜드 충성도를 높일 수 있습니다.

✅ 고객 생애 가치(LTV) 증대

고객 생애 가치는 한 명의 고객이 우리 서비스를 이용하는 전체 기간 동안 발생시키는 총 수익을 의미합니다. CRM 마케팅은 이 LTV를 극대화하는 것을 최우선 목표로 합니다. 단 한 번의 구매로 끝나는 것이 아니라, 지속적인 관계를 통해 장기 고객으로 만드는 것이 핵심입니다.

✅ 재구매율 및 충성도 향상

한 글로벌 연구에 따르면, 기존 고객의 재구매율을 5% 높이면 수익이 25%에서 95%까지 증가할 수 있다는 연구 결과가 있습니다. CRM 마케팅은 고객이 우리 브랜드를 다시 선택하도록 만드는 활동입니다. 개인화된 추천, 맞춤형 할인, 적시의 리마인드 메시지를 통해 고객이 자연스럽게 재방문하도록 유도합니다.

✅ 이탈 방지 및 휴면 고객 재활성화

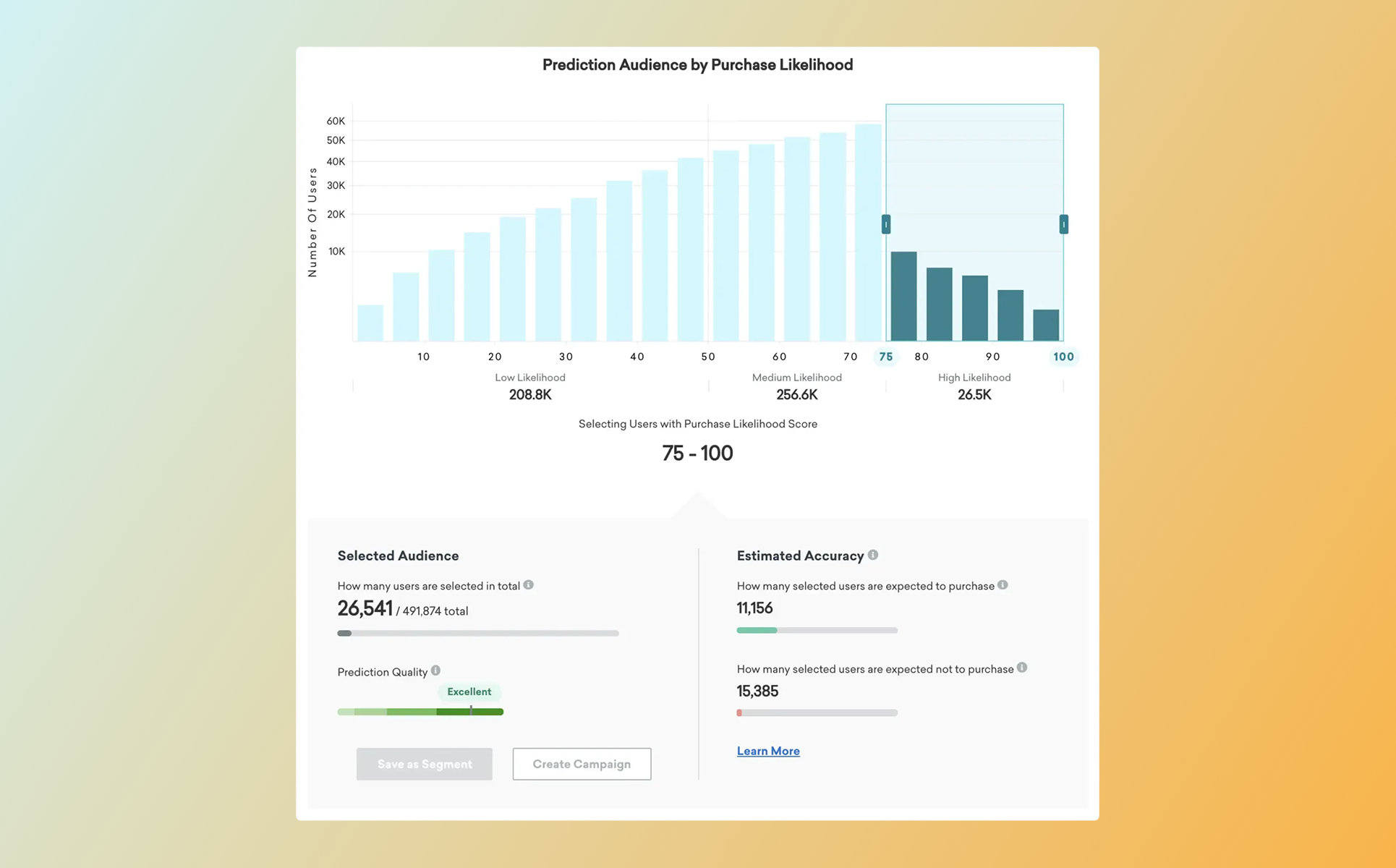

서비스를 이용하다가 일정 기간 활동이 없는 휴면 고객, 혹은 이탈 위험이 높은 고객을 사전에 파악하고 적절한 메시지를 보내는 것도 CRM 마케팅의 중요한 역할입니다. 예측 모델을 활용해 이탈 가능성이 높은 고객을 미리 감지하고, 특별한 혜택이나 맞춤형 콘텐츠로 다시 관심을 끌어낼 수 있습니다.

예시 ) Braze - Predictive Churn 기능

.png)

1. 앱 푸시 알림 (APP PUSH)

모바일 앱을 보유한 서비스에서 가장 즉각적인 반응을 이끌어낼 수 있는 채널입니다. 실시간으로 고객에게 도달할 수 있지만, 과도한 발송은 오히려 앱 삭제로 이어질 수 있어 신중한 전략이 필요합니다.

2. 인앱 메시지 (IAM)

고객이 앱을 사용하는 중에 표시되는 메시지입니다. 푸시 알림과 달리 앱 내에서만 보이기 때문에 상대적으로 덜 방해가 되며, 특정 화면이나 행동에 맞춰 맥락에 맞는 메시지를 전달할 수 있습니다.

3. 카카오톡

한국 시장에서 가장 높은 도달률을 자랑하는 채널입니다. 알림톡과 브랜드메시지를 활용해 고객에게 정확하게 메시지를 전달할 수 있으며, 특히 거래 관련 안내나 중요한 공지사항 전달에 효과적입니다.

.png)

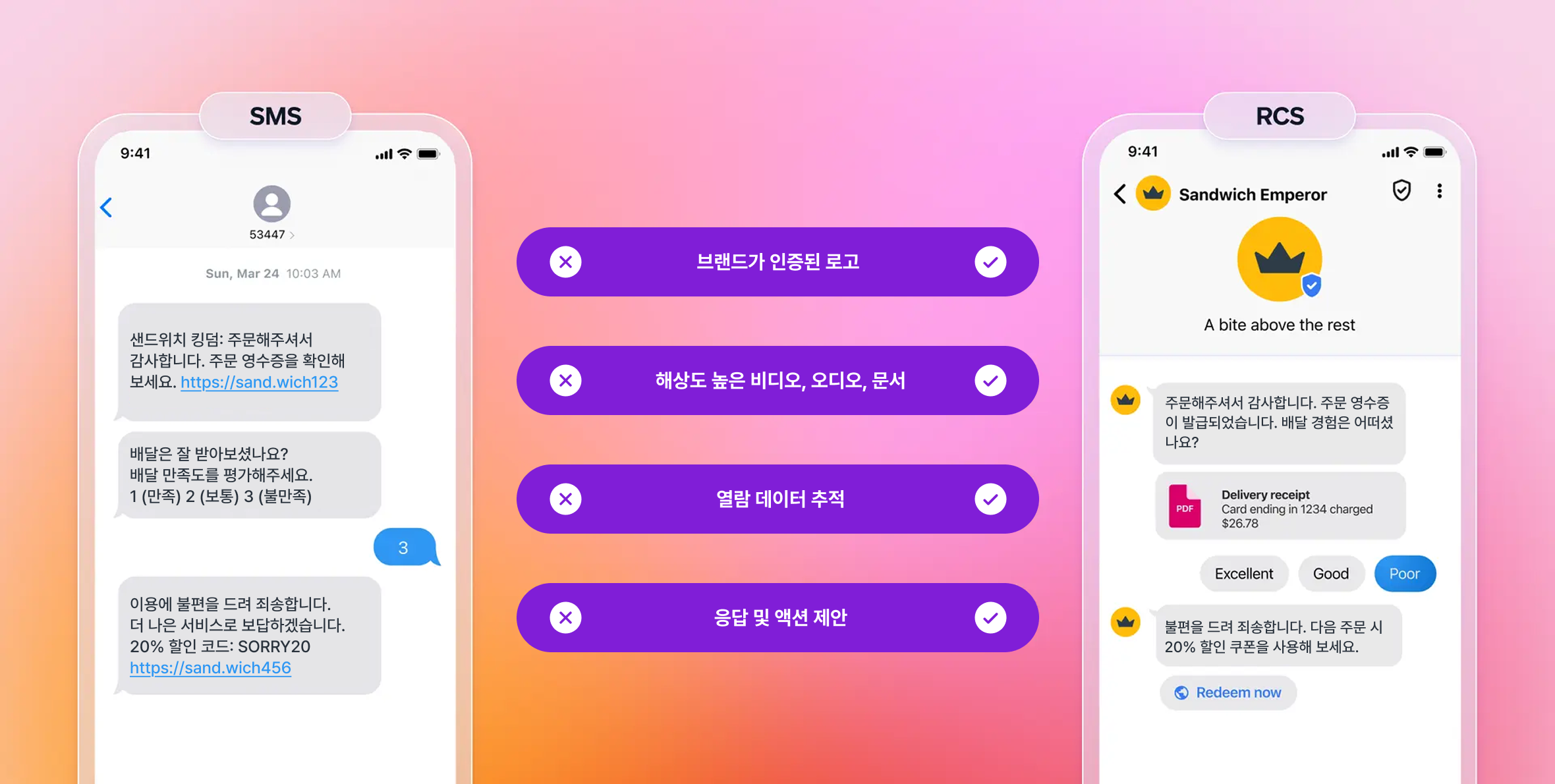

4. SMS

가장 기본적인 CRM 마케팅 채널로, 핸드폰 문자메시지를 통해 앱을 설치하지 않은 고객에게도 도달할 수 있어 본인 인증이나 긴급 안내 등에 활용됩니다.

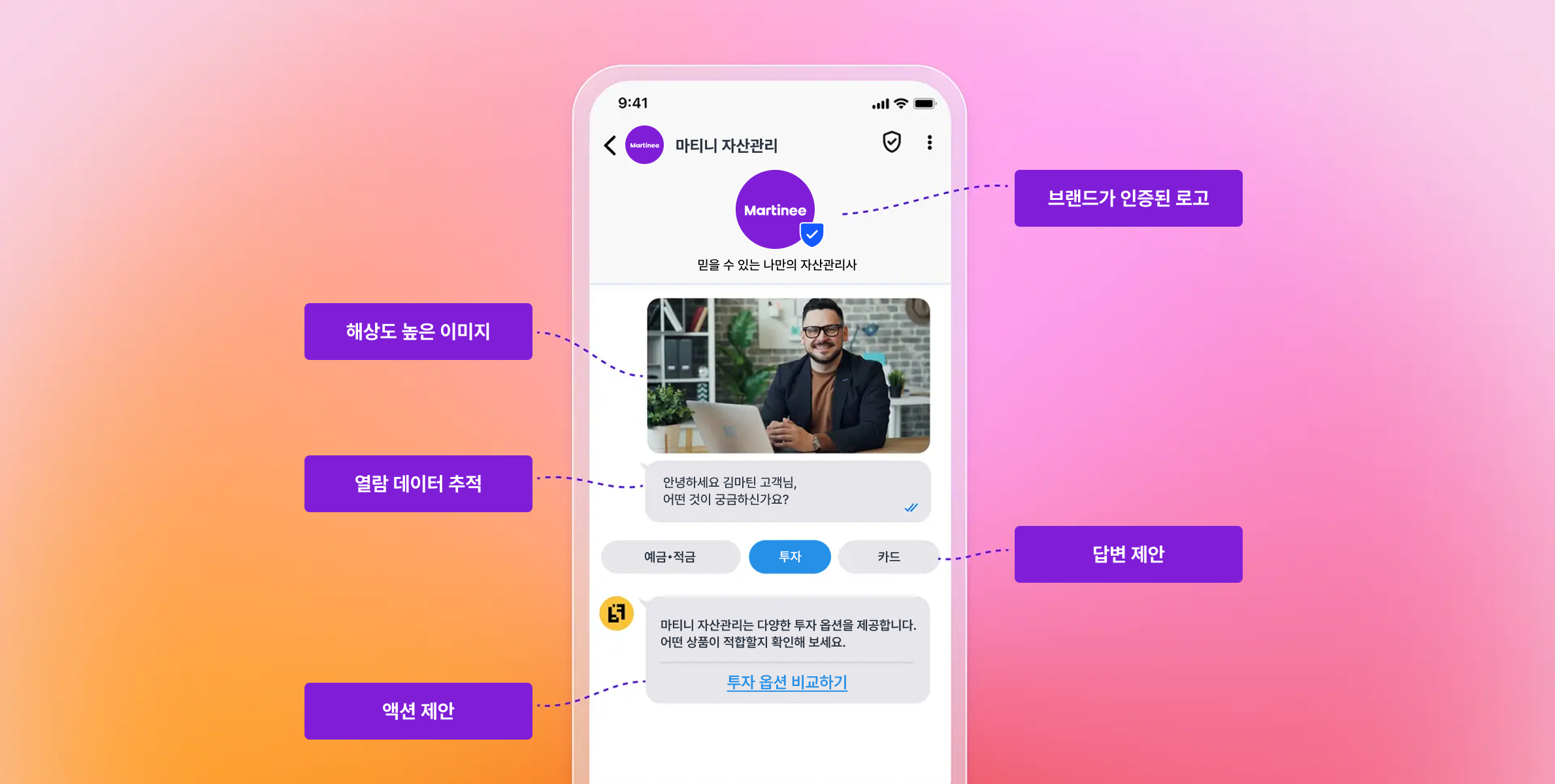

5. RCS

RCS(Rich Communication Services)는 기존 SMS의 진화된 형태로, 텍스트뿐만 아니라 이미지, 동영상, 버튼, 카드형 레이아웃 등 풍부한 콘텐츠를 전송할 수 있는 차세대 메시징 서비스로, 실시간 양방향 소통을 통해 기존 SMS 대비 높은 전환율을 달성하기 위한 목적으로 활용됩니다.

6. 이메일

가장 전통적이면서도 여전히 강력한 CRM 채널입니다. 상대적으로 긴 메시지를 전달할 수 있고, 시각적으로 풍부한 콘텐츠를 구성할 수 있습니다. 뉴스레터, 프로모션 안내, 장바구니 이탈 방지 메시지 등 다양한 목적으로 활용됩니다.

%20(1).webp)

1. 데이터 수집 및 통합

CRM 마케팅의 시작은 고객 데이터입니다. 회원 가입 정보, 구매 이력, 앱 내 행동, 웹사이트 방문 기록 등 다양한 접점에서 발생하는 데이터를 수집하고 통합해야 합니다. 이 과정에서 MMP나 CDP와 같은 데이터 통합 솔루션을 활용하면 효율적으로 데이터를 관리할 수 있습니다.

2. 고객 세그먼테이션

수집한 데이터를 바탕으로 고객을 의미있는 그룹으로 나눕니다. 신규 가입자, 활성 유저, 휴면 고객, VIP 고객 등 행동 패턴과 특성에 따라 세그먼트를 구성합니다. 세그먼트가 정교할수록 더 효과적인 메시지를 전달할 수 있습니다.

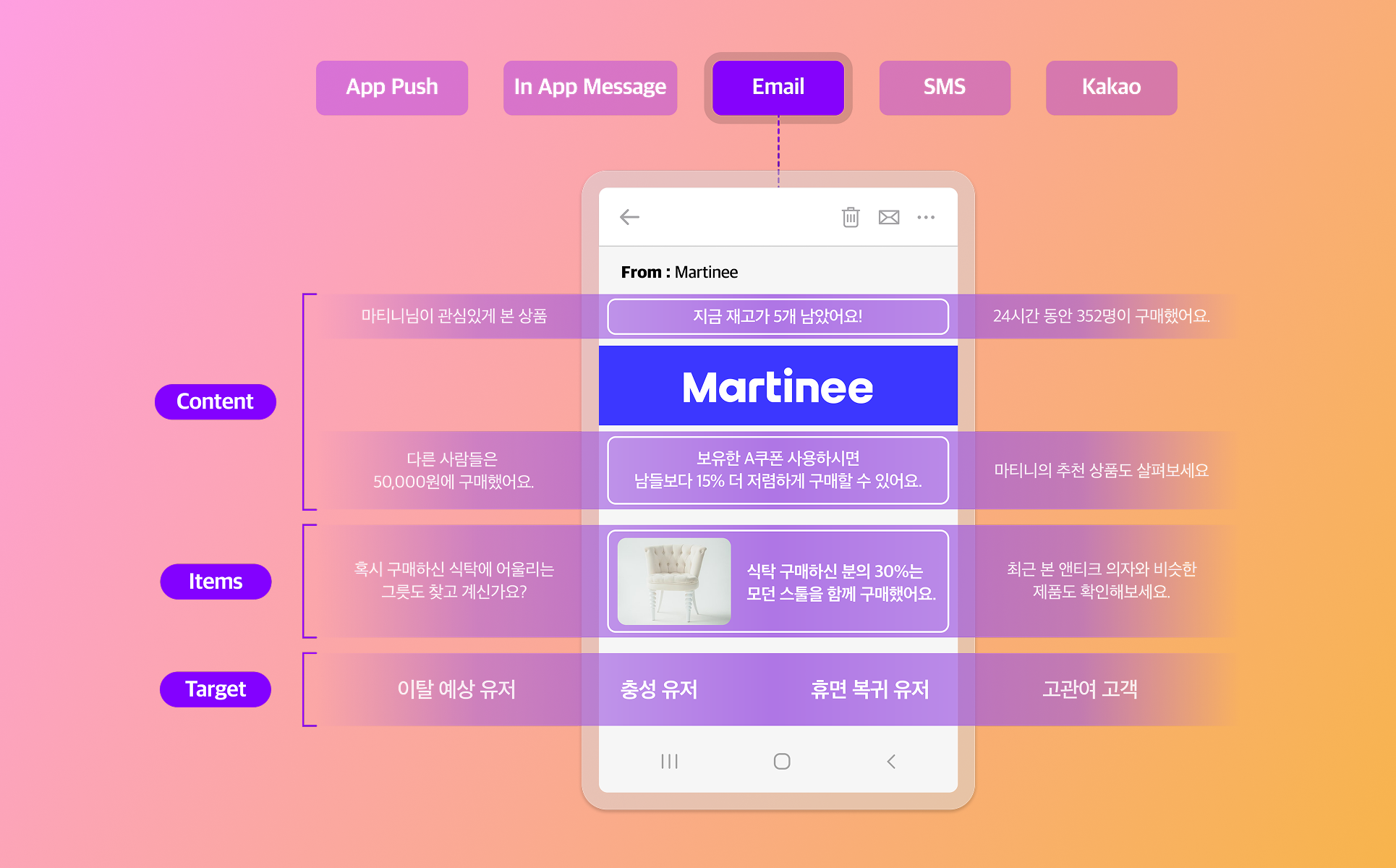

3. 메시지 개인화 및 자동화

각 세그먼트에 맞는 메시지를 설계합니다. 단순히 이름을 넣는 수준을 넘어, 고객의 최근 조회 상품, 구매 이력, 선호 카테고리 등을 활용해 실질적으로 관련성 높은 콘텐츠를 제공합니다. 이 과정을 자동화하면 마케터의 리소스를 크게 절감하면서도 대규모로 개인화를 구현할 수 있습니다.

4. 성과 측정 및 최적화

발송한 메시지의 오픈율, 클릭률, 전환율을 측정하고 지속적으로 개선합니다. A/B 테스트를 통해 어떤 메시지, 어떤 시간대, 어떤 채널이 가장 효과적인지 파악하고, 이를 다음 캠페인에 반영합니다.

CRM 솔루션을 선택할 때는 현재 우리 조직의 데이터 인프라, 마케팅 성숙도, 예산, 그리고 향후 확장 가능성을 종합적으로 고려해야 합니다. 단순히 기능이 많다고 좋은 것이 아니라, 우리 팀이 실제로 활용할 수 있는 수준의 솔루션을 선택하는 것이 중요합니다.

.webp)

1. 다른 마케팅 툴과의 연동 지원

기존에 사용하던 데이터 웨어하우스, 분석 도구, 광고 플랫폼 등과 원활하게 연동되는지 확인해야 합니다. 양방향 데이터 동기화를 지원하면 모든 마케팅 툴 간 데이터가 실시간으로 공유되어 통합된 고객 경험을 제공할 수 있습니다.

2. 실시간 데이터 반영

고객의 행동에 즉각적으로 반응할 수 있어야 의미있는 전환을 만들어낼 수 있습니다. 스트리밍 아키텍처 기반의 솔루션이라면 고객이 특정 행동을 한 즉시(1초 미만) 데이터가 반영되어 적시에 메시지를 발송할 수 있습니다. 실시간 데이터 연동은 CRM 마케팅의 필수 요소입니다.

3. 맞춤형 개인화 구현 가능 여부

단순한 {고객명}, {아이템명} 수준을 넘어 고객의 행동, 선호도, 구매 이력을 실시간으로 메시지에 반영할 수 있는지 확인해야 합니다.

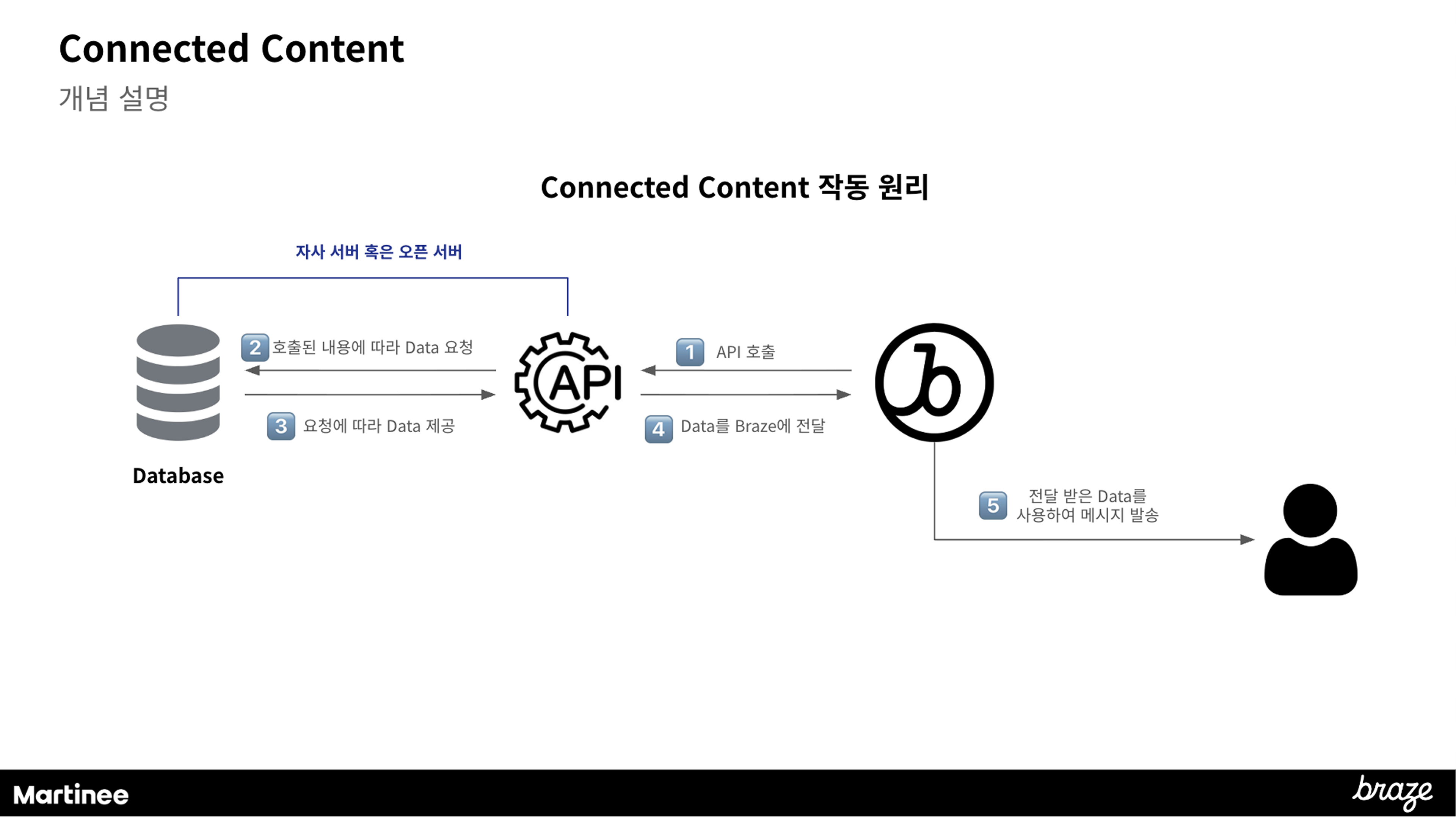

예를 들어 가장 대표적인 CRM 솔루션, 브레이즈의 Liquid 기능을 활용하면 고객의 최근 조회 상품, 장바구니 내역을 자동으로 메시지에 삽입할 수 있으며, Connected Content를 통해 외부 API 데이터(재고 현황, 날씨 정보, 환율 등)까지 실시간으로 연동해 더욱 정교한 개인화가 가능합니다.

4. 비즈니스 환경에 적합한 다양한 메시지 채널 보유

국내 시장이라면 카카오톡, 글로벌 시장이라면 이메일과 SMS, 앱 서비스라면 푸시 알림과 인앱 메시지 등 우리 비즈니스에 필요한 채널을 지원하는지 확인해야 합니다. 하나의 플랫폼에서 모든 채널을 통합 관리할 수 있다면, 일관된 고객 경험을 제공하면서도 운영 효율을 크게 높일 수 있습니다.

5. A/B 테스트 및 성과 측정 기능

메시지 문구, 발송 시간, 크리에이티브 등을 테스트하고 데이터 기반으로 의사결정할 수 있는 기능이 필수입니다. 실시간 대시보드를 통해 캠페인 성과를 즉시 확인하고, 필요시 즉각 조정할 수 있어야 합니다.

CRM 마케팅을 성공적으로 실행하기 위해서는 적합한 솔루션 선택이 중요합니다. 마티니에서는 CRM 마케팅 솔루션 선택 기준부터 실제 활용 사례, 그리고 브레이즈를 비롯한 다양한 솔루션에 대한 심층 정보를 제공하고 있습니다.

CRM 마케팅 전략 수립이나 솔루션 도입을 고민 중이라면, 지금 아래에서 마티니의 다른 콘텐츠도 함께 살펴보세요.

🔗 브레이즈(Braze)란? 브레이즈 핵심 기능 알아보기

🔗 CRM 마케팅을 준비할때 놓치기 쉬운 3가지 알아보기

🔗 떨어지는 CRM 성과, 어떻게 개선할까? RCS 알아보기

.png)

마티니 CRM팀은 브레이즈와 같은 CRM 솔루션 도입을 지원하고

개인화된 캠페인을 실행하며, 자동화 환경을 구축하는 조직입니다.

그 중 최영아, 김찬희님은 CRM팀의 파트 리더로서 팀을 이끌고 있는데요.

입사 2년 차, 1년 차에 다양한 CRM 캠페인을 리딩하고 내부 교육과 외부 컨퍼런스 발표까지 경험한 두 리더 분께, 마티니에서의 성장, CRM이라는 일, 그리고 함께 일하고 싶은 사람에 대해 들어보는 시간을 가졌습니다.

최영아:

다양한 버티컬의 CRM을 경험해 보고 싶었어요. 마티니는 대행사다 보니 여러 산업의 고객사를 경험할 수 있을 거라고 생각했고, 그 점이 가장 매력적이었어요.

입사 후에는 패션 커머스 ‘웍스아웃’ CRM 캠페인을 처음 맡았는데,

온보딩 교육을 들으면서 제가 알고 있던 Braze 활용이 정말 극히 일부였다는 걸 깨달았어요.

이전 회사에서는 단순히 푸시나 메시지를 발송하는 수준이었다면,

마티니에서는 유저 데이터를 기반으로 훨씬 정교한 개인화와 전략 설계가 가능하다는 걸 알게 됐죠.

김찬희:

저는 기술적인 스킬을 채우고 싶어서 마티니를 선택했어요.

실제로 마티니에서 Liquid, Connected Content 교육을 듣고 기술적으로 부족한 부분을 할 수 있게 되면서 기획의 폭도 확 넓어졌습니다. 예전에는 머릿속 아이디어를 기술적으로 구현하지 못해 포기했다면, 이제는 생각한 것을 실제로 만들어낼 수 있게 된 거죠.

입사하고 나서는 웍스아웃 캠페인을 인수인계 받았는데, 기존 캠페인을 새로운 시각으로 바라볼 수 있어서 재미있었어요. '이렇게도 해볼 수 있지 않을까?' 싶은 아이디어를 많이 제안했어요. 실제로 제 생각이 반영되고, 구현할 수 있게 되는 과정이 인상 깊었습니다.

최영아:

주니어일 때는 늘 질문을 하는 입장이었는데, 파트 리더가 되고 나서는 질문을 받는 입장이 되더라고요. 특히 파트원들이 던지는 질문 중에는 저도 미처 생각하지 못했던 포인트들이 많아서, 그럴 때마다 다시 찾아보고 공부하게 돼요.

예를 들면, iOS와 Android의 UX 차이 때문에 인앱 메시지 성과가 다르게 집계되는 케이스가 있었어요. iOS 유저다 보니 iOS 기준으로만 생각하면서 놓쳤던 지점이었죠.

마티니는 팀 전체가 계속 배우려는 분위기라서, 이렇게 다양하고 자유롭게 오가는 질문들이 오히려 성장의 원동력이 되는 것 같아요.

김찬희:

저는 하드 스킬과 소프트 스킬 모두 성장했다고 느껴요.

처음에는 ‘내 실무를 얼마나 잘하느냐’에만 집중했다면, 지금은 팀 전체를 보면서 ‘이 분은 어떤 일을 할 때 가장 잘할 수 있을까’도 함께 고민하게 됐어요. 리더가 되면서 실무의 전반적인 맥락을 빠르게 이해하고 파트원이 스스로 답을 찾을 수 있도록 질문을 던지는 역할이 중요하다는 것도 알게 됐고요.

김찬희:

마티니 CRM 팀은 단순히 메시지를 발송하는 팀이 아니에요. 고객의 경험을 설계해서 비즈니스 성장을 이끄는 일을 합니다.

적지 않은 분들이 CRM을 '푸시 문구 잘 쓰는 일'로 생각하시는데, 사실 메시지는 수단일 뿐이에요. 진짜 중요한 건 '비즈니스 목표와 고객의 니즈가 만나는 지점'을 찾는 거죠.

그 접점에 고객이 필요한 메시지를 보내서 서비스의 가치를 느끼게 하고, 결국 서비스 안에서의 고객 가치를 높이는 전 과정이 CRM이라고 생각해요.

최영아:

맞아요, 저도 처음엔 CRM을 메시지 발송이라고 생각했어요. 그런데 일을 하다 보니 유저가 어디서 이탈하고, 어디서 전환되는지 분석하는 것부터 그 여정 전체를 설계하는 일이 모두 CRM이라는 걸 알게 됐어요.

구매 전환뿐만 아니라, 유저가 서비스를 계속 사용하도록 만드는 것 자체도 중요한 CRM의 역할이에요. 그래서 CRM은 굉장히 넓은 영역을 다루는 일이라고 생각해요.

김찬희:

롯데ON '찜하기 유도' 캠페인이 가장 기억에 남아요. 전략과 전술이 모두 잘 먹혔던 케이스였거든요.

우선 데이터 분석을 통해 '찜하기 행동이 구매 기여도가 높다'는 인사이트를 발견했어요.

이걸 HTML 기반 IAM을 잘 만드는 동료분께 공유했고, 그 분이 gif 형태의 움직이는 찜 유도 캠페인으로 구현해 주셨습니다.

전략과 실행이 딱 맞아 떨어졌고, 전체 지표 개선까지 확인되니까 '이게 CRM의 재미구나' 싶었어요.

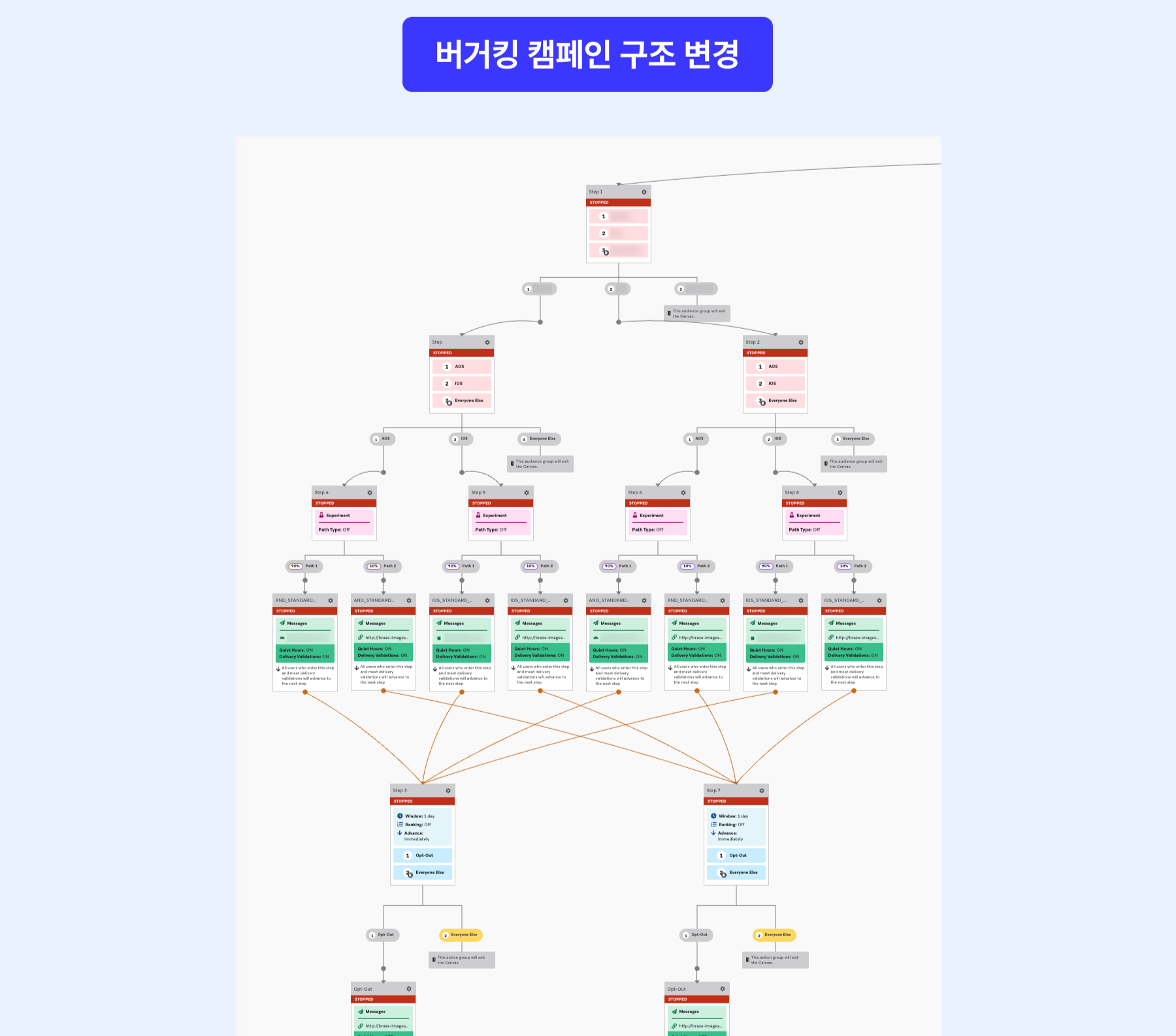

최영아:

저는 버거킹 캠페인이 기억에 남습니다. 해당 캠페인의 경우 매달 반복되는 캠페인이 많아 담당자분들의 리소스가 많이 투입되고 있었어요.

저는 파트 리더가 되고 난 후 ‘이걸 왜 매번 새로 만들지?’라는 질문을 던졌고, 비효율을 감소시키기 위해 자동화 캠페인으로 구조를 바꾸면서 리소스를 크게 줄일 수 있었어요.

이 경험을 통해 '파트원들이 더 중요한 일에 집중할 수 있게 됐다'라는 점에서 기억에 남아요.

김찬희:

사람이 뭘 할 때 동기부여를 받는지 파악하는 게 중요하다고 생각해요.

잘하는 일을 맡으면 성과도 나고 재미도 느끼거든요.

그래서 저는 파트원의 강점을 먼저 살리고, 부족한 부분은 함께 채워가는 방식을 선호합니다.

또 리더의 가장 중요한 역할은 업무 분배라고 생각해요.

실무자였을 때는 일단 내 일부터 시작했는데, 리더가 되고 나서도 똑같이 하다가 깨달았어요. 내 일 먼저 하고 파트원들에게 업무를 맡기려니 벌써 퇴근 시간이더라고요.

'이러다 팀 전체가 비효율을 겪겠다' 싶어서,

파트원들의 리소스를 먼저 확인하고 적절히 분배한 뒤 제 일을 시작하는 방식으로 바꿨습니다.

최영아:

저는 파트원들이 역량을 발휘하지 못하게 만드는 ‘걸림돌’을 제거하는 게 리더의 역할이라고 생각해요. 불필요한 반복 업무나 비효율적인 구조를 개선해서, 파트원들이 더 중요한 문제에 집중할 수 있게 만드는 게 중요하다고 느껴요.

김찬희:

CRM팀은 그로스팀과 가장 많이 협업해요. 사실 초반에는 협업이라기보다는 ‘요청’에 가까웠던 것 같아요. 분석이 필요할 때도 ‘이걸 요청해도 괜찮을까, 부담이 되진 않을까?’ 고민을 많이 했거든요.

그런데 막상 같이 일해보니, 그로스팀에서도 굉장히 적극적으로 의견을 주셨어요. ‘이런 방식이 CRM팀에도 도움이 될 것 같다’는 피드백을 주시기도 했고요.

그때 느꼈어요. 협업은 일을 넘기는 게 아니라,

각자가 잘하는 걸 섞어서 더 좋은 결과를 만드는 거구나 하고요.

최영아:

저도 그로스팀과 협업이 가장 많은데, 연관 상품 분석이나 RFM 분석을 더 깊게 하고 싶을 때 그로스팀에서 아예 따로 세션을 열어 방법론을 공유해 주셨어요.

그 덕분에 이후에는 CRM팀 내부에서도 자체적으로 분석을 할 수 있는 역량이 생겼고,

그 외 더 고도화된 분석은 다시 그로스팀에 요청하는 식으로

서로 역할이 정리되면서 협업의 밀도가 훨씬 높아졌어요.

함께 일하면서 CRM팀도 ‘그로스적인 시각’을 많이 갖게 된 것 같아요.

김찬희:

영아 님은 타임라인 관리와 계획을 정말 잘하세요. 저는 예전에는 ‘정해진 일정은 무조건 지켜야 한다’는 강박이 있어서 오히려 계획을 세우는 게 더 어려웠거든요. 그런데 영아 님과 건희 님(마티니 CRM 그룹 리더이자 COO)을 보면서 타임라인은 ‘내 일을 더 잘하기 위한 수단’이라는 관점으로 바뀌었고, 그 이후로는 계획을 훨씬 잘 활용할 수 있게 됐어요.

최영아:

찬희 님의 아이디어 내는 방식이 정말 부러웠어요. 저는 정리하고 수렴하는 쪽에 가까운데, 찬희 님은 항상 새로운 시각에서 질문을 던지고 제안을 해주세요.

웍스아웃 캠페인 때도 제가 세팅해 둔 걸 전혀 다른 관점에서 디벨롭해 주셨어요. 찬희 님과 협업하면서 사고를 확장해 아이디어를 내는 법을 많이 배우고 있어요. 카피를 쓰는 감각도 물론이고요.

김찬희:

저는 원래 호기심이 많은 편이에요. ‘왜 이렇게 하지?’라는 질문을 계속 하다 보면 아이디어가 나오는 것 같아요. CRM팀에는 저처럼 아이디어에 강점이 있는 사람도 있고, 영아 님처럼 구조화와 실행에 강한 분들도 있어서 서로의 강점을 보면서 자연스럽게 성장할 수 있는 환경이라고 생각해요.

김찬희:

기술적인 역량도 많이 달라졌지만, 가장 큰 변화는 태도라고 생각해요. 예전에는 ‘나무 한 그루를 어떻게 잘 보냐’에만 집중했다면, 지금은 숲을 보면서 관망할 수 있는 시각이 생겼어요.

마티니처럼 CRM 마케터가 많은 환경에서 ‘저 사람은 어떻게 일하지?’를 보면서 배울 수 있었던 게 제 시야를 넓혀준 가장 큰 계기였어요.

최영아:

저는 커머스뿐만 아니라 라이프스타일, 금융, F&B 등 여러 버티컬 산업에 대한 경험이라고 생각해요. 산업을 경험하면서 시야가 정말 넓어졌어요.

그리고 비교적 이른 연차에 리더를 맡게 된 것, 외부 행사나 컨퍼런스에서 발표할 기회를 얻은 것도 마티니가 아니었다면 쉽지 않았을 거라고 생각해요. 리더가 되면서 ‘이제는 내가 나서서 해봐야겠다’는 생각도 자연스럽게 들었고요.

최영아:

계속 배우고, 배운 걸 공유하는 문화요. 팀 내 공유회도 정기적으로 열리고, 다른 팀과 함께하는 세션도 있어서 계속 자극을 받고 시야를 넓힐 수 있어요. 이 문화는 절대 없어지면 안 된다고 생각해요.

김찬희:

저도 영아님 의견에 동의해요. 조금 더하자면 슬랙 질문 채널, 팀 미팅, 레퍼런스 문서까지 ‘공유하는 구조’가 자연스럽게 녹아 있어요. 모르는 걸 숨기지 않고 질문할 수 있는 분위기가 정말 큰 장점이에요.

김찬희:

CRM에 진짜 관심이 있는 분이면 좋겠어요.

그리고 논리적으로 생각하고, 본인이 잘하는 것과 부족한 걸 스스로 아는 분이면 더 좋아요.

최영아:

CRM을 ‘어떻게 하면 더 잘할 수 있을까’까지 고민해본 분이면 좋겠어요.

그리고 계속 배우려는 의지가 있는 분이라면, 마티니에서 정말 많이 성장하실 수 있을 거예요.

입사 후 3개월 : 배운 걸 바로 적용해보는 시간

마티니의 CRM 온보딩은 단순한 이론 교육에 그치지 않습니다.

체계적으로 구성된 교육 커리큘럼을 통해 CRM 툴, 데이터 해석, 캠페인 구조를 이해하고 배운 내용을 실제 캠페인에 바로 적용해보는 경험을 합니다. 이 시기에는 ‘아는 것’과 ‘할 수 있는 것’의 간극을 빠르게 줄이며 CRM 실무의 기본기를 단단히 다지는 데 집중합니다.

입사 후 6개월 : 부족한 지점을 스스로 인지하고, 채워나가는 시간

업무를 반복하며 ‘내가 어디에서 막히는지’, ‘무엇이 아직 부족한지’가 보이기 시작합니다.

이 시기에는 주변 동료들이 어떻게 일하는지 관찰하고, 직접 시도해보고, 시행착오를 겪으며 자신만의 일하는 방식을 만들어 갑니다.

마티니에서는 실패를 숨기기보다 공유하고,

그 과정에서 더 빠르게 성장하는 문화를 경험하게 됩니다.

입사 후 1년 : 잘하는 걸 더 잘할 수 있는 역할을 맡는 시점

1년이 지나면 기본적인 CRM 역량은 자연스럽게 자리 잡고,

본인이 잘하는 영역을 중심으로 더 큰 역할을 맡게 됩니다.

캠페인을 리딩하거나, 후배에게 노하우를 공유하고 내부 교육에 참여하는 등

‘혼자 잘하는 사람’을 넘어 팀에 영향을 주는 역할을 경험하게 됩니다.

마티니 CRM 팀은 단순히 캠페인을 실행하는 팀이 아니라, 고객 경험을 설계하고 비즈니스 성장을 고민하는 팀입니다. 잘하는 실무자에 머무르지 않고, '왜 이 전략이 필요한지' 질문하고 설명할 수 있는 사람으로 성장합니다.

혼자 잘하는 것보다 함께 더 좋은 결과를 만드는 법을 배우고 같이 성장하고 싶은 분이라면, 마티니 CRM 팀에서 그 다음 단계를 시작해 보세요.

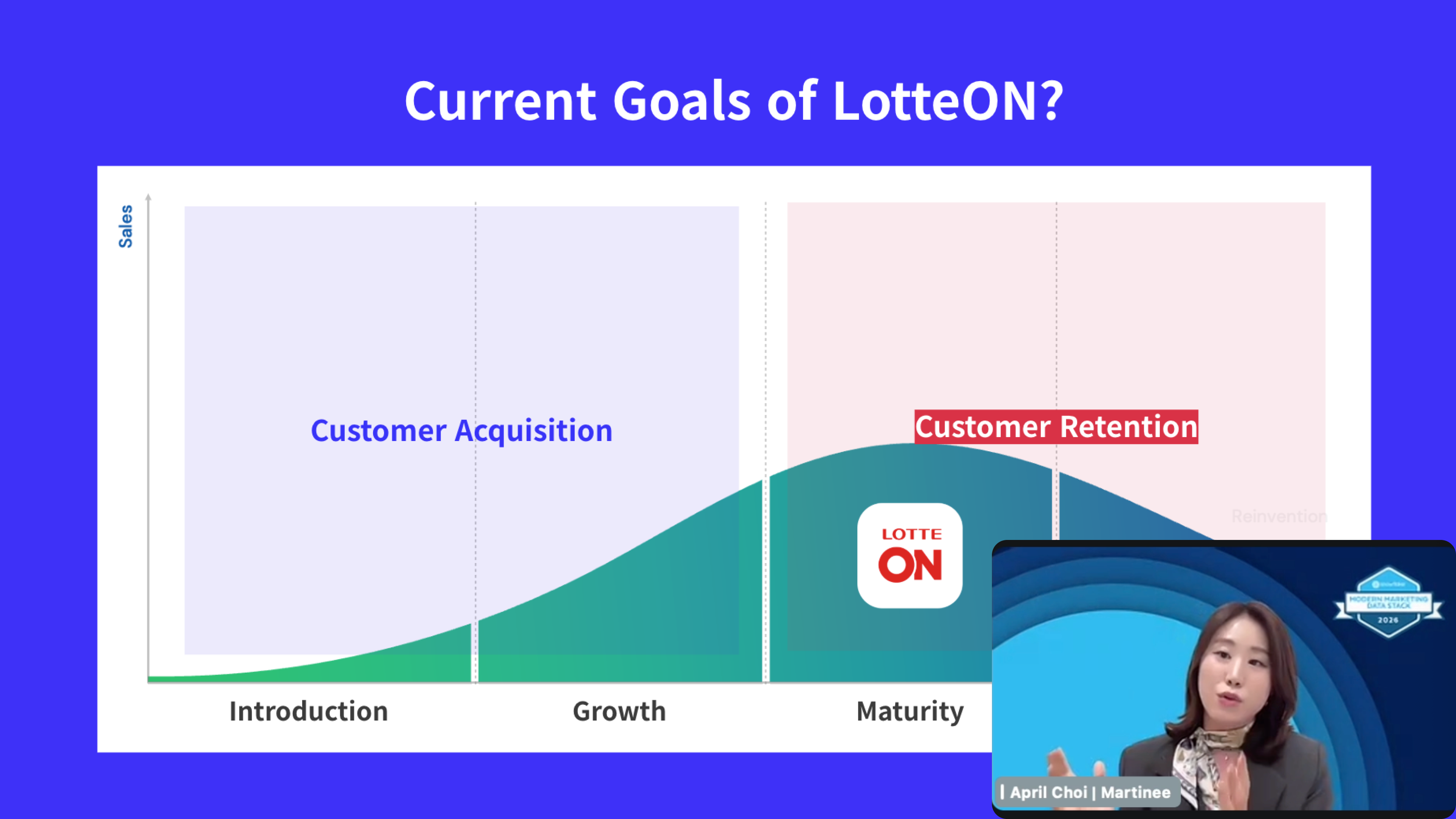

많은 기업에서 ‘신규 고객 획득(Acquisition)’ 만큼이나 공을 들이는 분야가 바로 ‘기존 고객 유지(Retention)’입니다. 고객과의 접점을 관리하고 개인화된 경험을 제공하는 CRM(고객 관계 관리) 솔루션 중 전세계적으로 가장 주목받는 솔루션이 바로 ‘브레이즈(Braze)’입니다.

브레이즈의 핵심적인 기능인 ‘Canvas(캔버스)’ 기능은 고객 여정을 시각화하여 설계할 수 있도록 돕는 기능입니다. 앱 푸시, 인앱 메시지(IAM), 이메일, 카카오톡 등 다양한 채널을 하나의 흐름으로 연결하여 고객에게 적합한 채널로, 적절한 시점에 메시지가 나갈 수 있도록 자동화할 수 있습니다.

브레이즈에서는 고객의 최근 조회 상품, 장바구니 내역, 선호 카테고리 등을 ‘Liquid(리퀴드)’를 활용해 실시간으로 메시지에 녹여낼 수 있습니다. 또한 ‘Connected Content(커넥티드 콘텐트)’를 같이 활용하면 외부 데이터도 API를 활용하여 실시간으로 연동해 더욱 다채로운 메시지 구성이 가능합니다.

브레이즈는 이외에도 다양한 AI 기능을 지속적으로 업데이트 하면서, 마케터들이 더 효율적으로 CRM 전략을 구상하고 실행할 수 있도록 돕고 있습니다.

많은 기업이 국내외 다양한 CRM 솔루션 사이에서 고민하지만, 결국 브레이즈를 선택하는 이유는 명확합니다.

모든 솔루션이 ‘마케팅 자동화’를 지원한다고 말하지만, 실질적으로 리소스를 절감하는 수준의 자동화를 제공하는 솔루션은 많지 않습니다. 브레이즈의 Canvas는, 고객 행동에 따라 실시간으로 분기되는 수천 개의 여정을 단일 워크플로우로 자동화합니다. 특히 반복적인 운영 업무를 대체하는 ‘자동 업데이트 세그먼트’와 인지 부하를 줄여주는 ‘라이브 여정 시각화’를 통해 마케터의 수동 리소스를 최소화합니다.

타 솔루션이 외부 AI 모델을 연결하는 데 그치는 수준이라면, 브레이즈는 플랫폼 자체에 AI 기능이 깊숙이 통합되어 있습니다. 마케터가 복잡한 기술 지식 없이도 브레이즈를 통해 개인화 타겟팅, 발송 시간 최적화 등을 구현할 수 있도록 되어 있어 리소스 절감 효과가 큽니다.

브레이즈는 전 세계 수천 개의 글로벌 기업이 사용하는 만큼, 대규모 트래픽 처리와 보안 측면에서 압도적인 안정성을 자랑합니다. 끊김 없는 서비스 가용성을 바탕으로, 마케팅 캠페인이 집중되는 피크 타임에도 지연 없는 메시지 발송을 보장합니다.

특히 이러한 글로벌 수준의 강력한 인프라 위에, 한국 시장의 필수 CRM 채널 중 하나인 ‘카카오톡’을 새로 연동하면서 이제 브레이즈 캔버스 내에서도 카카오톡을 활용할 수 있게 되었습니다.

브레이즈는 많은 고객사를 보유하고 있는 만큼 꾸준히 기능을 발전시켜 나가고 있습니다. 최신 마케팅 트렌드와 기술 변화에 가장 빠르게 대응하며, 한 번의 도입으로 계속 발전된 기능을 사용할 수 있습니다.

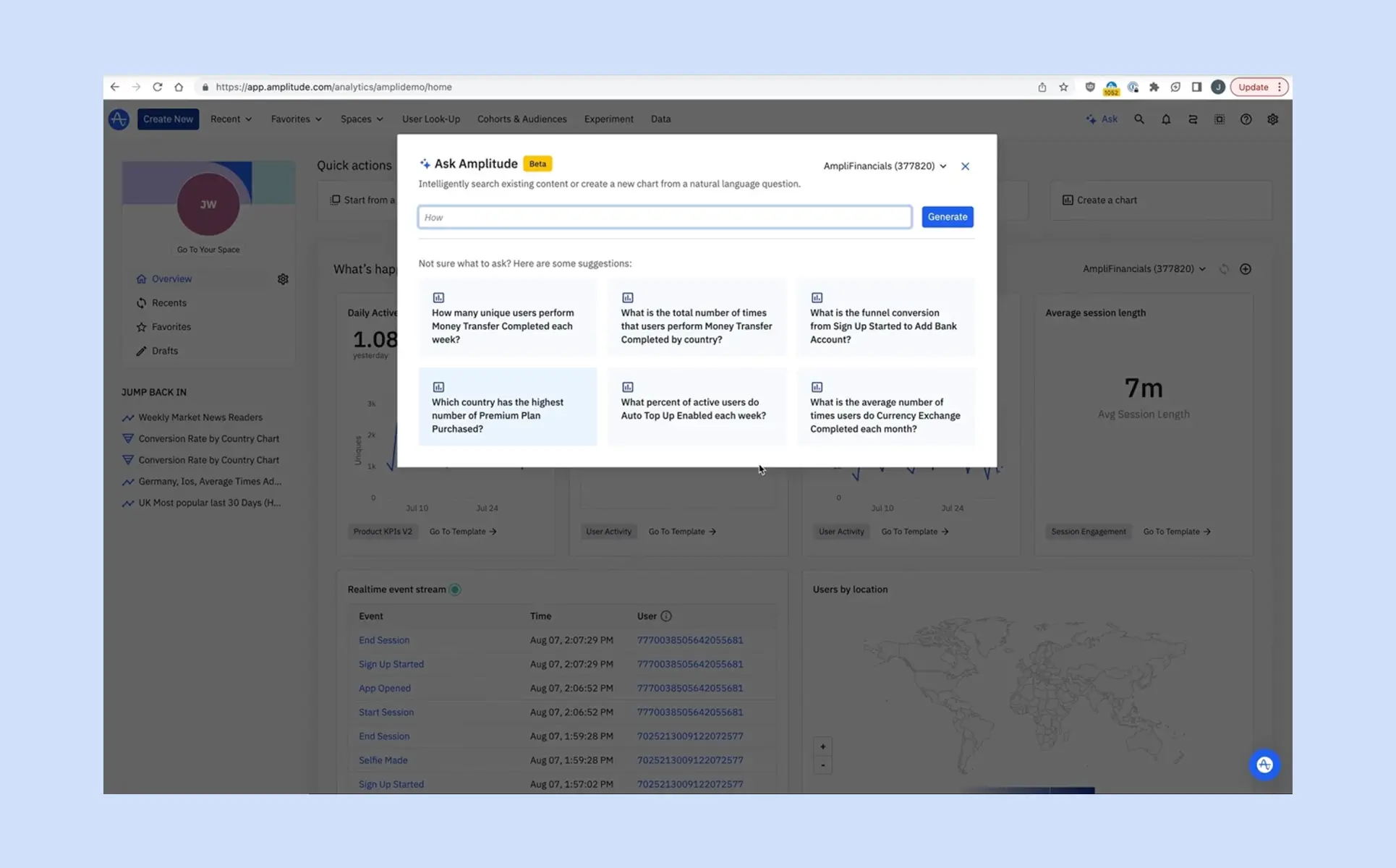

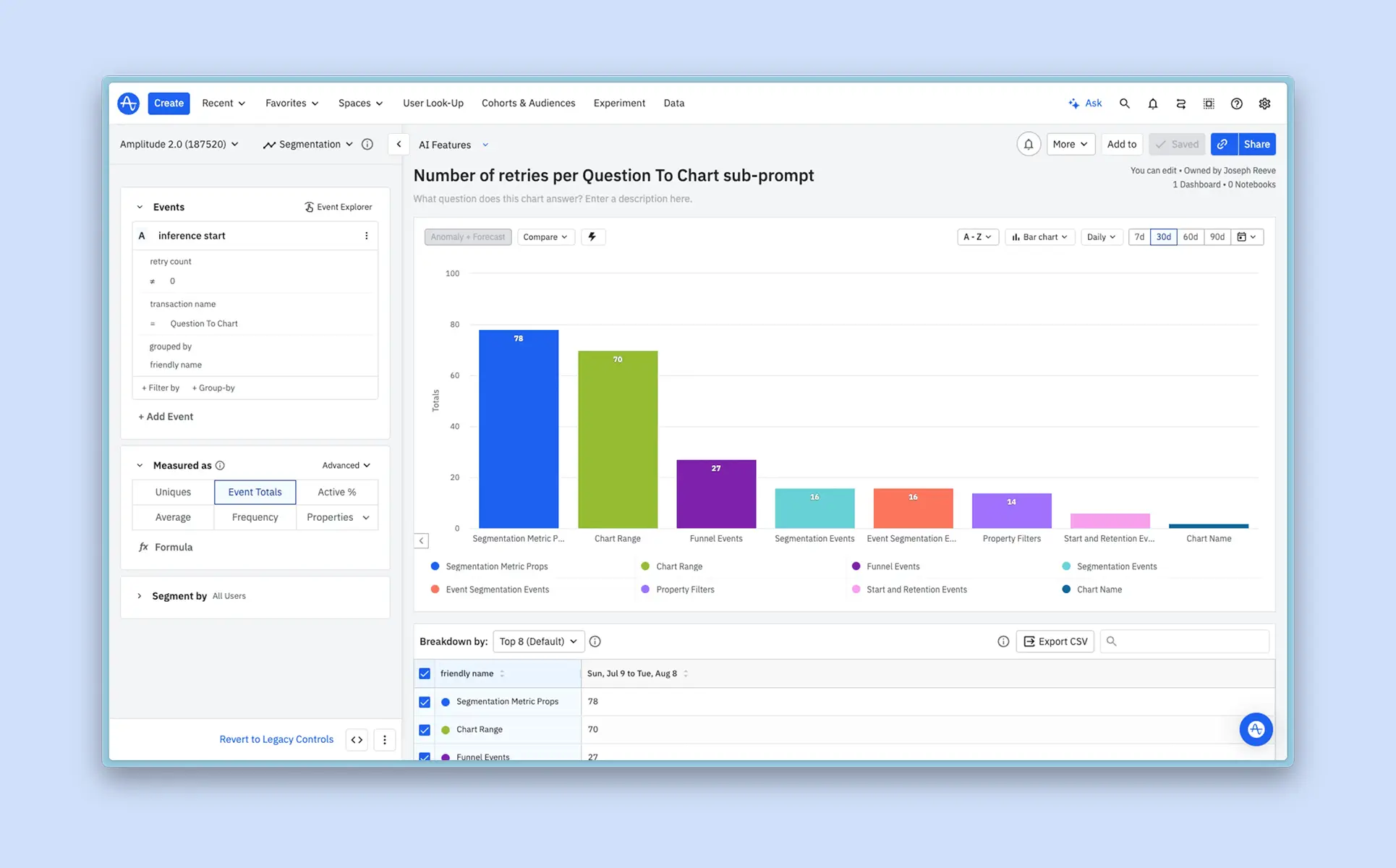

데이터를 분석하다 보면 ‘이 질문에 답하려면 어떤 차트를 만들어야 할까?’라는 고민을 자주 하게 됩니다. 앰플리튜드(Amplitude)는 이러한 고민을 덜어주기 위해 Ask Amplitude를 선보였습니다.

Ask Amplitude는 사용자가 자연어로 질문을 입력하면, 곧바로 적합한 차트를 생성하고 인사이트를 제공합니다. 지금부터 Ask Amplitude를 실무에서 어떻게 활용할 수 있는지, 구체적인 사례를 통해 살펴보겠습니다.

행동 데이터의 핵심 가치는 질문에 답하고, 의사 결정에 필요한 인사이트를 도출하는 데 있습니다. 그러나 지금까지 앰플리튜드를 사용하는 많은 사용자들은 제품 UI에서 차트를 단계별로 직접 구성해야 했습니다.

이제 Ask Amplitude를 통해 이러한 복잡한 차트 작성 과정을 대폭 간소화할 수 있습니다. 여러 단계를 거쳐 차트를 구성할 필요 없이, 아래 예시처럼 궁금한 내용을 질문 형태로 입력하기만 하면 됩니다.

Ask Amplitude는 질문을 이해하고, 적절한 차트 유형과 이벤트, 속성을 자동으로 선택해 결과를 보여줍니다. Amplitude AI Agent 기능과 함께 활용하면, 데이터 분석에 필요한 시간과 노력을 크게 줄일 수 있습니다.

Ask Amplitude는 데이터팀에 의존하지 않고도 누구나 스스로 데이터를 탐색할 수 있도록 설계되었습니다. 단순히 질문에 답하는 AI가 아니라, 실무자가 제품 데이터를 직접 활용할 수 있도록 돕습니다.

예를 들어 ‘사용자 가입부터 노래 또는 영상 구매까지의 퍼널 전환율은 어떻게 되나요?’라고 질문했다고 가정해 보겠습니다.

Ask Amplitude는 전환율 수치만 제공하는 데서 그치지 않고, A/B 테스트 가입 그룹별로 데이터를 분할하고, 전날 대비 지표를 비교하며, 첫 단계에서 안드로이드(Android)와 iOS 플랫폼만 필터링하는 방법까지 함께 보여줍니다.

또한 자연어 기반으로 데이터 분석을 구성할 수 있게 되면서, 실무자가 필요한 시점에 직접 서비스 데이터를 분석하고 인사이트를 도출할 수 있게 되었습니다. 이렇게 생성된 차트는 단순한 보고용 결과가 아니라, 실무자가 스스로 지식을 쌓고 다음 질문에 주도적으로 답할 수 있는 토대가 됩니다.

편리함만을 이유로 AI가 차트를 무분별하게 생성하게 두면 문제가 발생할 수 있습니다. 비슷한 내용의 차트가 여러 개가 있으면, 오히려 어떤 차트를 신뢰해야 할지 판단하기 어려워지기 때문입니다.

Ask Amplitude는 시맨틱 검색을 활용해 이러한 문제를 방지합니다. 새로운 차트를 만들기 전에 먼저 앰플리튜드 내에 이미 존재하는 콘텐츠를 검색하고, 동료들이 만들고 검증한 차트 중 유사한 것이 있는지부터 확인합니다.

이러한 검색 기법은 ‘스트리밍된 비디오 시간’과 ‘총 시청 시간’처럼 표현은 다르지만 같은 의미를 가진 용어까지 인식합니다. 덕분에 사용자는 대부분의 경우 새로운 차트를 추가로 생성하지 않고도 필요한 콘텐츠를 찾을 수 있으며, 앰플리튜드 내 콘텐츠의 품질과 신뢰도를 함께 유지할 수 있습니다.

마티니는 앰플리튜드를 활용해 고객사가 데이터에서 인사이트를 얻고, 더 나은 의사결정을 할 수 있도록 돕고 있습니다. 데이터 환경을 구축하고 마케팅 성과를 높이고 싶다면, 지금 바로 마티니와 만나보세요.

마케터라면 한 번쯤 이런 고민을 해보셨을 겁니다.

“브랜드 메시지는 통제가 쉬운 정적형 소재가 낫지 않을까?”

“효율을 높이려면 반응형이 답이지 않을까?”

우리는 흔히 정적형 소재를 ‘안전한 선택’, 반응형 소재를 ‘효율적인 선택’ 정도로 단순화합니다. 하지만 실제 데이터를 기반으로 보면, 이 구분은 생각보다 더 입체적인 이야기를 보여줍니다.

정적형 소재

반응형 소재

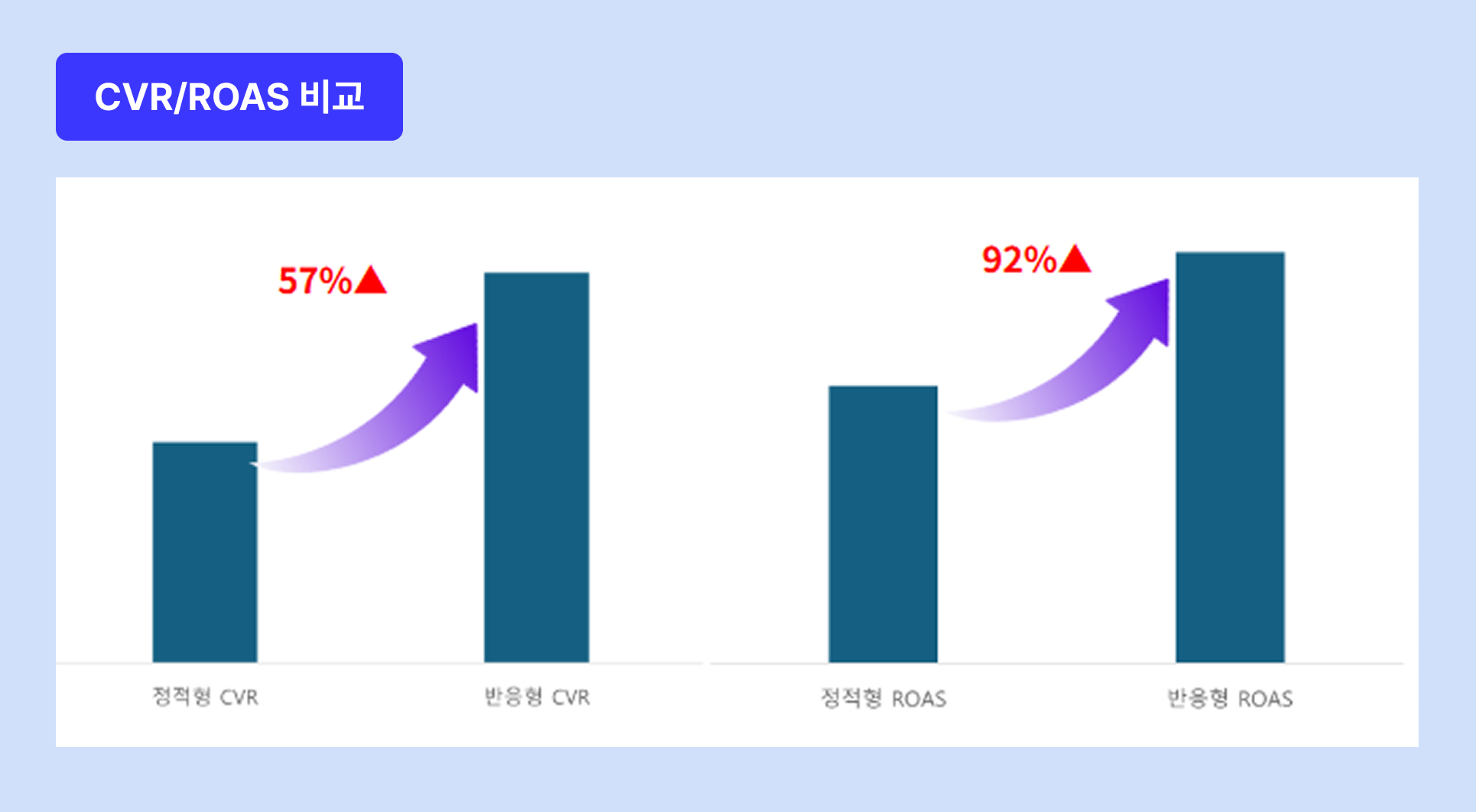

즉, 이번 실험은 정적형과 반응형을 각각 따로 운영한 것이 아니라, 동일한 그룹 환경에서 나란히 성과 차이를 검증한 케이스입니다. 반응형에는 기존 정적 이미지뿐만 아니라 영상·텍스트 조합까지 포함되어, 자동 최적화와 소재 확장의 효과를 동시에 살펴볼 수 있었습니다.

데이터는 분명했습니다.

즉, 반응형은 광고비를 더 많이 소진했음에도 불구하고, 효율 지표(ROAS·CVR)까지 개선되었습니다.

이는 곧 예산 확대와 효율 개선을 동시에 달성할 수 있는 운영 구조가 반응형 소재에서 구현되었음을 보여줍니다.

특히 반응형 소재 투입 이후, 캠페인 매출 구조가 점차 반응형 중심으로 이동하는 흐름이 뚜렷하게 나타났습니다.

반응형 크리에이티브라는 포맷 자체의 구조적 강점에서 비롯됩니다.

즉, 반응형은 더 많은 테스트 → 더 빠른 학습 → 더 정교한 최적화라는 선순환 구조를 갖습니다.

정적형과 반응형은 경쟁 관계가 아니라, 서로 다른 목적을 가진 크리에이티브 포트폴리오 요소입니다.

이번 실험은 데이터 관점에서 '반응형이 성과적으로 우위에 있다'는 사실을 명확히 보여줍니다.

동시에, 캠페인을 운영하는 마케터라면 브랜드 메시지 통제를 위한 정적형 소재의 필요성도 고려하지 않을 수 없습니다.

정리하자면,

결국 ROI를 높이는 열쇠는 정적형과 반응형을 이분법적으로 나누는 것이 아니라, 두 가지를 어떻게 조합하느냐에 달려 있습니다.

이제 브레이즈에서 RFM 세그멘테이션을 활용할 수 있게 되었습니다.

RFM 세그멘테이션은 최근성(Recency), 빈도(Frequency), 금액(Monetary)를 기준으로 각 지표를 스코어링하고, 점수별 유저 그룹의 특성을 정의하는 세그멘테이션 방식입니다.

브레이즈의 SQL Segment Extension에서 사전 정의된 템플릿을 활용해 간편하게 사용할 수 있습니다.

RFM 세그먼트에 대한 상세한 내용은 마티니의 RFM 분석 사례 아티클에서도 확인해보실 수 있습니다.

*쿼리문에서 일부 데이터를 조정하여 기준을 변경하는 것도 가능합니다.

Custom Attribute별로 각 데이터가 차지하는 비중을 확인할 수 있는 기능이 생겼습니다.

예를 들어, ‘멤버십’ 정보를 저장한 Custom Attribute에 각 멤버십 등급별 비중을 확인하거나, 유저가 ‘구매한 카테고리 리스트’에 가장 많이 담긴 카테고리 비중을 확인하는 등의 인사이트 확인이 가능합니다.

다만, 25만 명 이상으로 유저수가 큰 경우, 샘플링된 데이터로 제공되어 실제와 오차가 발생할 수 있는 점 참고가 필요합니다.

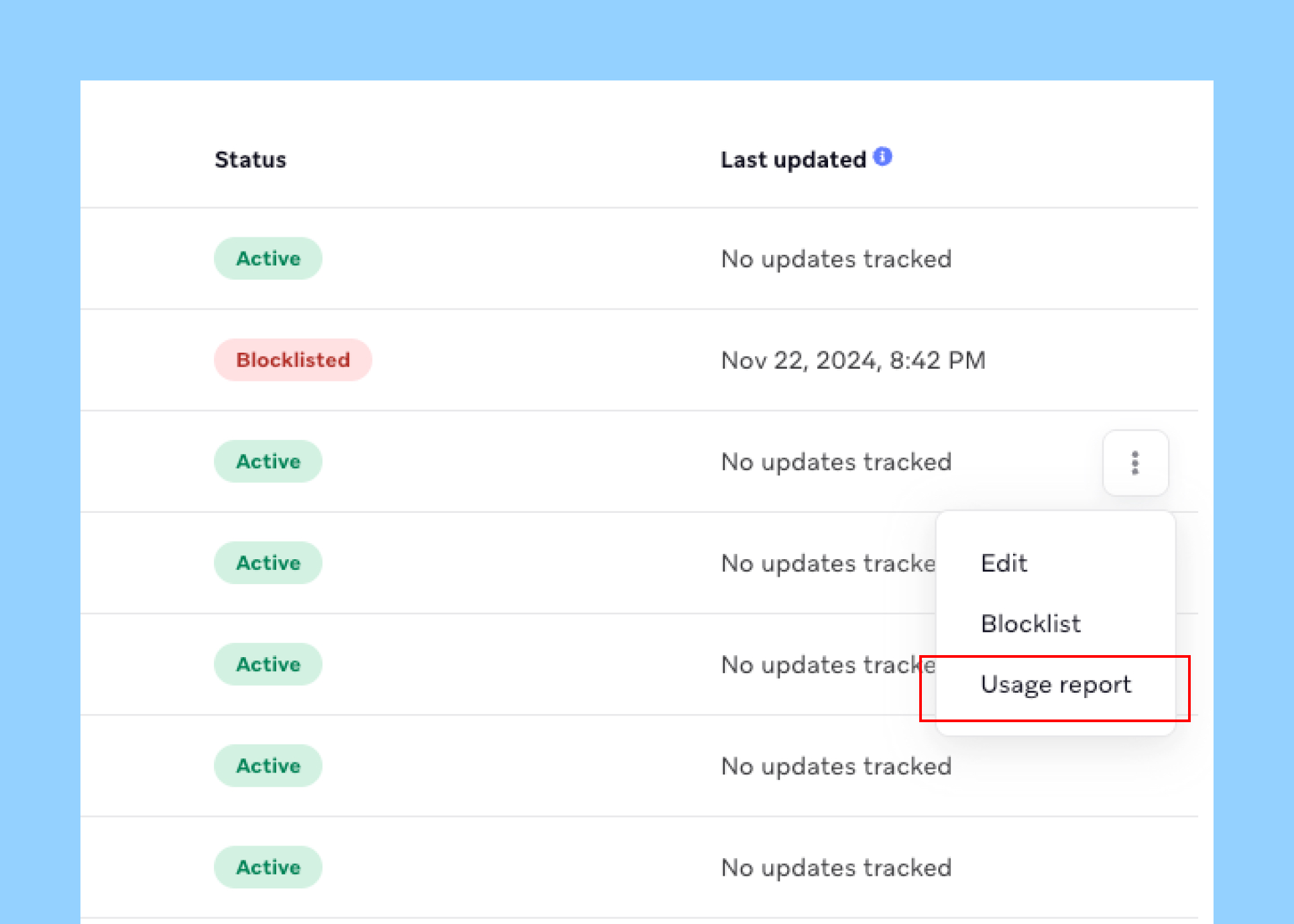

Data Settings > Custom Attribute 메뉴로 진입하여 보고 싶은 데이터의 우측 메뉴에서 View Usage 버튼을 눌러 확인할 수 있습니다.

버거킹 앱 다운로드를 위하여 ‘버거킹 앱’에서만 제공하는 혜택에 집중한 크리에이티브 발굴이 필요했습니다. 버거킹 앱을 사용하지 않더라도 배달 앱(배달의민족, 요기요 등)을 사용해서 배달 주문이 가능하고, 매장 이용시에는 키오스크 주문도 가능하기에 버거킹 앱에서만 가능한 할인 혜택에 집중하였습니다.

할인 혜택 위주로 소재 제작 및 운영하다보니, 할인율이 가장 큰 APP 회원가입 유저 대상의 웰컴쿠폰(와퍼세트 4500원)에서 가장 우수한 성과를 보였습니다.

하지만, 와퍼세트(메뉴) + 4500원(할인가) 2가지 조합만으로 가능한 베리에이션에 한계가 있었습니다. 신규 유저 볼륨 확대를 위해서는 할인 혜택 외 새로운 USP 발굴이 필요하였습니다.

이에 페르소나를 재정의하고 각 페르소나에 맞는 맞춤형 크리에티브 테스트를 진행하였습니다.

기존에 안정적으로 운영하고 있던 구글 매체에서의 잠재고객 통계를 기반으로 페르소나를 선정하였습니다.

구글 잠재고객 통계를 사용하면 운영 중인 광고를 보고 전환하는 사용자 그룹의 고유한 특징, 관심분야, 행동을 파악하여 유저에 대한 이해도를 높일 수 있습니다. 캠페인에서 가장 많은 전환을 발생하는 잠재고객 그룹과 전체 전환수에서의 해당 잠재고객 그룹의 비중도 확인할 수 있습니다.

구글 잠재고객 통계 기준으로 캠페인에서의 전환 비중이 높은 관심사들을 확인할 수 있었고, 시즌 이벤트를 고려하여 관심사별 소재 투입 일정을 계획하였습니다.

분석 당시 야구 주요시즌을 앞두고 있었던 점을 고려하여 ‘야구팬’, ‘운동매니아’ 2가지 페르소나에 대한 맞춤형 소재 먼저 테스트를 진행하였습니다.

선정한 페르소나별 특성과 관심사를 반영하여 맞춤 소재를 기획하였으며, 그 과정에서 필요한 배경이미지는 브랜드 이미지를 해치지 않는 선에서 AI를 활용하여 제작하였습니다.

매체 내에서 별도 관심사 타겟팅은 진행하지 않았으며, 신규 유저 확보에 효과적인지 확인하기 위해 가입 지표 기준으로 상시 운영 중인 소재와 가입 지표 위주로 성과 비교하였습니다.

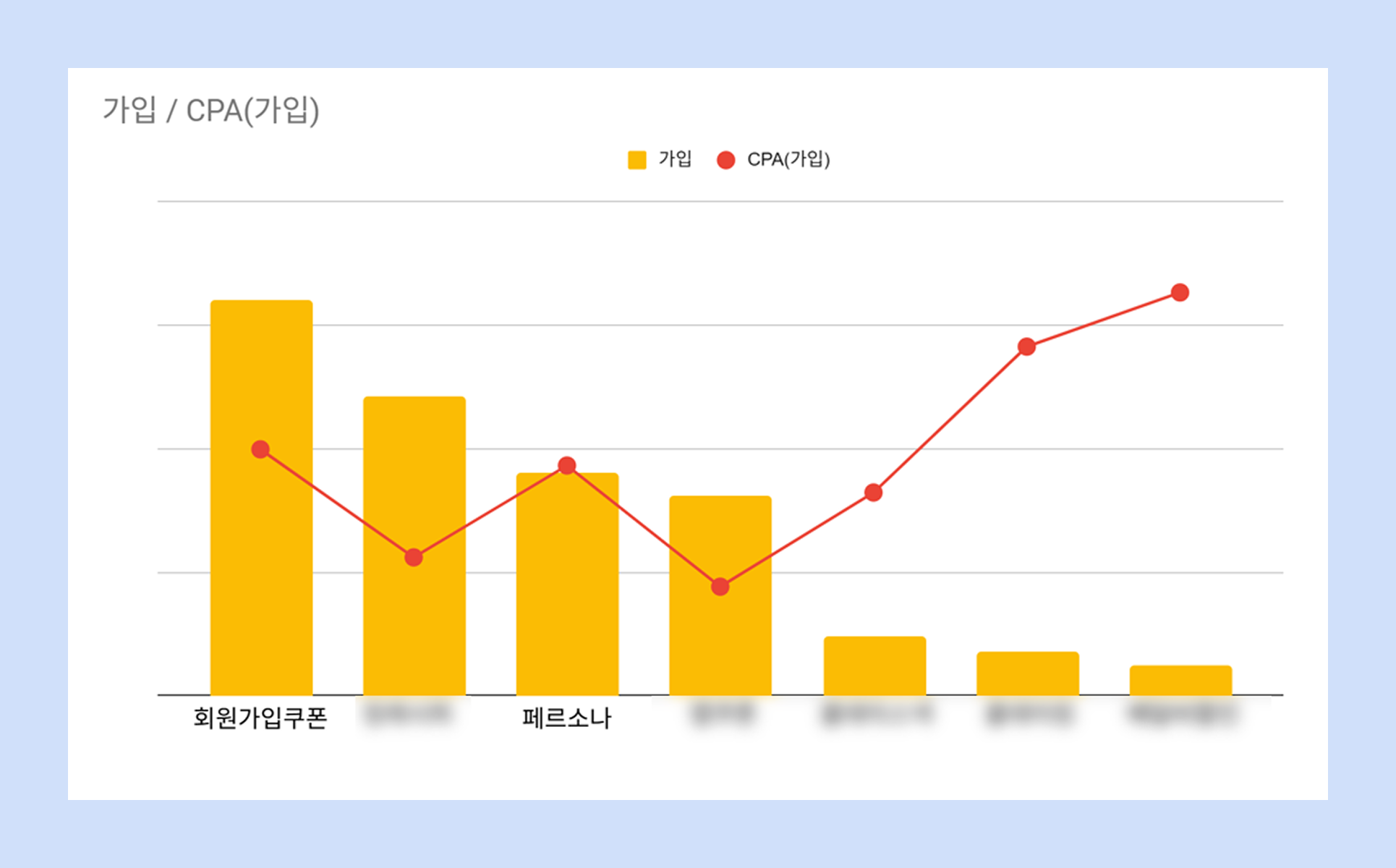

이전까지 [회원가입 쿠폰]에서 대부분의 가입 성과 확보 중이었으나, [페르소나] 맞춤형 소재에서 3번째로 많은 가입 전환 (17.9%) 확보하였습니다.

특정 관심사 타겟팅을 적용한 것이 아니기에 CPA(가입)가 높을 것으로 예상하였으나, 기존 가입 볼륨 리딩하던 [회원가입 쿠폰]과 유사한 단가 형성하며 전체 효율 개선에 기여하였습니다.

이에 카카오톡 네트워크 지면 내 노출 가능한 비즈보드소재 형태까지 소재 확장 운영하였으며, 운동매니아 페르소나 베리에이션은 비즈보드 소재 형태로도 기존 상시 소재와 비교에서도 가입 전환 확보에 효과적인 것을 확인할 수 있었습니다.

이번 실험을 통해 매체 통계 기반으로 제작한 페르소나 맞춤형 소재 제작이 신규소재 USP 발굴에 유효하다는 것을 확인하였습니다.

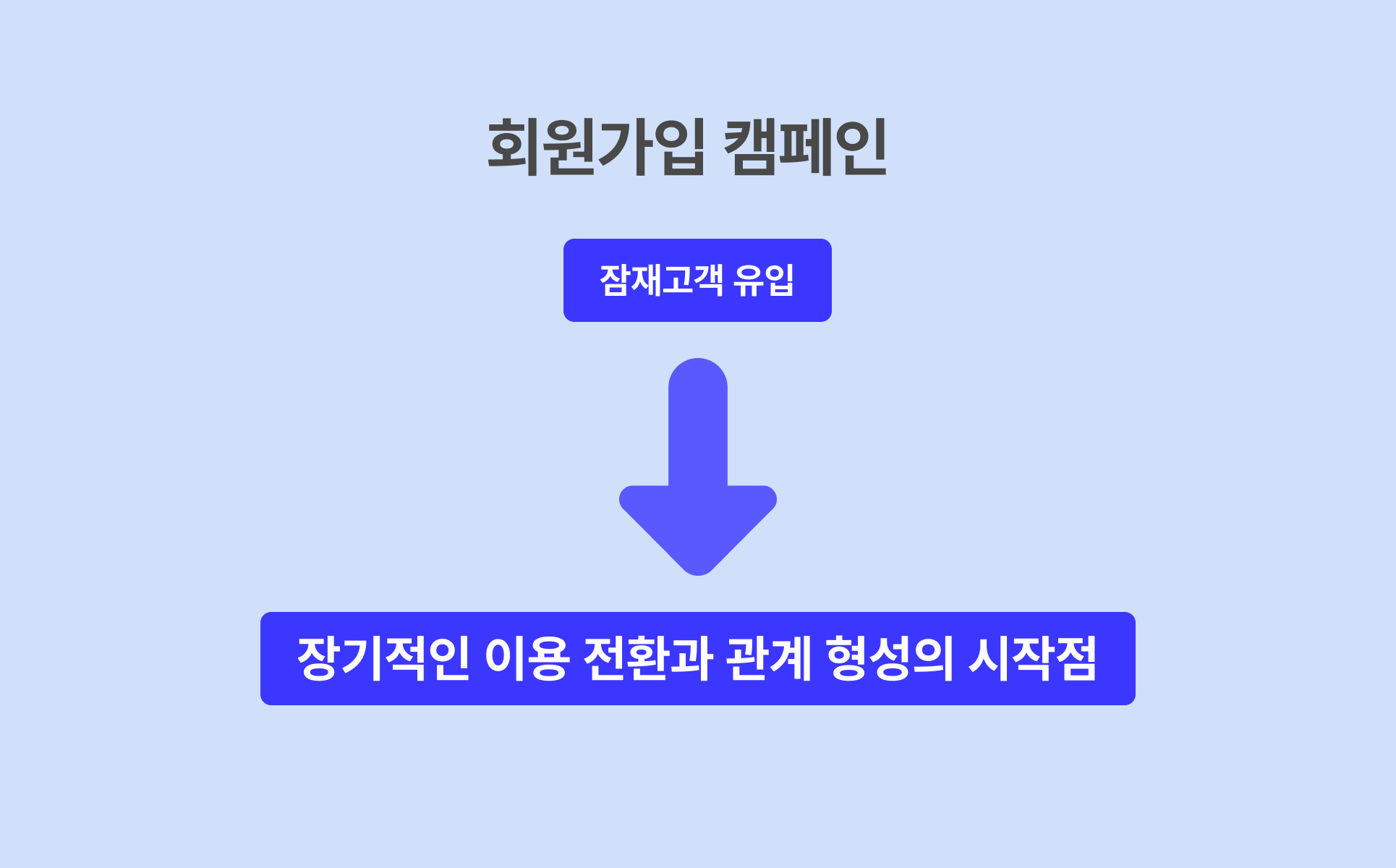

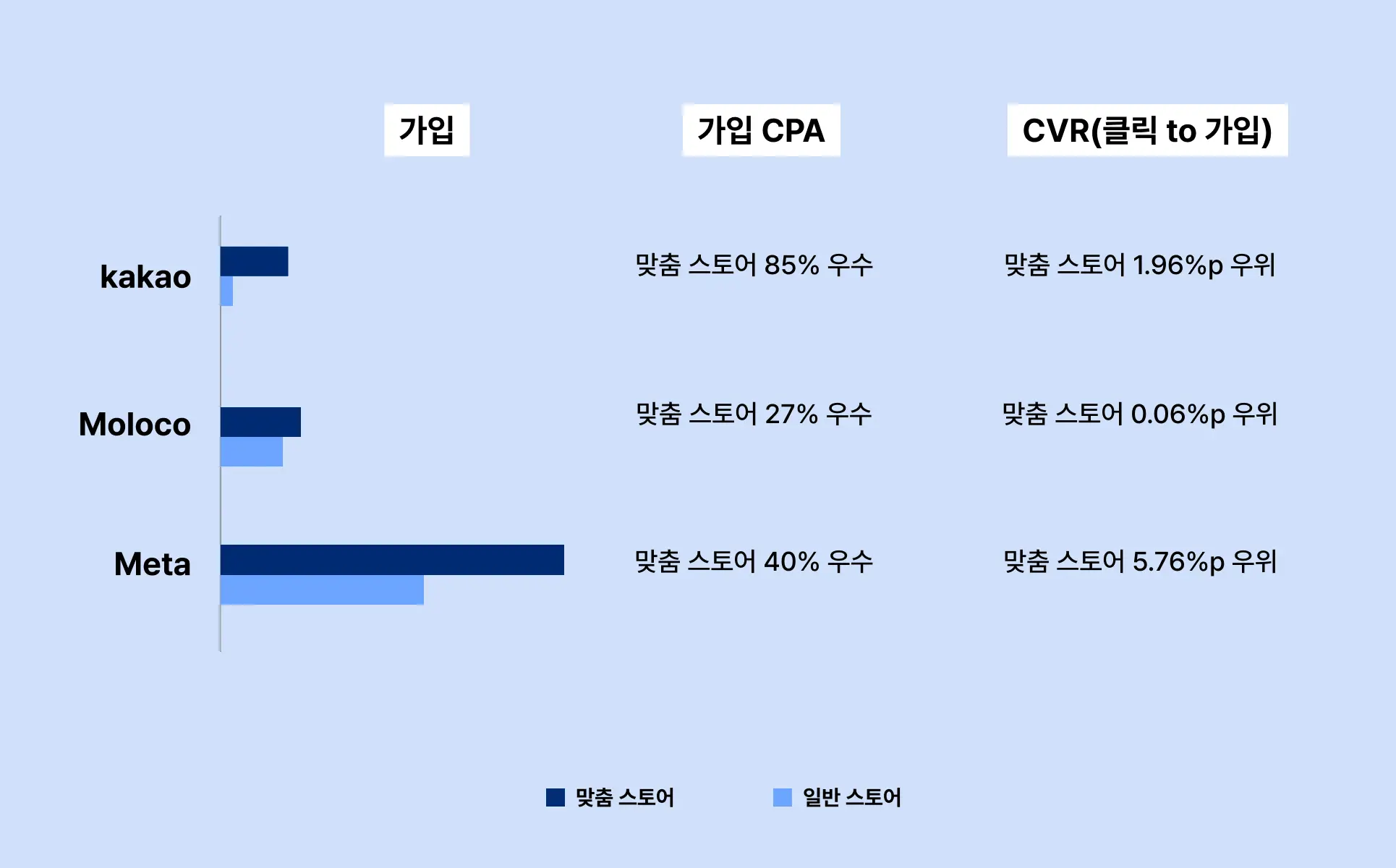

대부분의 서비스는 신규 고객 확보를 위한 첫 관문으로 ‘회원가입 캠페인’을 운영합니다.

이는 단순히 가입자를 늘리는 차원을 넘어, 잠재 고객을 자사 플랫폼 안으로 유입 시켜 장기적인 이용 전환과 관계 형성의 시작점으로 삼기 때문입니다.

특히 퍼포먼스 관점에서는 가입 단계의 전환율이 이후 구매 전환율·리텐션에 직접적인 영향을 미치는 핵심 지표로 작용하기도 합니다.

이번 캠페인은 회원가입을 통한 활성 사용자(DAU) 확보를 목표로 진행되었습니다. 해당 서비스는 로그인을 기준으로 이용 활성도를 산정하기 때문에, 가입 단계를 최적화하는 것이 곧 활성 사용자 확대로 직결되는 구조를 가지고 있습니다.

또한 “비용 효율적으로 신규 유저를 확보하면, 이후 첫 구매 전환율이 개선될 수 있다”는 가설 하에 랜딩 페이지 구조에 따른 가입 효율 및 이후 구매 전환율 차이를 검증하고자 하였습니다.

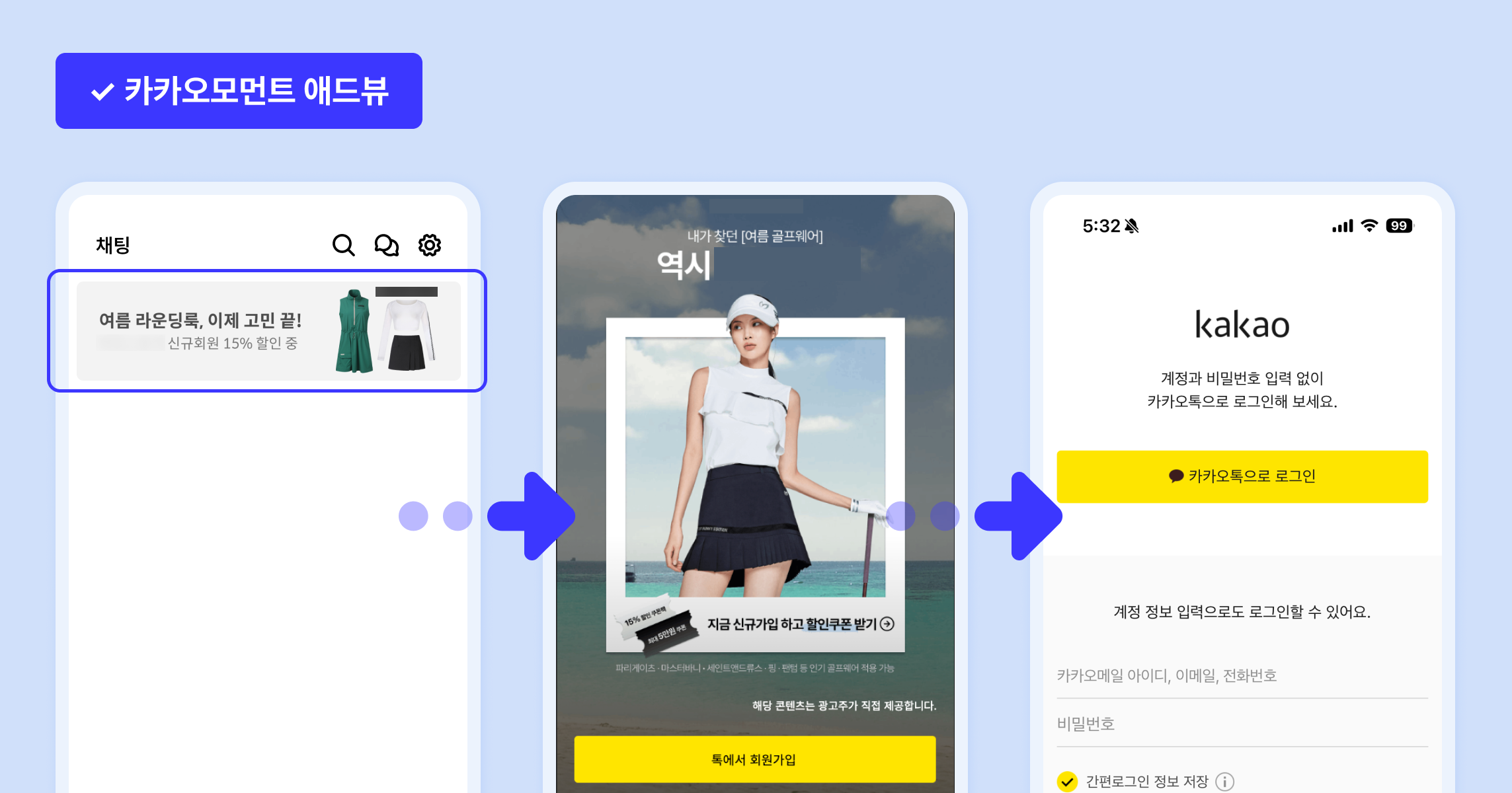

광고 클릭 → 카카오 간편 로그인 → 즉시 회원가입 가능

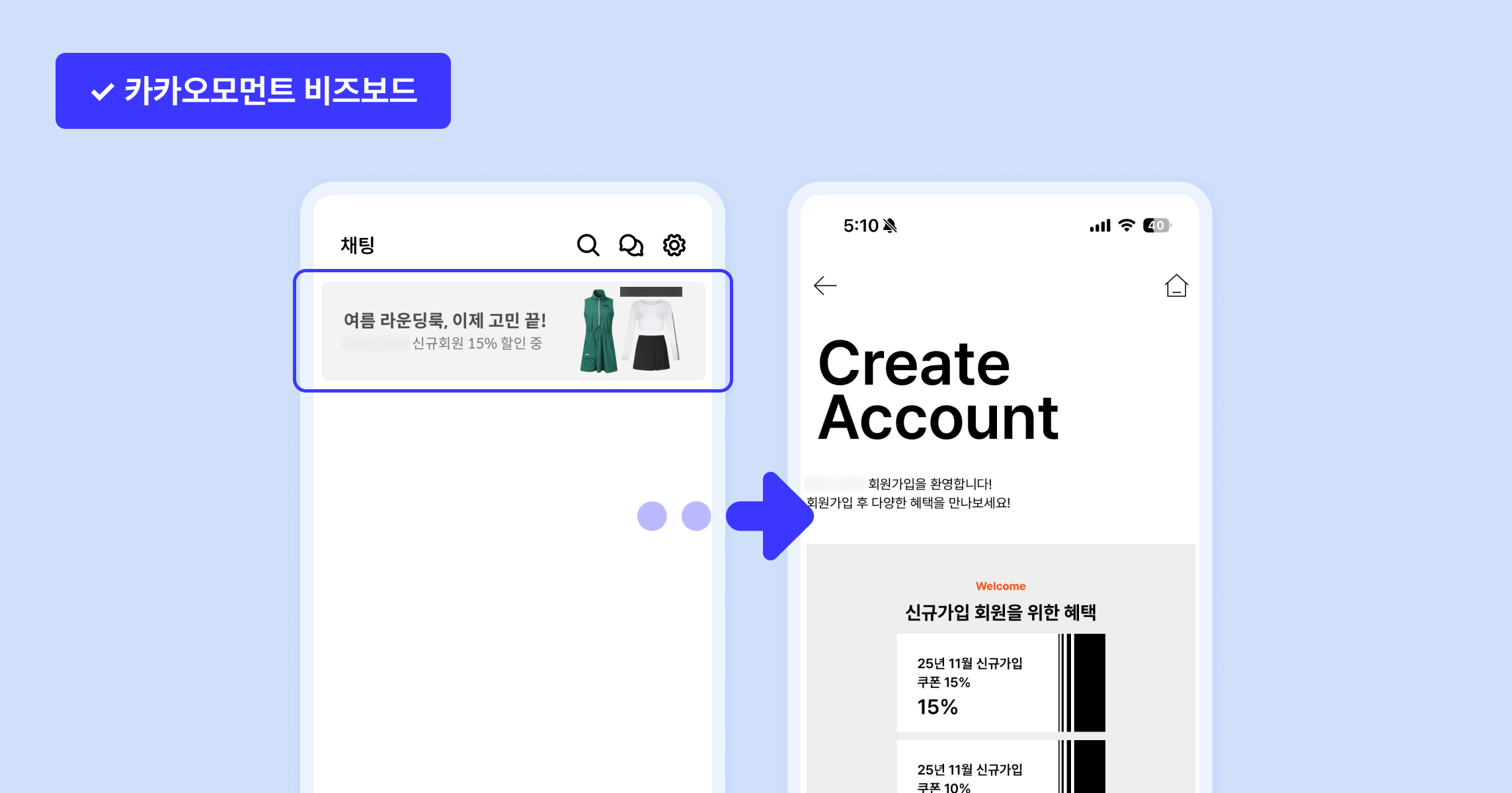

광고 클릭 → 자사몰 회원가입 페이지 → 가입 절차 진행

애드뷰 랜딩은 즉시 간편가입으로 이어질 수 있는 짧은 전환 경로가 장점이며, 자사몰 랜딩은 회원가입 혜택·프로모션·다양한 로그인 옵션을 한눈에 보여줄 수 있다는 장점이 있습니다.

고객사는 기존에 애드뷰를 중심으로 신규 유저를 대량 확보해왔으나, 애드뷰 유입 사용자의 구매 전환율이 낮을 것이라는 가설을 가지고 있었기에 이번 테스트를 통해 전환 효율과 유입 품질 간의 균형점을 찾는 것이 핵심 과제였습니다.

실험 결과, 애드뷰 랜딩(카카오 간편가입)이 웹 랜딩 대비 압도적으로 낮은 CPA를 기록하며 전환 효율 측면에서 우위를 보였습니다. 동일한 예산과 소재 조건에서도 랜딩 구조의 단순화만으로 약 17배의 전환 단가 차이가 발생했습니다.

다만, 애드뷰를 통한 가입 유저의 구매 전환율은 상대적으로 낮은 경향을 보여 단기 전환 효율은 높았으나 장기 가치 관점에서는 추가적인 품질 검증이 필요한 과제로 남았습니다.

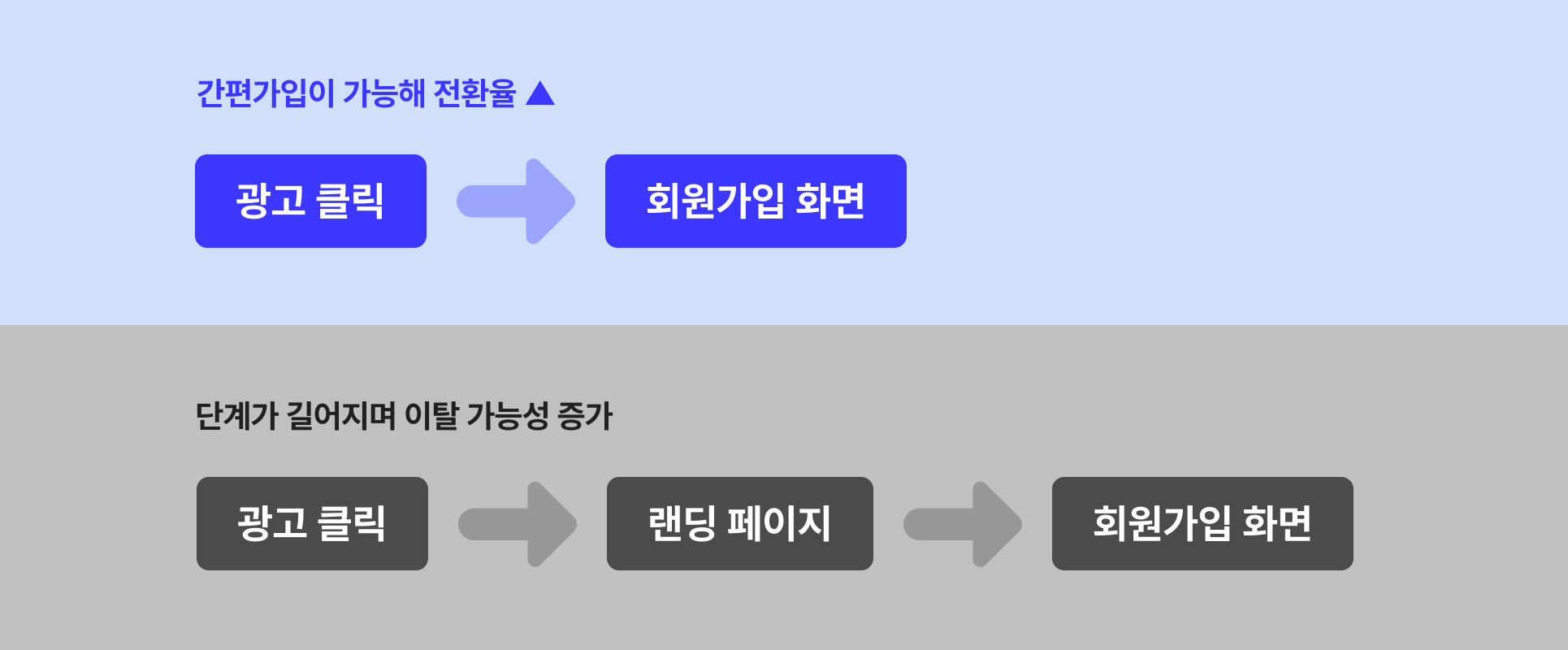

전환 구조의 단순화는 전환 효율을 극대화 합니다

모바일 환경에서는 클릭 이후 단계를 하나 줄이는 것만으로도 전환율이 눈에 띄게 향상됩니다. 즉 ‘가입 허들을 낮추는 설계’ 자체가 전환 효율을 높이는 핵심 요인으로 작용합니다.

목표에 따라 최적의 랜딩 구조는 달라집니다.

홈페이지 랜딩은 브랜드 메시지 전달에는 유리하지만, 회원 가입 중심 캠페인에서는 오히려 전환 퍼널이 길어져 효율이 저하될 수 있습니다. 이번 실험을 통해 목표가 명확한 캠페인일수록, 여정을 단순화하는 구조 설계가 필요함을 확인하였습니다.

소재 메시지의 직관성이 전환율에 직접적인 영향을 미칩니다.

가입 혜택을 강조한 메시지보다, 즉시 공감 가능한 프로모션 중심 메시지가 두 랜딩 방식 모두에서 더 높은 전환율을 보였습니다. 이는 사용자가 ‘즉각적인 보상’을 인지할 때 더 빠르게 행동으로 이어진다는 점을 시사합니다.

이번 실험은 회원가입 전환율을 높이는 데에는 명확한 성과를 보였으나, 가입 이후 구매로 이어지는 전환율은 상대적으로 낮게 나타났습니다. 이는 간편 가입을 통한 빠른 진입이 단기 전환 효율을 높일 수는 있지만, 유입 유저의 품질 측면에서는 추가 검증이 필요함을 보여줍니다.

향후에는 가입 이후 행동 데이터(첫 구매율, 재방문율, 이탈률 등)를 기준으로 한 후속 실험을 통해 실제 장기적으로 유효한 유저의 특성을 검증할 예정입니다. 이를 통해 단기 효율 중심의 구조에서 한 단계 나아가, ‘가입 이후 가치’를 극대화하는 사용자 여정 설계 방향을 도출하고자 합니다.

퍼포먼스 마케팅에서 마케터가 조정할 수 있는 영역은 크게 세 가지입니다. 매체, 소재, 그리고 랜딩 페이지입니다. 많은 분들이 랜딩 페이지는 마케터가 직접 통제하기 어렵다고 생각하지만, 다음과 같은 방식으로 충분히 효율을 개선할 수 있습니다.

랜딩 페이지에 신경을 써야 하는 이유는 명확합니다. 랜딩 페이지는 유저 이탈과 성과를 결정짓는 마지막 관문이자, 효율을 좌우하는 주요 변수이기 때문입니다.

매력적인 소재와 안정적인 매체 세팅이 있어도, 유저가 도착한 랜딩 페이지가 제대로 작동하지 않으면 전환율은 현저히 낮아집니다.

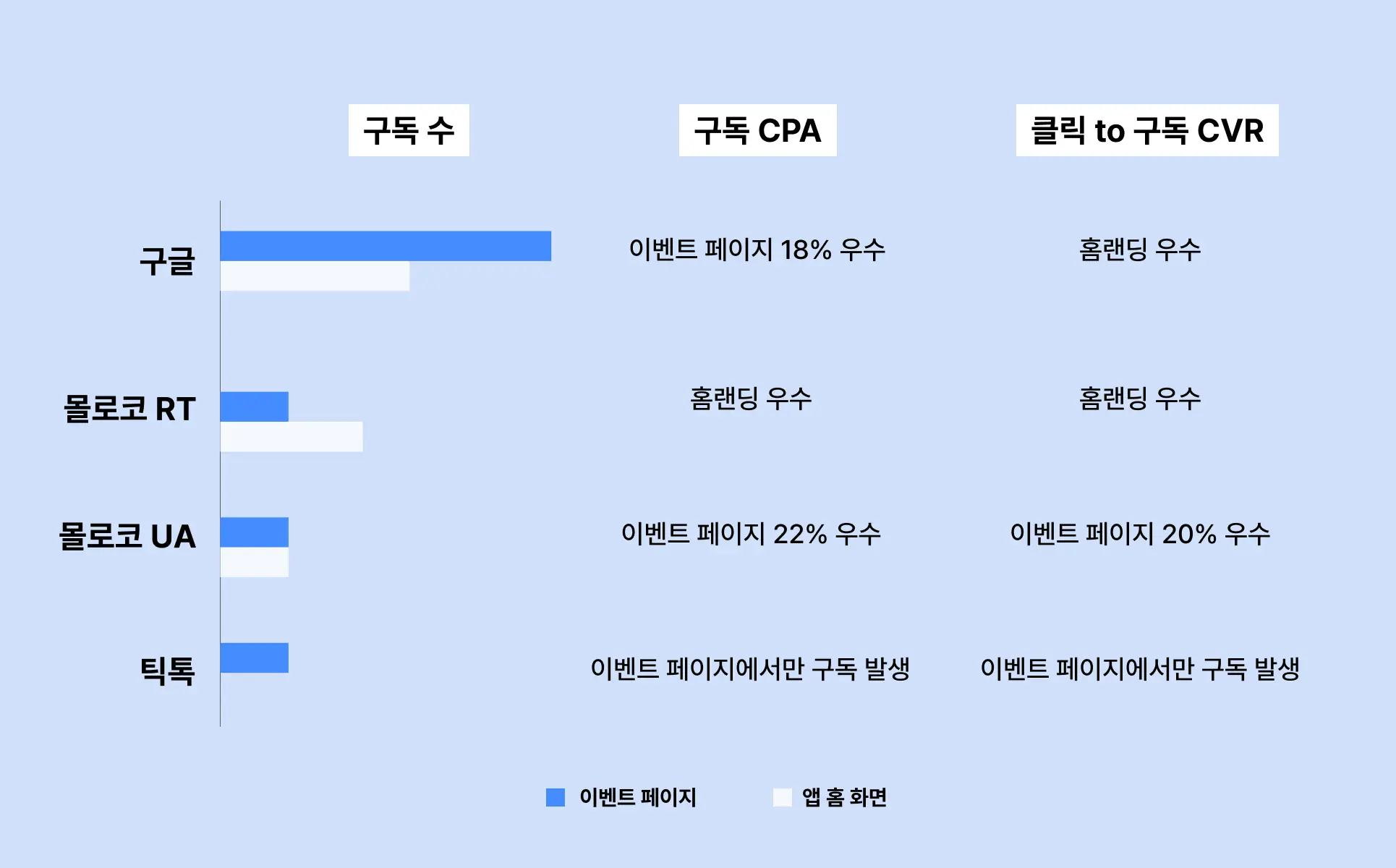

마티니에서 진행한 두 가지 랜딩 페이지 테스트를 소개합니다.

테스트에 앞서 두 가지 가설을 세우고, 효율을 판단할 수 있는 지표를 설정했습니다.

실험 설계

테스트 결과 :

CVR의 경우, 두 랜딩에서 비슷한 효율이 확인되었으나 KPI인 구독 CPA를 달성하는데 ‘이벤트 페이지’의 효율이 더 우수했습니다.

→ 이를 통해 성과를 높일 수 있는 구성 요소 추가한 랜딩 페이지의 우수성을 확인했습니다.

실험 설계

테스트 결과 :

→ 이를 통해 광고 소재의 메시지와 랜딩의 맥락이 일치 및 연관성이 높을수록 유저들의 전환 이후 행동(가입)이 활성화 되는 점을 확인했습니다.

좋은 랜딩 페이지는 단순히 디자인이 깔끔한 페이지가 아닙니다. 광고 메시지와 일관성을 유지하며, 유저가 '무엇을 해야 하는지'를 명확하게 전달하는 페이지입니다.

마케터는 다음 세 가지를 점검해야 합니다.

소재, 매체, 랜딩 페이지는 각각의 기능을 수행하면서도 하나의 유저 여정을 구성합니다.

유저 경험과 효율을 개선하기 위해 랜딩 페이지를 한번 더 점검해 보는 것은 어떨까요?

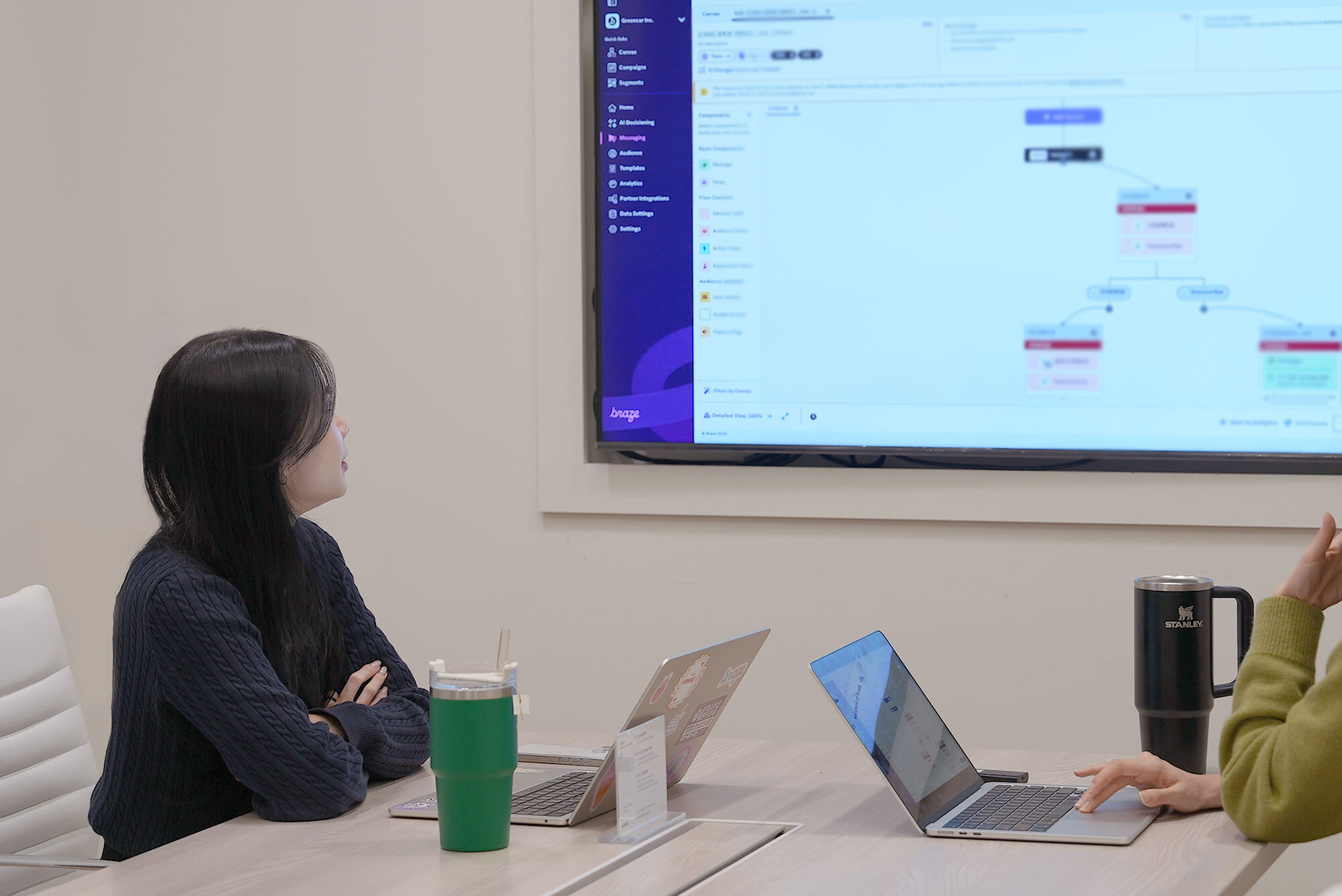

지난 11월 11일, Liquid 심화 문법과 Connected Content 활용법을 중심으로 브레이즈 부트캠프가 진행되었습니다. 이번 세션은 기본적인 개인화 태그를 넘어, 복잡한 조건 처리와 외부 API 연동을 통해 더욱 정교한 개인화 메시지를 구현할 수 있는 심화 방법을 다루었습니다.

Braze를 더욱 효과적으로 활용하고 CRM 마케팅을 고도화하고자 모인 많은 실무자 분들과 함께한 생생한 현장을 만나보세요.

첫 번째 세션에서는 Liquid의 고급 문법과 실무 활용법을 중심으로 진행되었습니다. 실무에서 자주 마주치는 시나리오를 직접 설계하며, 기본적인 개인화 태그를 넘어 조건문(if), 반복문(for), 다양한 필터(date, capitalize, split 등)를 활용해 더 정교한 메시지를 구성하는 방법을 배웠습니다.

실습에서는 고객의 구매 이력에 따라 추천 상품을 다르게 표시하고, 배열 데이터를 반복문으로 처리하며, 날짜 형식을 변환하는 작업을 직접 수행했습니다. 참여자들은 조건 분기, 배열 순회, 필터 적용 등 Liquid의 핵심 기능을 실제 메시지에 적용하면서 실무 감각을 키울 수 있었습니다.

두 번째 세션에서는 Connected Content를 통해 실시간 데이터를 활용한 개인화를 다뤘습니다. 이 기능을 활용하면 실시간 재고 확인, 날씨 정보 연동, AI 기반 상품 추천, 최신 콘텐츠 자동 업데이트 등 브레이즈에 저장되지 않은 외부 데이터를 메시지에 활용할 수 있습니다.

실습에서는 실제 API를 호출하고, 응답으로 받은 JSON 데이터에서 필요한 값을 추출해 메시지를 구성하는 과정을 직접 진행했습니다. 상품 추천 API를 호출해 고객별 맞춤 추천 상품 목록을 가져온 뒤, 각 상품의 이름, 가격, 이미지를 메시지에 동적으로 표시하는 방법을 배웠습니다.

2025년 마지막 일정으로 진행된 브레이즈 부트캠프가 성황리에 종료되었습니다. 이번 부트캠프에서는 Liquid의 고급 문법부터 Connected Content를 활용한 실시간 데이터 연동까지, CRM 개인화의 핵심 기능을 실무 중심으로 다뤘습니다.

마티니는 브레이즈의 국내 공식 파트너사로서, 앞으로도 실무에 바로 적용할 수 있는 구체적인 방법론과 노하우를 제공하는 교육을 지속적으로 운영할 예정입니다.

데이터 기반 마케팅을 시작하고 싶다면 지금 바로 마티니를 만나보세요.

Braze Bootcamp - Pesonalization 심화

주최 | Martinee ✕ Braze

일시 | 2025년 11월 11일 (화) 15 - 17시

장소 | 삼성 저스트코타워 3F

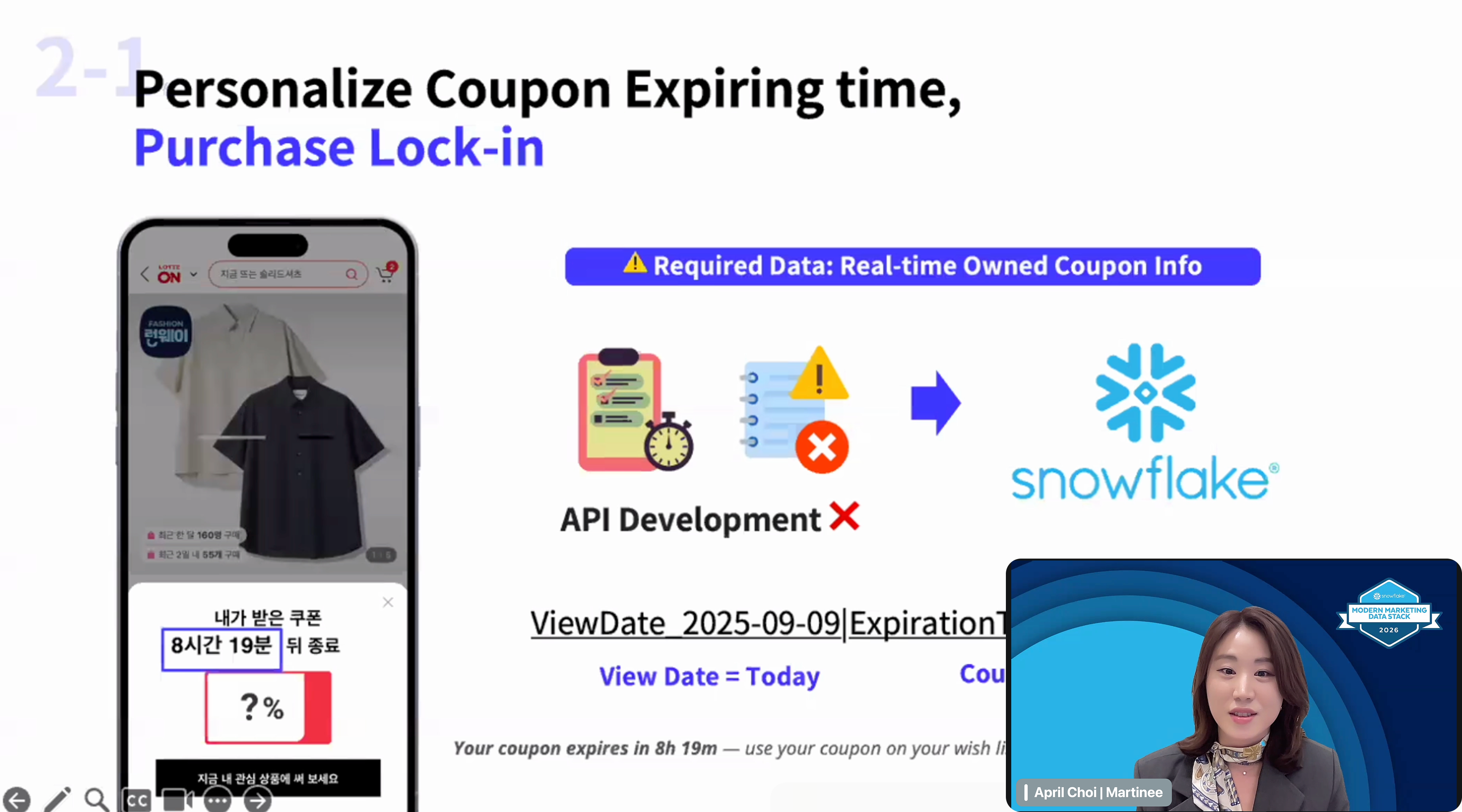

마티니가 스노우플레이크가 주최한 'Marketer's Edge: 데이터 전략과 ROI' APAC 웨비나에서 브레이즈를 활용한 롯데ON 사례를 발표했습니다.

스노우플레이크와 브레이즈를 결합해 개발 리소스 없이 고도화된 CRM 캠페인을 실행한 방법, 지금 확인해보세요.

1,500만 명 이상의 회원 수를 보유한 롯데ON은 핵심 고객의 리텐션을 강화해야 하는 과제를 안고 있었습니다. 대규모 사용자 데이터를 활용해 개인화된 경험을 제공하고 싶었지만, 복잡한 데이터 구조와 제한된 개발 리소스라는 현실적인 제약이 있었습니다.

매번 캠페인을 실행할 때마다 개발팀의 지원이 필요했고, 이는 마케팅 실행 속도를 늦추는 요인이 되었습니다.

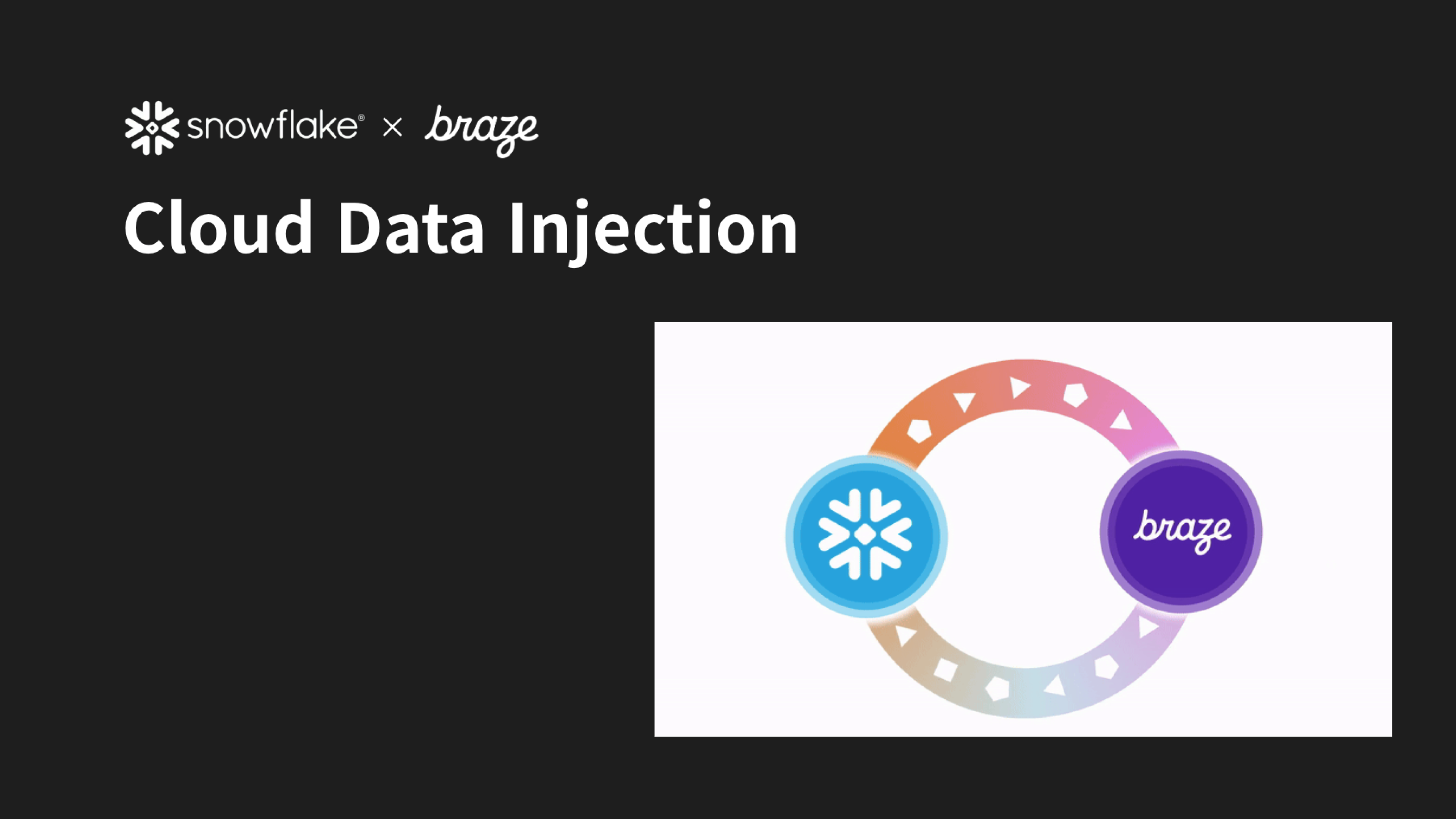

마티니는 이러한 문제를 해결하기 위해 스노우플레이크와 브레이즈를 통합한 노코드 초개인화 환경을 지원했습니다. 데이터 엔지니어링 없이도 마케터가 직접 고객 데이터를 활용해 캠페인을 기획하고 실행할 수 있는 구조를 만드는 것이 핵심이었습니다.

이를 통해 개발팀의 직접 개입 없이도 다양한 데이터를 CRM 마케팅에 활용할 수 있는 구조를 마련했습니다.

마티니는 어떻게 스노우플레이크와 브레이즈 연동을 통해 단기간에 높은 성과를 만들었을까요? 지금부터 스노우플레이크와 브레이즈를 활용한 마티니와 롯데ON의 세 가지 캠페인을 살펴보겠습니다.

일반적으로 개인화 캠페인을 진행하려면 개발 리소스가 필요합니다. 하지만 현실적으로 개발 우선순위를 확보하기란 쉽지 않습니다. 개발 지원을 받지 못하면 마케터가 직접 수동으로 데이터를 세팅해야 하고, 그 과정에서 시간과 리소스가 계속 투입됩니다. 결국 다른 기회를 놓치게 되는 셈입니다.

위 사례가 구현이 가능했던 핵심은 브레이즈의 CDI(Cloud Data Ingestion) 기능을 활용해 스노우플레이크의 데이터를 Custom Attribute로 활용했기 때문입니다.

마케터가 클릭 몇 번으로 실시간 데이터를 불러오고, 맞춤형으로 전송할 수 있습니다. 이를 통해 CRM 마케팅을 더 매끄럽고 효율적으로 운영할 수 있게 되었습니다.

이번 세션을 통해 제한된 개발 리소스 속에서도 데이터 기반 CRM 전략을 충분히 구축할 수 있음을 확인했습니다. 적절한 도구와 전략이 결합되면, 마케터가 주도적으로 데이터를 활용하고 실질적인 성과를 만들어낼 수 있습니다.

마티니는 고객사의 데이터 환경을 구축하고, 이를 마케팅 성과로 연결하는 과정을 함께합니다. 데이터 기반 마케팅 전략이 궁금하시다면, 지금 바로 마티니와 만나보세요.

Marketer's Edge: 데이터 전략과 ROI | APAC 라이브 웨비나

주최 | Snowflake

일시 | 2025년 11월 11일 (화) 11:00 - 13:30

.webp)

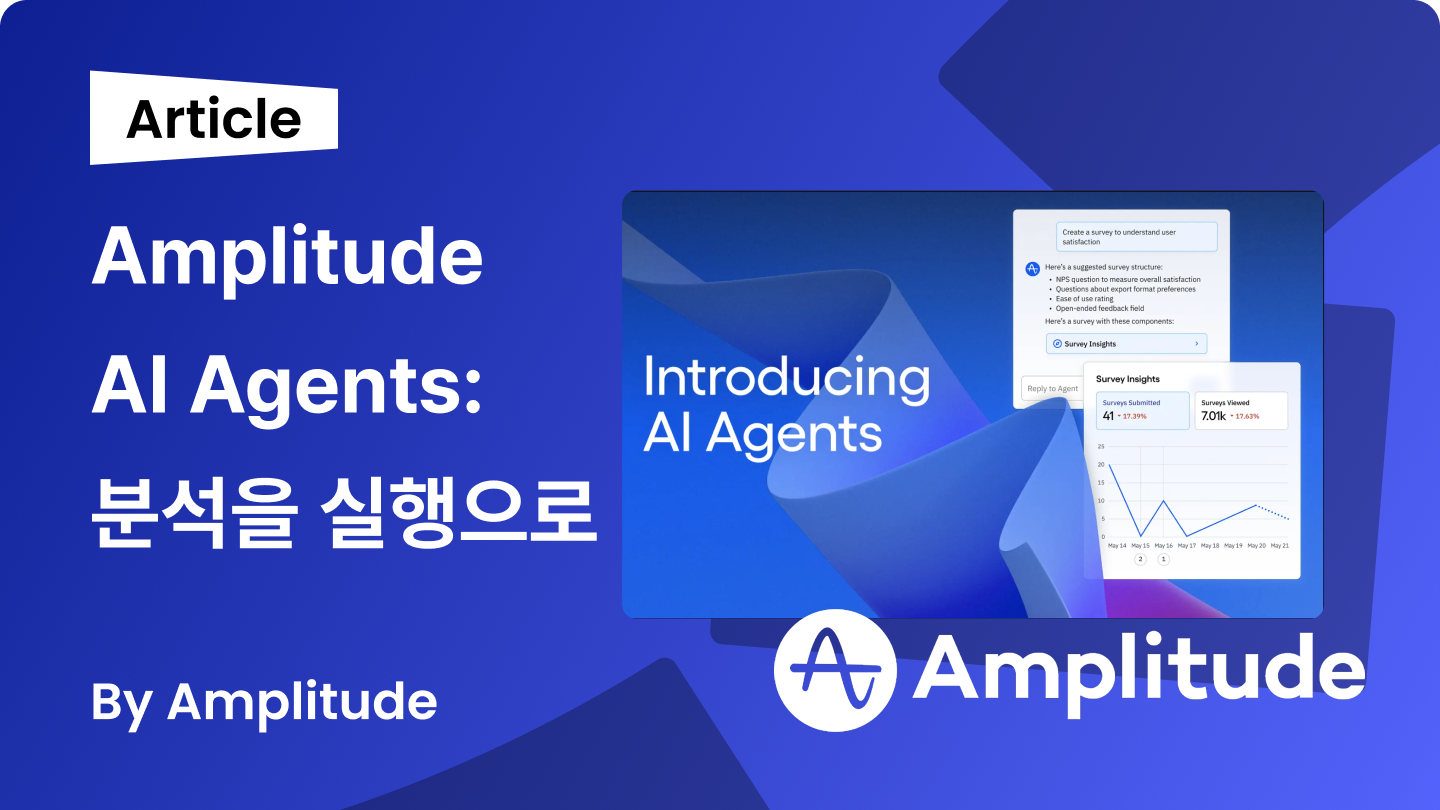

오늘날 수많은 AI 제품이 나왔지만, 데이터를 수집하고 해석하는 과정은 여전히 수동적이고 시간이 많이 소요됩니다.

특히 빠르게 변화하는 시장 환경에서는 데이터가 부족한 것이 아닌 데이터를 바탕으로 ‘문제’를 찾고, 이것을 ‘행동’으로 전환하는 과정에서 많은 어려움이 발생합니다.

앰플리튜드는 이러한 문제를 해결하기 위해 AI Agents를 출시했습니다. Amplitude AI Agents는 단순히 데이터를 시각화하거나 인사이트를 제공하는 도구를 넘어, 문제를 발견하고 원인을 분석하며 다음 단계를 제안하는 역할을 수행합니다.

지금부터 앰플리튜드의 새로운 기능, Amplitude AI Agents를 알아보겠습니다.

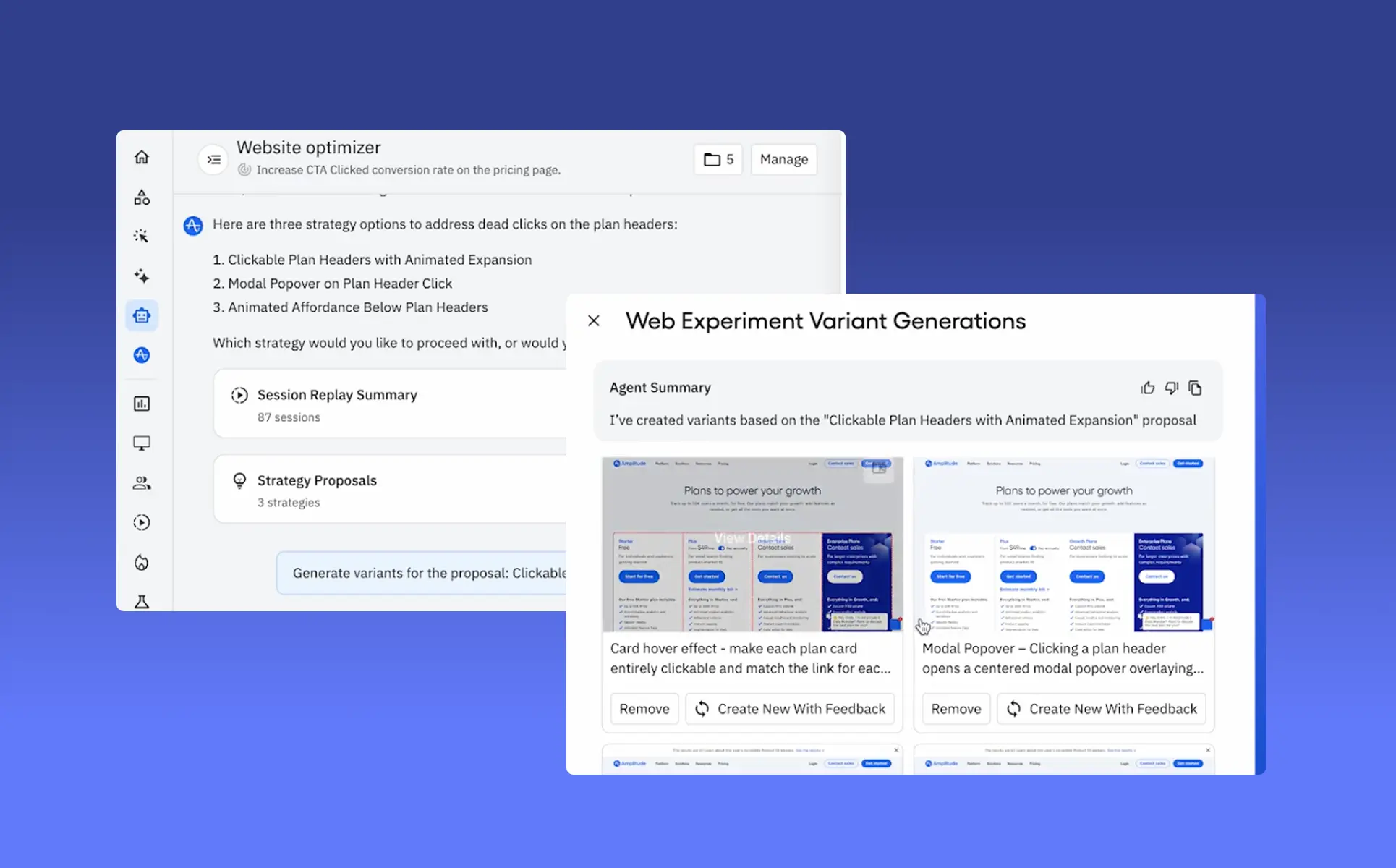

기존의 분석 도구가 '무엇이 일어났는지'를 보여주는 데 집중했다면, Amplitude AI Agents는 '무엇을 해야 하는지'까지 제안합니다.

Amplitude AI Agents는 웹사이트 전환율 향상, 온보딩 경험 개선 등 팀이 달성하고자 하는 구체적인 목표를 설정할 수 있습니다.

목표 설정이 완료되면, Agents는 24시간 행동 데이터, 세션 리플레이 등 계정 전반의 데이터를 수집하고 분석합니다.

이를 바탕으로, ‘인사이트’ 단계에서 근본 원인 분석을 실행하고 세션 리플레이를 검토하여 문제의 원인을 파악합니다. 이후 ‘액션’ 단계에서 A/B 테스트를 설계하거나 특정 코호트에 맞는 제품 내 가이드를 배포하는 등 구체적인 다음 단계를 제안합니다.

.webp)

Amplitude AI Agents는 다른 AI 도구와 명확한 차이가 있습니다.

대부분의 분석 도구는 AI 기반 인사이트와 권장 사항을 제공한 후 다음 단계를 ‘사용자’에게 맡깁니다. 실행과 의사결정 권한이 사람에게 있는 것이죠.

하지만 Amplitude AI Agents는 인사이트 도출을 넘어 실질적인 행동을 수행할 수 있도록 설계되어있습니다.

Amplitude AI Agents는 이런 차별점을 바탕으로, 팀에 대한 지식과 실제 업무 사이의 격차를 줄여줍니다.

Amplitude AI Agents는 다양한 비즈니스 상황에서 실질적인 성과를 만들어냅니다.

여전히 많은 팀이 아래와 같은 고민을 안고 있습니다.

하지만 Amplitude AI Agents는 지식과 실행 사이의 격차를 줄여 이 고민들을 해결해줍니다.

"데이터는 있지만 이를 활용할 시간이 없다"

"데이터 속에 인사이트가 있다는 것을 알지만 파헤칠 여유가 없다",

"데이터 중심적인 조직이 되고 싶지만 분석 인력이 부족하다"

이를 통해 팀은 전략적 우선순위에 집중하고, AI Agents는 여러 가설을 테스트하며 비즈니스 KPI 달성에 적합한 인사이트를 도출할 수 있습니다.

마티니는 앰플리튜드의 공식 파트너로서, 고객사가 AI Agents를 포함한 앰플리튜드의 기능을 효과적으로 활용할 수 있도록 지원하고 있습니다.

지금 아래 버튼을 눌러, 마티니와 함께 ‘인사이트’에서 끝나는 것이 아닌

‘실행’으로 이어지는 데이터 분석을 시작해보세요.

단기간에 참여형 프로모션의 전환율을 높이는 것은 퍼포먼스 마케팅에서 중요한 과제 중 하나입니다.

이번 실험은 특정 제품을 실제로 사용 중인 유저만 참여할 수 있는 응모형 이벤트를 기반으로,

한정된 예산 내에서 실제 반응 가능성이 높은 유저를 얼마나 효율적으로 찾아낼 수 있는지를 검증하기 위해 진행하였습니다.

이벤트의 특성상, 이미 관련 제품을 사용하거나 브랜드에 높은 관심을 가진 고관여 타겟층이 중심이었습니다.

따라서 일반적인 인지도 캠페인보다 정교한 타겟팅과 빠른 최적화 전략이 필요했습니다.

이번 실험은 단순히 매체별 효율을 비교하는 수준을 넘어,

특히 소액 예산 환경에서도 명확한 타겟 정의와 데이터 기반 세팅만으로 전환 효율을 확보할 수 있는지를 확인한 실험으로,

향후 제품 이용 경험자를 중심으로 한 리인게이지먼트 캠페인이나 관심 기반 이벤트 마케팅 전략 수립에도 활용할 수 있는 인사이트를 얻을 수 있었습니다.

📌 고려한 주요 조건은 다음과 같았습니다 :

이 기준을 바탕으로 두 채널을 선정하고, 동일한 조건에서 매체별 효율 차이를 검증할 수 있도록 실험 구조를 설계하였습니다.

이번 캠페인은 고관여 유저 대상의 이벤트 응모를 목표로, 매체별 정제된 타겟 세팅과 명확한 전환 흐름을 고려하여 운영하였습니다.

카카오모먼트 소재 예시

Meta 소재 예시

CTR과 회원가입 전환율에서는 Meta가, CPM과 ROAS 측면에서는 카카오모먼트가 우세한 결과를 보였습니다.

이번 캠페인은 이벤트 응모라는 비교적 고관여 행동을 유도하기 위한 테스트 캠페인으로, 매체별 타겟 정교도와 퍼널 내 전환 흐름을 비교·분석해볼 수 있었습니다.

이번 실험은 고관여 유저를 대상으로 한 응모 전환 실험이었기에

광고 성과뿐 아니라 타겟 정교화 → 퍼널 설계 → 행동 유도 전반에 걸쳐 여러 시사점을 남겼습니다.

짧은 기간의 테스트라도, 타겟-메시지-지표 정의가 명확하면 단기 성과 뿐 아니라 장기 전략에도 유의미한 인사이트를 남길 수 있는 실험이었습니다.

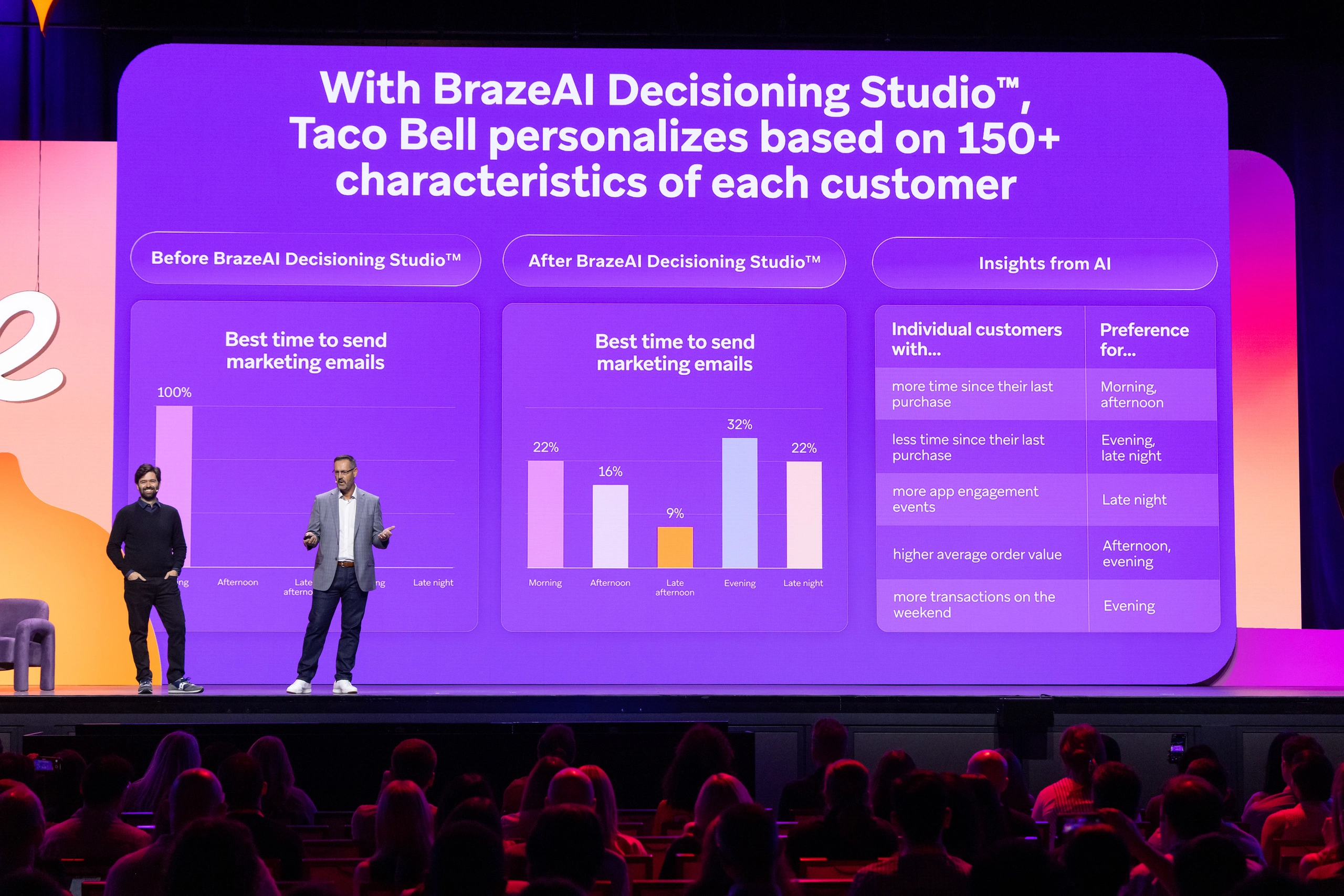

지난 BrazeAI 신규 기능 소개에서 BrazeAI Decisioning Studio™를 소개드렸었습니다. BrazeAI Decisioning Studio™는 유저 행동 데이터를 바탕으로 적합한 메시지, 발송시간, 개인화 등 CRM 메시지에 필요한 모든 요소를 스스로 의사결정하는 신규 기능입니다.

AI가 직접 의사결정을 내림에 따라 A/B 테스팅, 개인화 구현, 목표 최적화 등에 들이는 시간을 최소화하고, 더 높은 성과까지 기대할 수 있습니다.

이번 릴리즈 노트에는 BrazeAI Decisioning Studio™를 사용하기 위한 가이드 문서가 업데이트되었습니다. 가이드 문서에는 연동, 에이전트 활용, 리포트 확인 관련 내용이 추가되었으며, 링크에서 확인하실 수 있습니다.

앞으로 AI를 활용한 CRM 마케팅이 마케터의 업무와 필요 역량에 큰 변화를 가져올 것으로 예상되니, 미리 파악해두시면 좋을 것 같습니다.

올해 브레이즈는 WhatsApp을 비롯하여 RCS, Line등 신규 채널 추가에 힘쓰고 있습니다. 이번 업데이트에서는 새롭게 추가된 RCS, Line에 대한 클릭, 발송 등 메시지 상호작용 관련 데이터도 Currents로 데이터를 전송할 수 있도록 추가되었습니다.

특히, 한국에서는 문자 대비 비용 효율이 좋고, 보다 양방향 소통이 가능한 채널인 RCS 활용량이 증가할 것으로 기대되는데요. 브레이즈에서 RCS가 신규 기능으로 출시되고 그에 대한 데이터 연결까지 수월해져, 브레이즈를 통한 RCS 메시지가 더욱 중요해질 것 같습니다.

CRM 마케터라면 모든 캠페인에 매 번 필터링으로 특정 유저들을 타겟에서 제외하거나, Frequency에 대한 고민을 가진 경험이 있으실텐데요. 이제는 Suppression List를 활용하여 편리하게 이 고민을 해결할 수 있습니다.

Suppression List는 특정한 세그먼트를 설정하여, 해당 세그먼트는 아무런 메시지도 받지 않도록 하는 기능입니다. 기존의 베타버전에서 General Access 버전으로 정식 출시되었습니다.

Suppresion List에 특정 유저들을 의도적으로 메시지 수신 대상에서 제외하거나, 메시지의 노이지함을 막기 위해 N일 내 메시지 열어본 사람을 대상에서 제외하는 등 다양한 조건을 적용할 수 있습니다.

제로카피 개인화(Zero-copy Personalization)는 별도로 브레이즈 내에 데이터 수집 과정을 거치지 않고 즉시 개인화에 데이터를 사용하는 방법입니다. 데이터 수집 과정이 없기 때문에 개발의 편리함도 챙길 수 있고, 동시에 Datapoint나 보안 문제 등으로부터 상대적으로 자유로워질 수 있습니다.

이제 브레이즈 캔버스(Canvas)에서 CDI(Cloud Data Ingestion)를 이용하여 DW에 수집된 데이터를 브레이즈로 보내어 데이터 저장 없이 개인화에 사용할 수 있습니다.

아직은 얼리 액세스 단계로, 사용을 위해서는 리셀러를 통해 오픈 요청을 해야하는 단계이며, 상세한 사용 방법은 링크를 통해 확인하실 수 있습니다.

상품을 검색하고, 클릭하고, 장바구니에 담고, 결제하기까지. 고객의 쇼핑 여정은 몇 번의 클릭으로, ‘정말 단순하게’ 끝나는 것처럼 보입니다.

하지만 그 짧은 순간 안에는 수십 개의 화면 전환과 수백 개의 기능, 그리고 그보다 더 많은 데이터의 흐름이 얽혀있습니다.

아직도 많은 팀이 이 복잡함을 과소평가한 채 택소노미(Taxonomy)를 설계하거나 이벤트를 수집하기 시작합니다. 그 결과, '데이터 분석' 단계에서 어려움을 호소하시는 분들이 많습니다.

“이 이벤트는 정확히 어디서 발생한 거지?”

“정의된 경로 외에 다른 트리거 포인트가 있나?”

이런 질문은 서비스가 고도화될수록 더 자주 발생합니다. UI·UX가 개편될 때마다 예외 케이스가 생기고, 처음 정의했던 이벤트 구조는 점점 흔들립니다. 결국 데이터 정리는 계속 밀리고, 어느 순간 서비스 변화의 속도를 따라잡지 못하는 악순환에 빠지게 됩니다.

이러한 악순환을 줄이고 서비스 전체의 맥락 속에서 데이터를 이해하기 위해 필요한 첫 번째 단계가 바로 IA(Information Architecture, 정보 구조도) 설계입니다. 이번 글에서는 IA가 데이터 분석에서 왜 중요한지 알아보겠습니다.

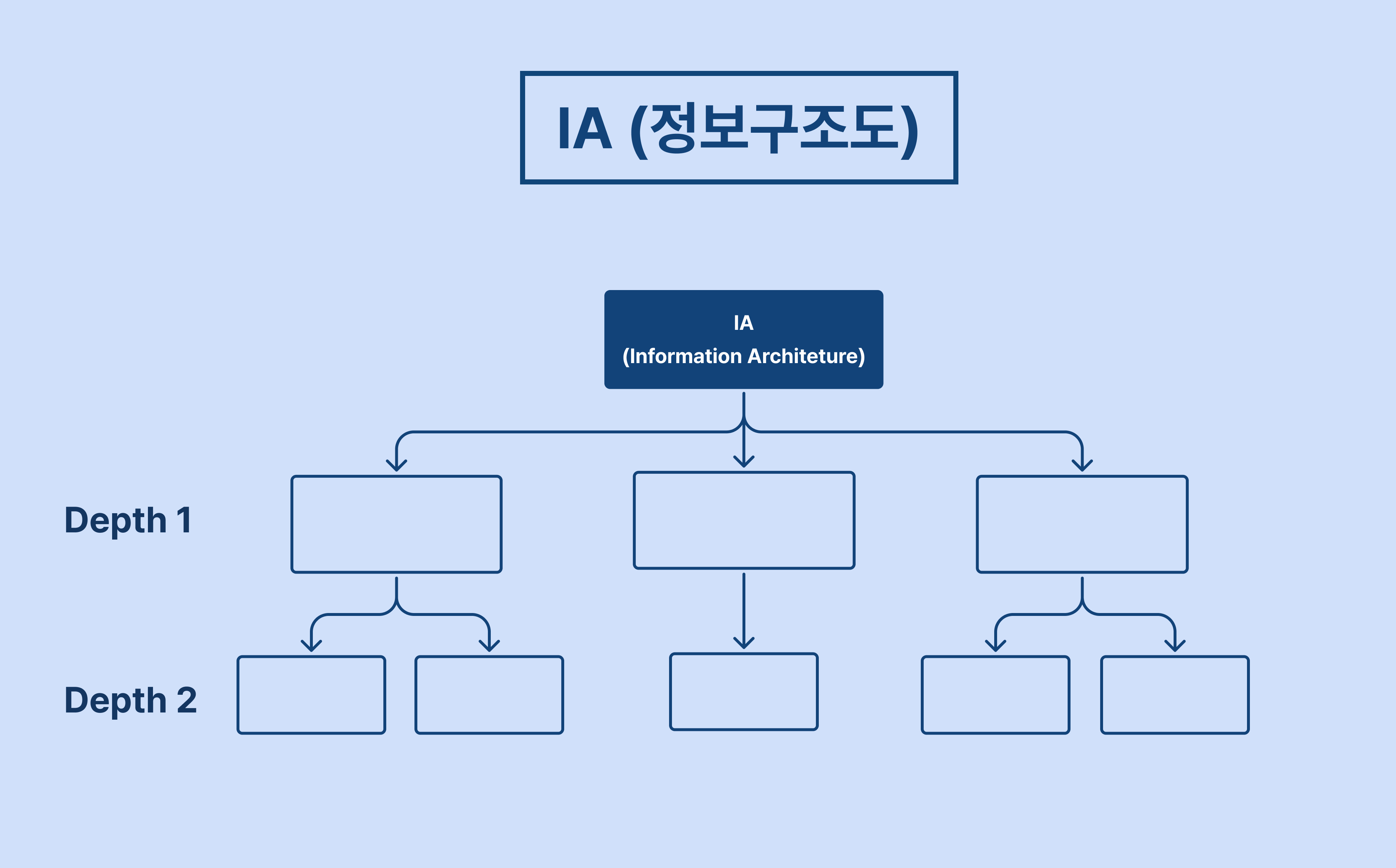

IA(Information Architecture)는 보통 서비스 개발 전 기획 단계에서 사용됩니다.

이는 웹이나 앱 안에 존재하는 수많은 화면, 버튼, 기능을 한눈에 볼 수 있도록 체계적으로 정리한 서비스의 지도이자 목차라고 볼 수 있습니다.

이 단계에서는 서비스의 전체 구조를 체계적으로 정리하고, 각 페이지와 기능을 계층적으로 정의하는 데 중점을 둡니다.

.webp)

이렇게 정의된 IA는 와이어프레임과 유저 플로우 설계와 연결되어 발전시킬 수 있는데요.

와이어프레임(Wireframe)이 실제 화면을 기준으로 사용자의 이동 경로를 보여준다면, IA는 그보다 한 단계 위에서 서비스 전체의 계층별 구조를 보여주는 설계도 역할을 합니다.

결국 서비스 구조를 먼저 이해해야만 사용자가 거치는 모든 여정과 흐름을 온전히 파악할 수 있습니다.

그렇다면, 이미 서비스가 출시된 상황에서 다시 IA를 그린다는 건 어떤 의미일까요? 단순히 구조를 정리하거나 문서를 업데이트하기 위한 작업일까요? 사실 그렇지 않습니다.

데이터 분석은 결국 '사용자가 어떤 화면에서 어떤 행동을 했는가'를 해석하는 일입니다. 서비스 구조를 파악하지 않은 채 데이터를 분석하면, 이벤트는 맥락을 잃고 분석은 반복적으로 막힙니다.

IA가 데이터 분석의 출발점인 이유는 명확합니다. 모든 분석의 기준점이 되기 때문입니다. 이제 왜 중요한지, 세 가지로 나눠 알아보겠습니다.

데이터 분석에서 가장 중요한 질문은 이것입니다.

"이 이벤트가 어디서, 어떤 맥락에서 발생했는가?"

IA를 기준으로 각 화면과 기능을 정리해두면, 어떤 페이지에서 어떤 이벤트가 발생해야 하는지를 명확히 정의할 수 있습니다. 즉, IA는 이벤트 매핑의 기준점이 됩니다.

이 기준점이 있으면 분석가는 데이터의 맥락을 잃지 않고, 이벤트가 누락되거나 중복 수집되는 지점을 빠르게 찾아낼 수 있습니다. 문제를 발견하는 시간이 줄어들고, 분석은 더 정확해집니다.

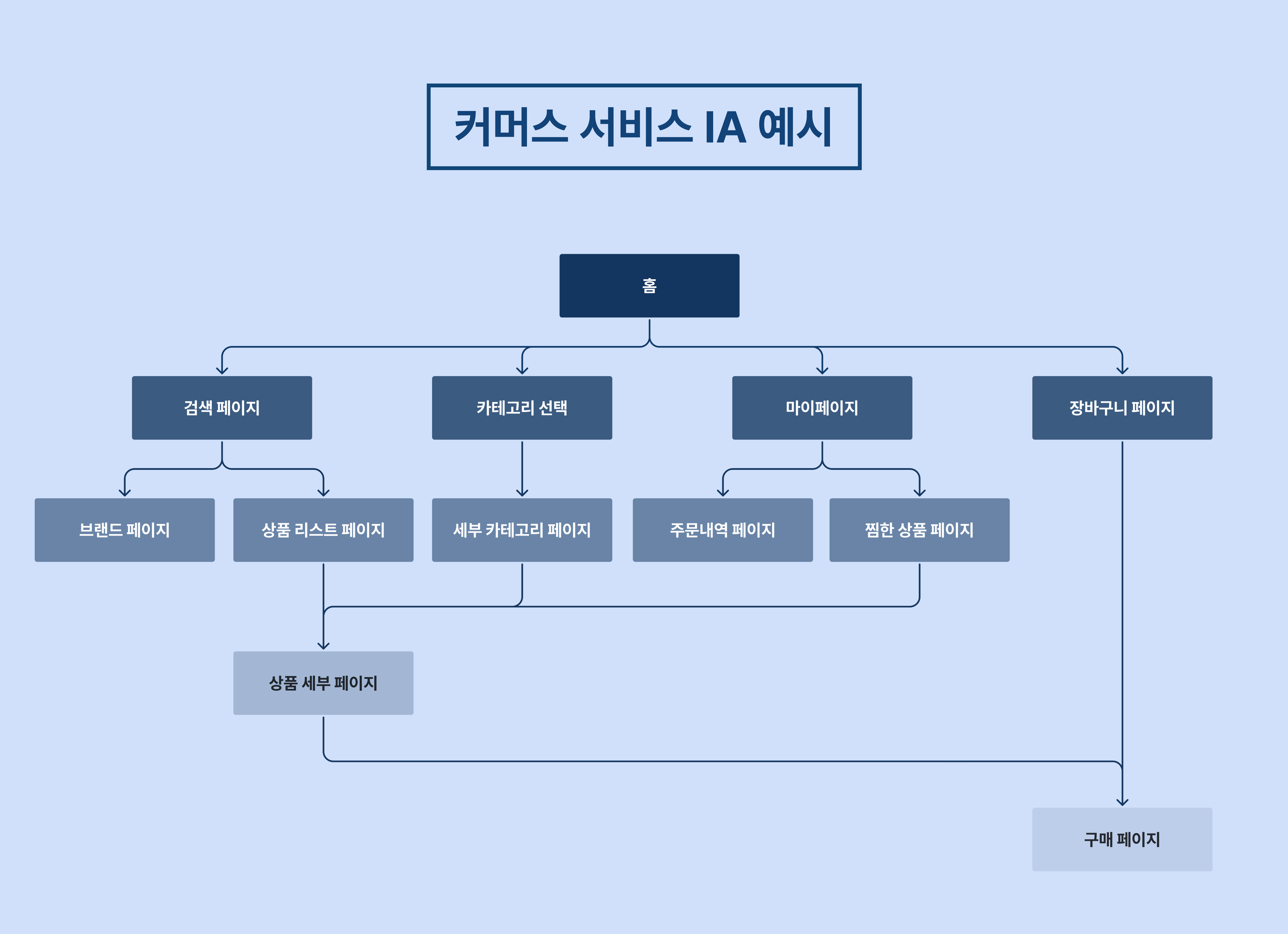

커머스 유저 여정은 단순해 보이지만 꽤 복잡합니다.

일반적인 홈 → 검색 → 상품 상세 → 장바구니 → 주문/결제라는 프로세스에 속하지 않는 예외 케이스와 변형 경로가 많기 때문입니다.

이때 IA로 전체 구조를 보면, 각 단계의 전환과 이탈 지점을 구조적으로 파악할 수 있습니다.

위 사진은 커머스 서비스를 시각화한 IA 예시입니다. 모든 흐름을 한눈에 파악할 수 있습니다.

이처럼 각 화면에서 발생해야 하는 이벤트를 미리 정의해두면, 실제 분석 단계에서 '이 이벤트가 어디서 왔는지' 명확히 정의할 수 있습니다. 또한 서비스가 개편되어도 IA를 기준으로 변경 사항을 추적할 수 있어, 데이터 구조의 일관성을 유지할 수 있습니다.

이처럼 복잡한 사용자 여정 과정을 수반하는 대규모 서비스일수록, IA 설계를 통해 퍼널 설계의 정확도를 높이고 전환율 최적화나 리텐션 분석의 토대를 마련할 수 있습니다.

서비스가 커질수록 이벤트와 프로퍼티는 점점 복잡해집니다.

이때 IA는 전체 서비스의 지도 역할을 합니다. 어떤 화면이 어떤 기능과 연결되는지, 새로운 기능이 추가되면 어디에서 구조가 변하는지를 IA를 통해 빠르게 파악할 수 있습니다.

이런 구조적 기준이 있으면, 이벤트 네이밍, 프로퍼티 정의, 페이지 기준 등 데이터 표준화 작업을 쉽게 검증할 수 있습니다. 결국 IA는 단순한 설계 문서를 넘어, 데이터 분석 유지보수 비용을 줄이는 강력한 도구가 됩니다.

서비스가 커질수록 '어디서 문제가 생겼는지', '이 이벤트가 정확히 어디서 발생했는지'를 빠르게 파악하는 기준이 필요합니다. IA는 바로 그 기준을 만들어주는 작업입니다.

IA를 통해 서비스 흐름을 구조적으로 정리하면, 이벤트 수집 지점을 명확히 파악할 수 있고, 퍼널 설계와 데이터 분석의 정확도를 높일 수 있습니다. 더 나아가 팀 간 커뮤니케이션 비용을 줄이고, 데이터 거버넌스 체계를 탄탄하게 만들 수 있습니다.

결국 IA 설계는 '지금 당장의 효율'을 위한 일이 아닌, 장기적으로 데이터 분석 비용을 줄이기 위한 투자입니다. ‘지속 가능한 데이터 분석 환경' 구축을 시작하고 싶다면, 지금 바로 마티니와 만나보세요.

이런 메시지, 매일 받고 계시나요? (*아마 CRM마케터라면 직접 보내고 계실지도 모릅니다.)

지금 우리는 메시지가 넘치는 시대에 살고 있습니다. 처음부터 성가시진 않았습니다. 하지만, 어느 순간부터 우리는 이러한 CRM 메시지에 무뎌지기 시작했습니다. 언제부터 우리는 피로감을 느끼게 된 걸까요?

2021년 경부터 개인정보 보호 정책이 강화되면서 퍼포먼스 마케팅 효율이 떨어졌습니다. 그 결과, 1st-party Data(기업이 직접 수집한 고객 데이터)를 중심으로 한 CRM 마케팅이 빠르게 부상했습니다. 민첩한 스타트업부터 시작해 SMB, 대기업까지 CRM을 안하는 곳을 찾기 어려운 시대가 되었습니다.

예전에는 몇몇 주요 서비스에서만 CRM 메시지를 보냈다면, 이제는 거의 모든 앱이 하루에 한 번 이상 메시지를 보냅니다. 2021년부터 지금까지, 메시지 피로도는 이렇게 꾸준히 쌓여왔습니다.

CRM 솔루션 브레이즈(Braze)는 피로도 높은 CRM 생태계의 현 상황을 ‘고객과의 대화(Conversation)’가 아닌 ‘Digital Shouting’, 즉 ‘디지털 외침’에 가깝다고 표현했습니다. 고객과 대화를 주고 받기보다는, 기업이 일방적으로 메시지를 쏟아내고 있다는 의미죠.

실제로 Push, LMS, 카카오(Kakao) 등 기존 CRM 채널 대부분은 일방향 소통 구조에 가깝습니다. 고객이 메시지를 받은 후 취할 수 있는 행동은 ‘링크 클릭’, ‘수신 거부’, 또는 ‘무시하기’ 3가지 뿐입니다. 관심 있는 메시지라면 링크를 클릭해 상호작용할 수 있지만, 관심 없는 메시지는 무시되거나 수신 거부당할 수밖에 없습니다. 고객의 니즈를 파악하거나 피드백을 받을 방법이 없는 것이죠.

그렇다면 고객에게서 다양한 반응을 유도하며 상호작용할 수 있는 채널도 있을까요? 이 질문에 대한 대답을 한 눈에 이해하기 쉽게 표로 정리해봤습니다.

고객과 상호작용을 이끌 수 있는 채널에는 대표적으로 인앱메시지가 있습니다. 인앱메시지는 1-Button, 2-button, 고객 직접 작성 응답 받기 등 형식을 다양하게 구성할 수 있기 때문에, 고객의 다양한 반응을 받으며 양방향 소통이 가능합니다. 또한 유저가 앱에서 활동 중일 때 노출되기 때문에 고객의 여정에 자연스럽게 녹아들고, 유저는 맥락에 맞춰 즉각적으로 반응할 수 있습니다.

하지만, 인앱메시지에는 치명적인 한계가 있습니다. 바로 유저가 앱을 실행해야만 메시지를 볼 수 있다는 점입니다. 아무리 고도화된 소통이 가능한 인앱메시지를 구현하더라도, 앱을 열지 않는 유저에게는 전달조차 되지 않습니다. 그렇기 때문에 Push, LMS, 카카오톡과 같은 아웃바운드 채널에 비해 도달 범위가 현저히 좁을 수 밖에 없습니다. 특히 휴면 유저나 이탈 위험이 있는 유저에게는 사실상 무용지물이죠.

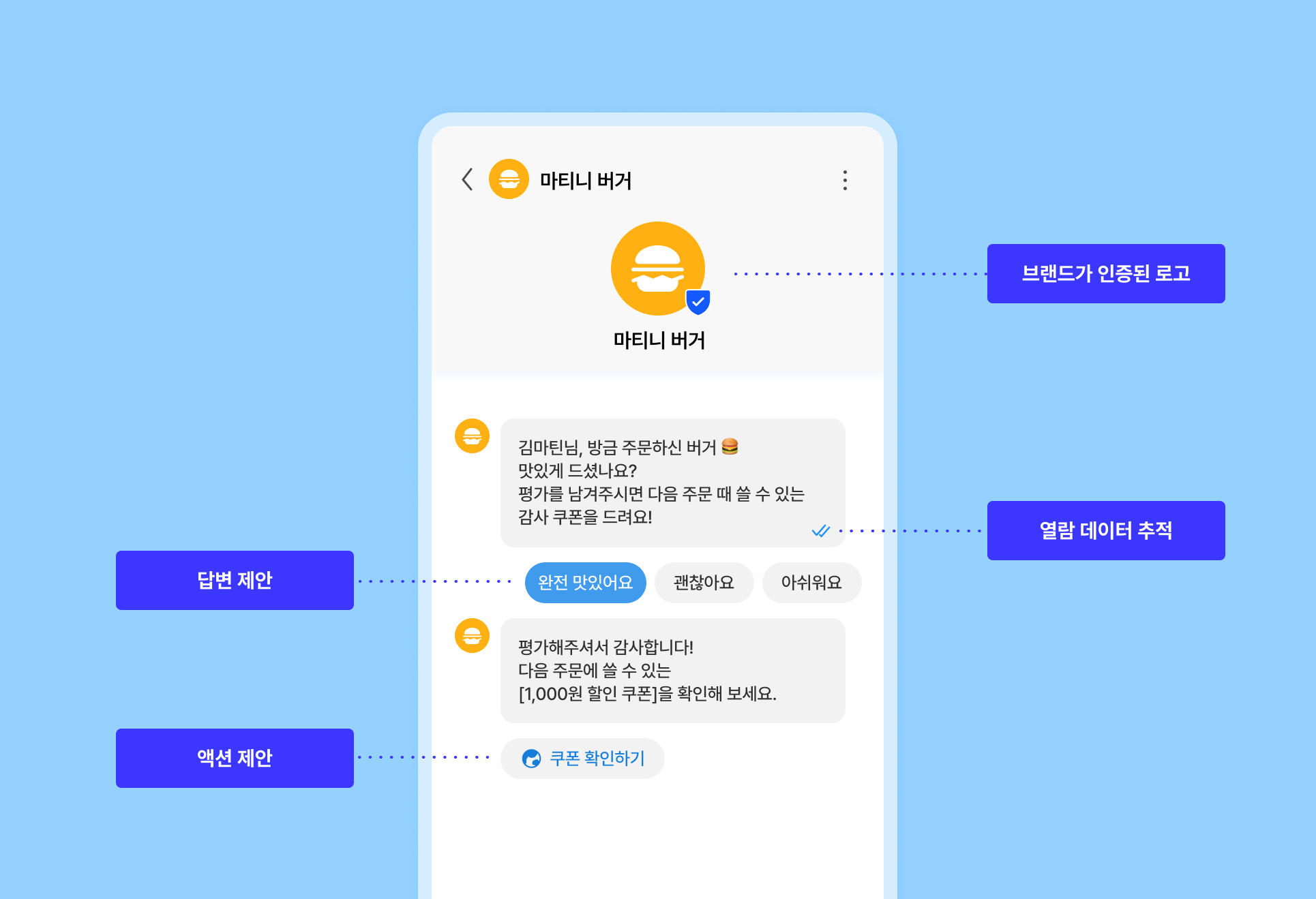

RCS(Rich Communication Services)는 차세대 문자 메시지로, SMS/LMS의 진화형으로 볼 수 있습니다. 기존 문자와 다르게 특정 응답이나 액션을 제안할 수 있죠. 쉽게 말하자면, “문자를 IAM이나 친구톡처럼 만들 수 있는 채널”이라고 보면 됩니다. 게다가 앱에 들어오지 않아도 보낼 수 있다는 점에서 IAM보다 도달력이 높기도 합니다.

위 RCS 기능을 활용한다면, 일반 문자와 달리 IAM과 친구톡처럼 다양한 응답을 받을 수 있습니다. 일방적인 CRM 채널에 피로감을 느끼는 고객이 많은 현 시점에서 쌍방향 소통이 가능한 RCS는 새로운 돌파구가 될 수 있습니다. 실제로 브레이즈에 따르면 소비자의 74%가 SMS보다 RCS로 브랜드와 소통하는 것을 선호한다고 합니다.

브레이즈가 Braze Forge 2025에서 RCS 활용 사례를 최초로 공개했는데요, 마티니 CRM팀이 직접 현장에 보고 들은 내용을 공유합니다.

브레이즈는 Create Contextual 1:1 Interactions(맥락을 고려하는 1:1 상호작용을 만들기)의 예시로 위 사례를 공유했습니다. 블러셔 쇼핑을 고민하는 고객에게 ‘크림’, ‘파우더’, ‘액상’ 중 어떤 타입 블러셔를 원하는지를 묻는 첫번째 메시지를 보냅니다. 이 때 RCS 다중 버튼을 활용하여, 고객이 필요한 옵션을 쉽게 선택할 수 있도록 유도합니다.

고객이 특정 응답을 선택하면, 응답한 내용에 기반한 두번째 메시지를 발송합니다. 고객이 크림 타입을 선택했다면, 고객이 좋아할 만한 특정 상품을 추천하는 2차 메시지를 보내는 것이죠. 고객은 이러한 과정을 통해 브랜드와 진정한 소통을 한다고 느낄 수 있습니다.

RCS, 아직 국내에서는 모든 기능을 온전히 사용할 수 있는 상태는 아닙니다. 그럼에도 불구하고, 마티니 CRM팀은 RCS를 지금, 누구보다 빠르게 시작해야 한다고 보고 있습니다. 그 이유는 크게 3가지로 나눠볼 수 있습니다.

기존 채널의 CRM 성과가 확연히 떨어지고 있습니다. 가장 대표적인 것이 Push입니다. 실제로 현업 CRM 마케터 분들과 대화를 나눠보면 Push 오픈율과 전환율이 예전만 못하다는 걸 체감하고 있다고 합니다. 그래서 많은 기업이 IAM, 카카오 친구톡/알림톡, SMS/LMS 등으로 채널 다각화를 진행하고 있습니다.

하지만, 이 채널들 역시 피로도가 점차 쌓여가고 있습니다. 기존 채널에 대한 피로도가 높아질수록, 신선한 경험을 제공하는 신규 채널에 대한 관심은 더욱 커질 수밖에 없습니다. 바로 지금이 RCS를 시작해야 할 타이밍입니다.

RCS(SMS) 기준, 일반 SMS와 발송 단가는 비슷하면서도 더 많은 글자 수와 CTA 버튼을 포함할 수 있습니다. LMS와 비교하면 발송 비용도 1/3 수준으로 경제적이죠.

그렇다면, RCS로 기대할 수 있는 성과는 어떨까요? 브레이즈는 Forge 2025에서 RCS가 SMS 대비 최대 300% 높은 응답율과 최대 250% 더 높은 전환율을 기록했다고 발표했습니다. ROI 관점에서도 RCS는 지금 고려해야 할 채널이라고 볼 수 있습니다.

현재 국내에서 RCS는 안드로이드(Android) 환경에서만 사용 가능하고, Rich Card 같은 일부 기능도 제한적입니다. 완벽한 환경은 아닌 셈이죠. 하지만 바로 이 시점이 기회이기도 합니다. 아직 많은 기업이 RCS를 본격적으로 활용하지 않는 지금, 먼저 시작하면 고객에게 새로운 경험을 제공하는 선도 브랜드로 자리매김할 수 있습니다. 선두 주자가 쌓아올린 노하우와 브랜드 인지도를 후발 주자가 따라잡는 데는 상당한 시간이 걸리기 마련입니다. RCS 생태계가 완전히 성숙하기 전, 지금이 바로 우위를 선점할 골든타임입니다. RCS 활성화의 선두주자가 되어보는 건 어떨까요?

마티니는 이미 롯데ON과 브레이즈를 통한 RCS 발송 첫 사례를 만든 경험이 있습니다. 마티니에서 제작한 RCS 템플릿으로, 현재 롯데ON에서는 실무자들이 직접 쉽게 브레이즈에서 RCS를 발송하고 있습니다. 현재는 배민상회에서 RCS로 채널 다각화를 진행하고 있습니다. 생소한 RCS도 마티니와 쉽게 시작해 보세요.

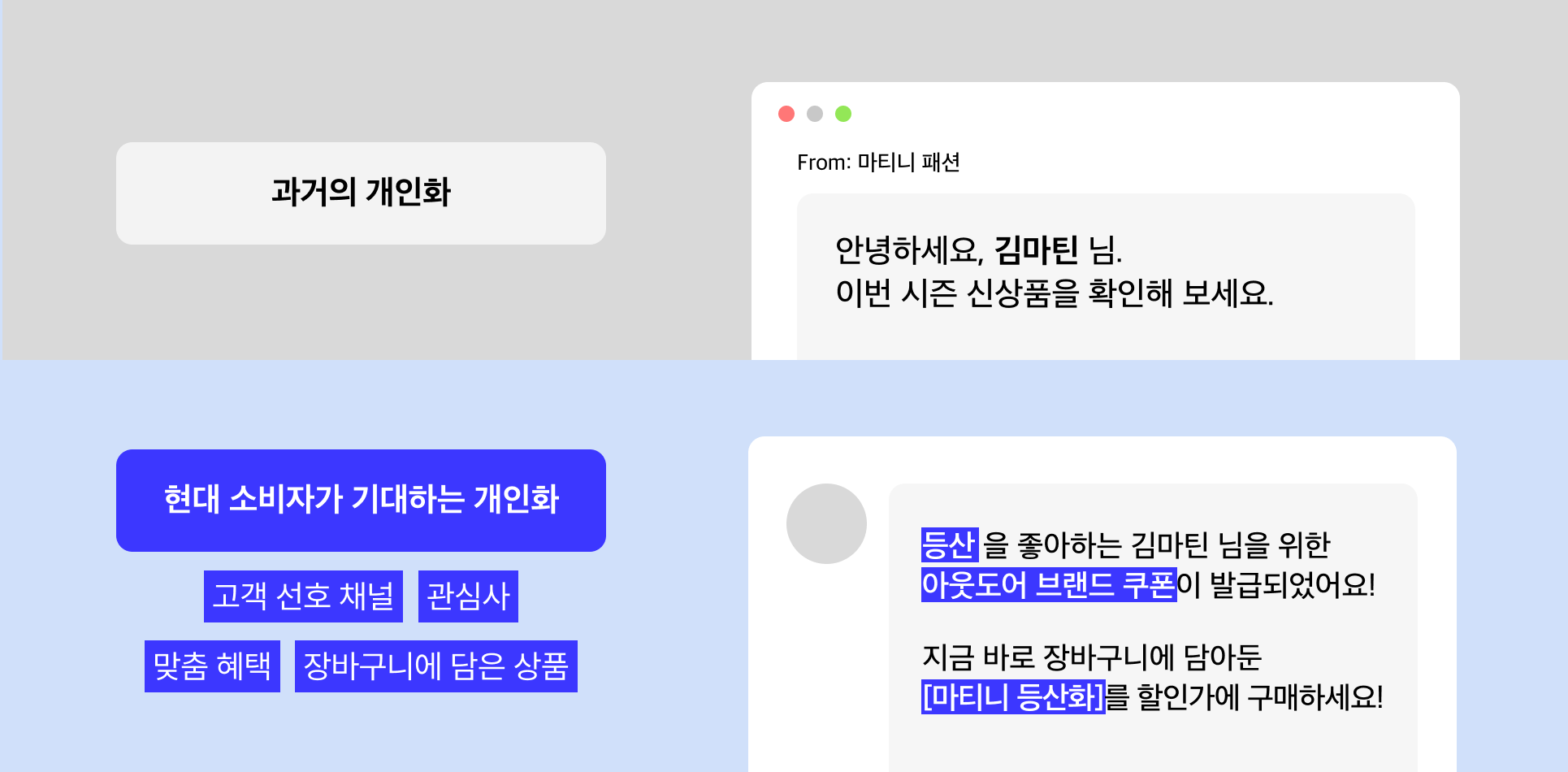

‘안녕하세요, {이름} 님’에 그치던 개인화는 발전을 거듭했습니다. 현대의 소비자들은 자신이 누구인지, 무엇에 관심이 있는지, 현재 어떤 위치에 있는지 반영하는 경험을 기대합니다. 결국, 이러한 기대를 충족하는 브랜드가 경쟁에서 우위를 점할 수 있습니다.

개인화를 위해서는 ‘개인화’를 위해 필요한 데이터가 제대로 수집되어야 합니다. 수집된 데이터는 세그먼트 구성부터 메시지에 이르기까지 다양하게 활용됩니다. 정확한 데이터가 수집될 때, 보다 효과적인 개인화가 가능해집니다.

이 때 활용하는 것이 이벤트 택소노미(Event Taxonomy)입니다. 이벤트 택소노미는 앞으로 수집할 데이터의 설계도 역할을 합니다.

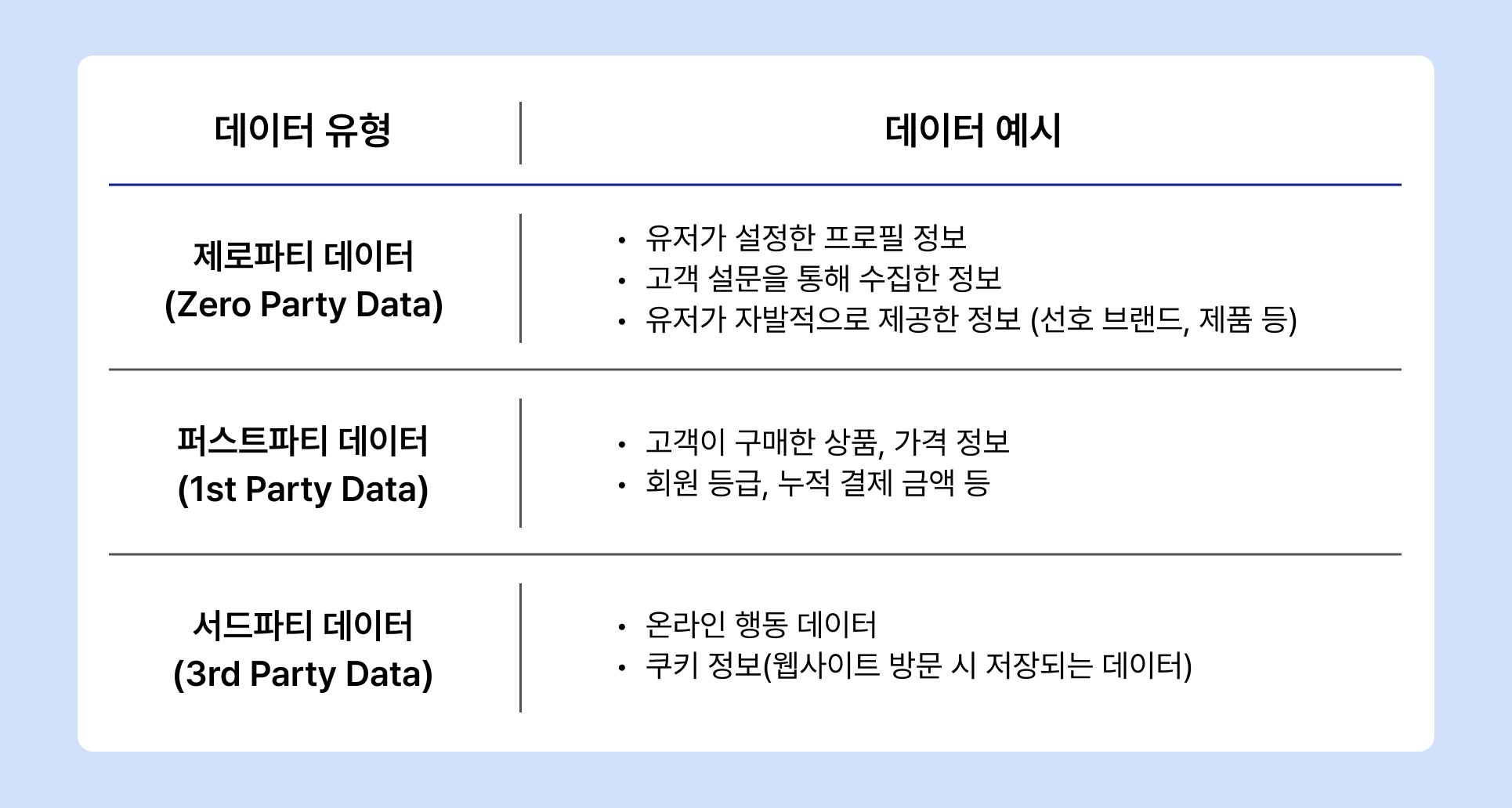

개인화 플랫폼은 고객이 명시적으로 제공하는 데이터인 제로 파티 데이터(Zero Party Data)부터, 이벤트 택소노미를 기반으로 쌓인 서드 파티 데이터(3rd Party Data)에 이르기까지 다양한 고객 데이터 소스를 활용합니다.

위에서 소개한 예시 외에도 다음과 같은 데이터를 개인화 플랫폼에서 활용할 수 있습니다.

고도화된 개인화를 위해서는 과거의 데이터가 아닌 ‘현재의 데이터’가 필요합니다. 실시간 데이터 동기화, 이벤트 스트리밍, 오픈 API를 브레이즈와 결합하여 수준 높은 개인화 캠페인을 구현해 보세요.

실시간 데이터를 활용하면 다음과 같은 이점이 있습니다.

장바구니에 담긴 상품 정보를 활용하여 크로스셀링을 유도하는 인앱 메시지(IAM) 사례입니다. 유저가 상품을 장바구니에 담았을 때 즉각적으로 노출하여, 연관 상품을 함께 구매할 수 있도록 합니다. 장바구니에 담긴 상품 이름, 이미지를 비롯해 하루동안 연관 상품을 구매한 사람 수를 함께 노출하여 동조 심리를 자극합니다.

유저에게 발급된 쿠폰 정보를 활용한 캠페인 사례입니다. 실제 발급된 쿠폰 이름을 메시지에 활용하고, 소멸 시점을 함께 안내해 구매를 유도할 수 있습니다. 이와 같은 개인화 캠페인은 메시지뿐만 아니라 발송 시점에도 개인화를 활용하여 각 유저별로 쿠폰 만료일이 도래했을 때 메시지가 자동으로 발송되도록 설정할 수 있습니다.

API를 활용해 실시간으로 불러오는 데이터는 개인화에 활용할 때 강력한 효과를 발휘합니다. 고객이 위시리스트에 넣어뒀거나, 장바구니에 추가한 상품 데이터를 바탕으로 실시간 할인 정보를 제공할 수 있습니다. 실제 고객이 구매 의사를 가지고 있는 상품을 활용하고, 시간/혜택 등이 한정되어 있다는 점으로 손실회피 경향을 자극해 높은 전환 성과를 기대할 수 있습니다.

브레이즈는 조건별 개인화를 넘어, 1:1 개인화 시대를 만들어 나가고 있습니다. AI를 활용해 개별 유저에게 발송되는 메시지, 채널, 발송 시간까지. BrazeAITM와 함께 활용할 수 있는 모든 데이터를 활용해 개인화 그 이상의 개인화를 구현해 보세요.

혹시 브레이즈를 도입했지만, 개인화 기능을 제대로 활용하지 못하고 있다고 느끼지는 않나요? 지금 마티니 브레이즈 부트캠프 에서 실무에 바로 적용 가능한 Personalization 전략을 배울 수 있습니다.

CRM 캠페인의 성과를 결정짓는 핵심은 고객 데이터를 어떻게 활용하느냐에 달려 있습니다.

이번 부트캠프는 Braze Certification을 보유하고 다수의 엔터프라이즈 CRM 마케팅을 실행해 온 전문가가 직접 진행하며, 고객 행동과 속성 데이터를 기반으로 한 메시지 설계부터 실시간 데이터 반영, 추천엔진 결합까지 실무 중심의 노하우를 전달합니다.

.webp)

.webp)

%20(1).webp)

%20(1).webp)

🔗 이벤터스 신청 페이지 | https://event-us.kr/m/115003/43753

지금 CRM 전문가와 함께, 브레이즈 부트캠프에서 고객 맞춤형 CRM 마케팅을 시작해 보세요!

.webp)

브레이즈는 최근 AI 기반 CRM 마케팅 개인화 서비스를 제공하는 오퍼핏(OfferFit)을 인수했습니다. 이를 통해 Braze AI Decisioning Studio 조직을 새롭게 구성하며, AI CRM으로서의 역량을 강화하고 있습니다.

올해 Braze Forge 2025에서는 이러한 변화가 더욱 명확히 드러났습니다. 신규 기능 대부분이 AI와 관련되어 있었고, 주요 세션들도 AI를 중심으로 진행되었습니다. 이러한 흐름은 CRM 마케팅 환경이 빠르게 변화하고 있음을 보여줍니다. AI를 활용한 개인화와 자동화는 이제 선택이 아닌 필수가 되고 있습니다.

그렇다면 CRM 마케터는 어떻게 AI를 효과적으로 활용하고, 성과를 극대화 할 수 있을까요? 이번 아티클에서는 Braze Forge 2025의 내용을 바탕으로, CRM 마케터의 AI 활용 전략을 살펴보겠습니다.

혹시 AI를 활용하면서 기대와 다른 결과로 인해 오히려 더 많은 리소스를 소모한 경험이 있지 않나요? 실제로 한 글로벌연구에 따르면, 약 60%의 마케터들이 AI 도입 후 생각보다 성과가 개선되지 않거나 약화되었다고 응답했습니다.

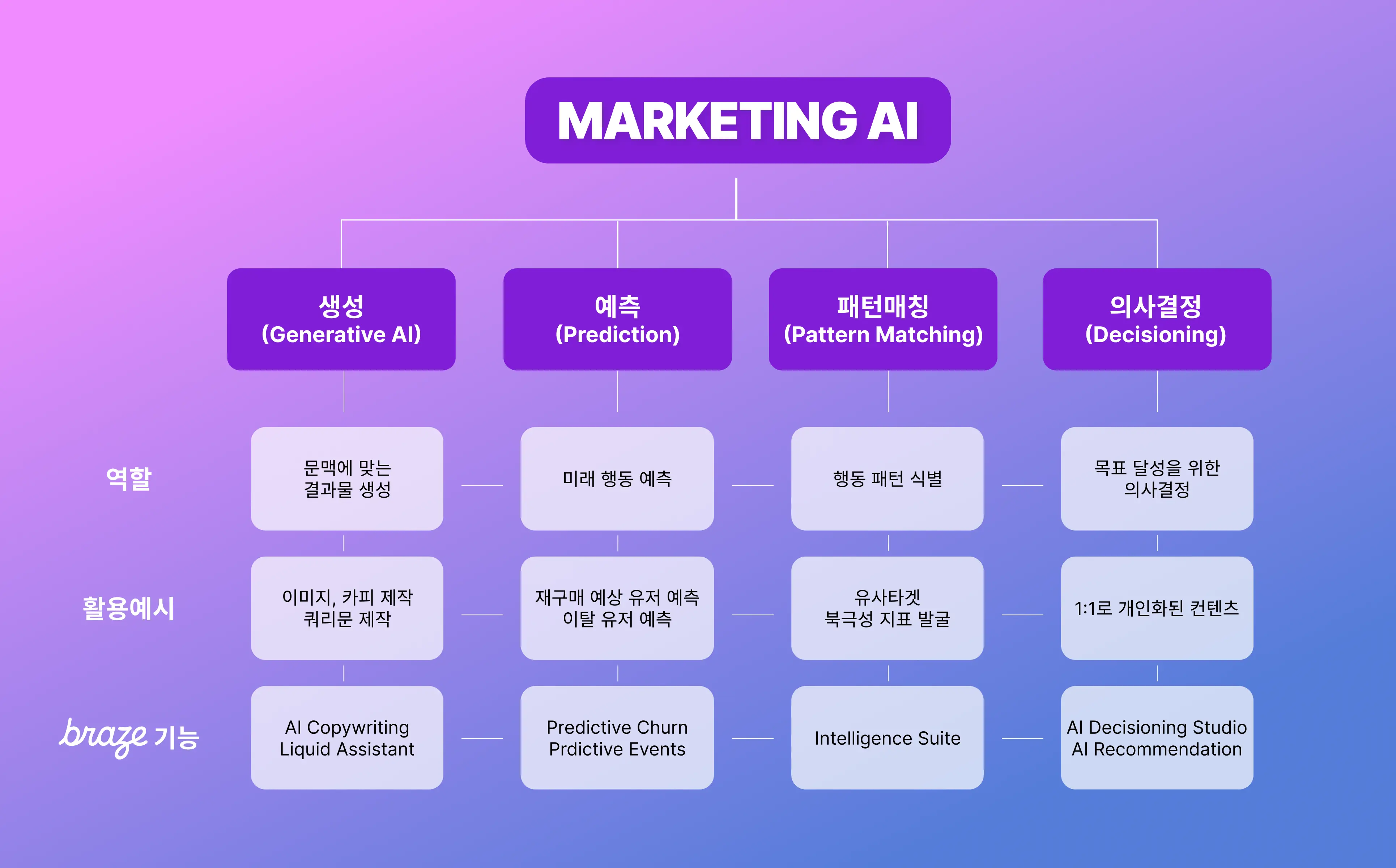

이러한 상황을 방지하려면 AI가 마케팅에서 어떤 역할을 수행할 수 있는지 명확히 이해해야 합니다. BrazeAI Decisioning Studio 리더인 George Khachatryan은 Forge 2025에서 AI의 기능을 다음과 같이 정의했습니다.

ChatGPT, Claude 등 LLM(Large Language Model)의 대표적인 방법입니다.

이탈 예상 고객을 붙잡을만한 카피 작성해 줘.

이 방법은 AI 토큰 단위로 텍스트를 이해하고 처리하며, 기존 문맥을 토대로 원하는 요구사항에 맞게 업무를 처리할 수 있습니다. 마케팅에서는 AI를 활용한 카피라이팅, 이미지 제작, 세그먼트 쿼리 작성 등이 생성형 타입의 머신러닝 형태에 해당됩니다.

브레이즈는 AI Copywriting, AI Image Generator, AI Query Builder 등의 기능을 통해 생성형 AI를 제공합니다. 추가로 SQL Segment Extensions와 Liquid Assistant 기능도 마케터가 복잡한 작업을 쉽게 처리할 수 있도록 돕습니다.

유저가 이미 수행했던 과거의 행동 데이터를 바탕으로 미래의 행동을 예측하는 방법입니다.

이 유저가 재구매를 할까?

예측을 위한 머신러닝은 '예' 또는 '아니오'처럼 명확한 답이 있는 질문에 적합합니다. "이 주식 가격이 오를까?", "내일 비가 올까?"와 같은 질문이 대표적인 예입니다. 마케팅에서는 이미 특정 행동을 수행한 유저들의 데이터를 학습합니다.

예를 들어, 과거에 이탈한 유저들과 구매한 유저들의 행동 패턴을 분석하여, 현재 유저 중 '이탈할 가능성이 높은 유저'나 '구매할 가능성이 높은 유저'를 예측합니다.

브레이즈는 이러한 예측기능을 제공합니다. Predictive Churn은 유저의 이탈 가능성을 예측하고, Predictive Events는 특정 전환 행동(구매, 가입 등)이 발생할 가능성을 예측합니다. 두 기능 모두 유저의 과거 행동 데이터를 학습하여 미래를 예측하는 방식으로 작동합니다.

패턴매칭은 유저의 행동에서 특정 패턴을 찾아내는 머신러닝 방법입니다.

메시지를 몇 시에 보내는게 좋을까?

예측과 마찬가지로 유저의 과거 행동 데이터를 분석하지만, 명확한 정답이 정해져 있지 않다는 점에서 차이가 있습니다. '예' 또는 '아니오'로 답하는 대신, "이 유저는 오후 7시에 푸시 알림을 가장 잘 확인한다"처럼 구체적인 패턴을 찾아냅니다.

마케팅에서는 전환한 유저와 행동 패턴이 유사한 타겟을 찾는 유사타겟(Lookalike) 분석이나, 비즈니스 성장을 이끄는 핵심 지표인 북극성지표를 발굴하는 데 활용됩니다.

브레이즈는 이러한 패턴매칭 기능을 Intelligence Suite로 제공합니다. Intelligent Timing은 유저별 최적의 메시지 발송 시간을, Intelligent Selection은 가장 효과적인 메시지 변형을, Channel Filter는 유저가 선호하는 채널을 학습하여 제안합니다.

사람이 아닌 AI가 의사결정을 하게 만드는 것이 목표입니다.

지금 우리는 무엇을 해야할까?

앞서 살펴본 예측, 패턴매칭, 생성형 AI는 모두 결과물을 제시하고 최종 의사결정은 사람이 내린다는 공통점이 있었습니다. 반면 의사결정형 AI는 설정된 KPI를 최적화하기 위해 스스로 판단하고 행동할 수 있습니다.

마케팅에서는 개인화와 상품 추천에 주로 활용할 수 있습니다. 어떤 유저에게 어떤 메시지를 보낼지, 어떤 제품을 추천할지, 심지어 메시지를 보낼지 말지까지 AI가 직접 결정합니다.

브레이즈는 이러한 의사결정형 AI를 여러 기능으로 제공합니다. 이번에 새롭게 공개된 AI Decisioning Studio와 AI Agent Console을 비롯해, AI Recommendation 기능을 통해 고객 데이터 기반의 AI 기반 의사결정을 실행할 수 있습니다.

그렇다면 CRM 마케터들은 어떻게 활용 수준을 파악하고, 더 적극적으로 AI를 활용할 수 있을까요? CRM 마케팅을 위한 AI 활용 전략은 크게 세 단계로 구분할 수 있습니다.

AI를 사용하지 않거나 생성형 AI만 일부 쓰는 경우

AI를 전혀 사용하지 않거나, 생성형 AI만 제한적으로 활용하는 경우 해당되는 단계입니다. 이 단계에서는 분석, 콘텐츠 생성, 의사결정의 부분에서 대부분을 사람이 직접 수행하기 때문에 작업 속도가 느립니다.

생성형 AI로 생성·예측·패턴 분석을 하지만, 최종 의사결정은 사람이 수행하는 경우

생성형 AI, 예측 모델, 패턴매칭을 활용하지만 최종 의사결정은 사람이 수행하는 단계입니다.

의사결정을 위한 분석과 실행 과정에서 효율이 크게 향상됩니다. 다만, 분석 결과를 바탕으로 한 룰 기반 개인화가 이루어질 뿐, 진정한 1:1 매칭 개인화라고 보기는 어렵습니다.

모든 의사결정을 AI 기반으로 진행하는 경우

생성, 예측 모델, 패턴 매칭에 더불어 AI의 의사결정까지 활용하는 경우 해당되는 단계입니다. 모든 유저의 개별 데이터를 바탕으로 분석하고 의사결정을 내리기 때문에, 진정한 1:1 개인화가 가능합니다.

이 단계에서는 모든 과정이 AI를 통해 자동화되어 훨씬 빠르고 유연하게 대응할 수 있습니다. 마케터는 AI가 학습하고 의사결정을 내릴 수 있도록 방향성과 전략을 제시하는 지휘자 역할을 하게 됩니다. 반복 작업에서 벗어나 더 상위 차원의 업무를 수행하며, 결과적으로 유저의 만족도를 높일 수 있습니다.

몇 년 전 '자동화'와 '개인화'는 CRM 마케팅의 패러다임을 바꾸며, 마케터의 업무 방식과 핵심 역량을 완전히 새롭게 정의했습니다. 앞으로 AI를 통해 수행할 수 있는 CRM 마케팅 업무는 더욱 다양해질 것입니다.

이는 CRM 마케팅이 비즈니스에 미치는 영향력이 더욱 커진다는 의미입니다. 따라서 마케터의 역할도 변화할 것으로 예상됩니다. 마케터는 실행 중심의 업무보다는 메시지 구성, 타겟 설정, 발송 시점 결정과 같은 전략 수립에 집중하게 될 것입니다. 주어진 리소스를 효율적으로 배분하는 역할이 더욱 중요해질 것입니다.

브레이즈는 이러한 변화에 대응하기 위해 AI 기능을 지속적으로 강화하고 있습니다. 마케팅 AI를 활용해 마케팅 업무를 효율화하고, 성과를 내는 본질에 집중하고 싶다면 지금 바로 마티니에 문의해 보세요.

사실 브레이즈에는 기존에도 CRM 업무 효율성을 높이고, 더 높은 성과를 가져오는 다양한 AI 기능들이 존재했습니다.

이번에는 기존에 존재했던 BrazeAI 기능들을 정리하겠습니다.

유저 행동 패턴에 따른 최적의 메시지 선택

Intelligence Suite는 고객의 기존 데이터를 바탕으로 패턴을 예측하여 메시지에 적용할 수 있는 기능입니다.

기존에 개별 유저들이 어떤 채널에 잘 반응하는지, 몇 시에 주로 메시지를 열어보는지 패턴을 분석합니다. 분석한 내용에 따라 ‘앱푸시(App Push)에 자주 반응 하는 그룹’ 처럼 타겟팅에 활용하거나, 개별 유저가 잘 반응 하는 시간에 메시지를 개별 발송 할 수도 있습니다.

Intelligence Suite에 포함되는 상세한 기능들은 아래와 같습니다.

유저의 행동을 예측

Predictive Suite는 유저의 기존 행동 데이터를 토대로 다음의 행동을 예측하는 기능입니다. BrazeAI에는 크게 두 가지의 예측 모델이 존재합니다.

Predictive Churn을 활용하여 이탈 예상 유저, 이탈 위험군 유저를 타겟하여 스페셜 오퍼를 제공하는 등 이탈 방지 캠페인에 활용할 수 있습니다. 반면 Predictive Events는 재구매 가능성이 높은 사람들을 타겟하거나, 카카오/문자 같은 유료채널을 구매 가능성이 높은 유저위주로 발송하여 비용 효율화에도 사용할 수 있습니다.

가장 효과적인 구매 유도 도구

상품추천 기능은 유저의 구매를 이끌어내기에 아주 효율적인 도구입니다. 다만, 상품추천을 하기 위한 엔진 개발이 마케터에게는 굉장히 어려운 일인데요. BrazeAI의 AI Recommendation을 활용하면 다양한 추천 엔진을 CRM 메시지에 활용할 수 있습니다.

상품추천은 유저의 구매 여정을 돕는 일종의 가이드 역할도 하기 때문에, CRM 자동화 캠페인에서 꼭 활용해보시길 권장드립니다.

마케팅 생산성의 극대화

브레이즈의 캠페인 셋팅 화면에서 즉시 메시지 카피를 생성하고 적용할 수 있습니다. 언어 뿐만 아니라 대략적인 문장 길이와 메시지 톤까지 설정할 수 있어 활용도를 높일 수 있습니다.

브레이즈 대시보드 내에서 DALL·E 3를 활용하여 이미지를 생성할 수 있습니다.

이미지 생성을 위한 가이드를 입력한 이후, 생성된 이미지 내에서 원하는 이미지를 선택하여 메시지에 즉각 활용할 수 있습니다.

기존 유저에게 발송되는 CRM 메시지의 특성상, 잘못된 메시지 발송의 리스크는 타 마케팅 대비 더 크다고 볼 수 있습니다.

그러나 BrazeAI의 Content QA를 활용하면 오탈자 검수, 문법 체크, 문체 조정 등 메시지에서 발생할 수 있는 리스크를 관리할 수 있습니다.

Liquid는 브레이즈에서 다양한 개인화를 가능하게 하는 효과적인 도구입니다. 그러나 처음에는 배우고 활용하기 어렵다는 문제가 존재하는데요. AI Liquid Assistant를 활용하면 자연어로 질문하고, 완성된 Liquid 구문을 받을 수 있습니다.

브레이즈의 Query Builder는 재구매 주기 파악, 연관 상품 분석 등 CRM 캠페인을 위한 분석을 확장해주는 유용한 도구입니다. SQL Query Builder에서도 AI를 활용하여 원하는 분석을 위한 쿼리를 제작할 수 있습니다.

Segment Extension은 Query Builder와 유사하게 쿼리문을 작성해서 활용합니다. Query Builder가 분석을 위한 도구라면, Segment Extension은 쿼리의 결과에 해당하는 유저들을 바로 캠페인의 타겟으로 활용할 수 있게 해줍니다.

AI SQL Generator를 활용하여 SQL Segment Extensions 활용을 위한 쿼리문을 간편하게 제작할 수 있습니다.

다음 콘텐츠에서는 CRM 마케팅에서 AI가 어떤 식으로 활용될 수 있을지, Forge 2025에서 공개된 내용을 바탕으로 개념을 정리하고 활용 사례를 공유드리고자 합니다.

.png)

마티니는 Braze팀의 공식 초청을 받아 지난 9월 28일부터 10월 1일까지, 샌프란시스코에서 열린 forge-2025에 참석했습니다.

Braze Forge는 매년 전 세계 마케터와 CRM 전문가들이 모이는 Braze의 대표 글로벌 이벤트로, 최신 프로덕트 업데이트와 실무 중심의 CRM 마케팅 인사이트가 공유되는 자리입니다. 이번 2025년 행사에서 가장 주목받은 키워드는 바로 BrazeAI였습니다.

현장에서는 BrazeAI에 새롭게 추가된 기능들을 바탕으로, 네트워킹 현장 곳곳에서 신규 기능에 대한 열띤 논의가 이어졌는데요. 이번 글에서는 Braze Forge 2025에서 공개된 BrazeAI의 주요 신규 기능을 자세히 살펴보겠습니다.

AI가 주도하는 마케팅 의사결정

.webp)

이번 Forge에서 공개된 신규 AI 기능 중 가장 큰 주목을 받은 기능은 BrazeAI Decisioning Studio입니다. AI를 활용해 생성, 예측 등에 그치지 않고 스스로 ‘의사결정’까지 가능하게 합니다.

기존의 자동화, 개인화는 결정적인 한계가 있었습니다. 모든 의사결정을 사람이 직접 내려야 했기 때문입니다. A/B 테스트를 반복하고, 세그먼트별로 전략을 설계하고, 타이밍과 메시지를 조율하는 과정은 많은 시간과 리소스를 소모합니다. 게다가 계속 누적되는 유저 행동 데이터를 실시간으로 반영하기란 사실상 불가능했습니다.

하지만 BrazeAI Decisioning Studio는 이 한계를 넘어섭니다. 유저의 행동 데이터를 기반으로 발송 시간, 할인율, 개인화 요소 등 CRM 마케팅의 핵심 의사결정을 AI가 실시간으로 처리합니다.

기존 규칙 기반 개인화를 넘어 완벽한 1:1 개인화까지 가능해지면서, 브레이즈는 CRM 마케팅에서 더욱 강력한 도구로 자리잡게 될 것으로 예상됩니다.

언제든지 조언을 구할 수 있는 AI 기반의 CRM 마케팅 파트너

BrazeAI Operator는 챗봇 형태로 구성이 되어 있으며, Braze 대시보드 내 어디에서든 자유롭게 사용이 가능합니다. 자연어로 요구사항을 입력하면, BrazeAI에서 그에 대한 응답을 제공하고 대시보드내 실제 반영까지 가능합니다.

BrazeAI Operator를 활용하는 다양한 예시는 다음과 같습니다.

BrazeAI Operator의 가장 큰 차별점은 AI가 제안만 하는 것이 아니라, 대시보드 내에서 직접 실행까지 연결된다는 점입니다. 지금 AI의 의견을 반영하여, 바로 고객에게 적합한 메시지를 기획해보세요.

자사 비즈니스 데이터 기반의 맞춤형 CRM AI

BrazeAI Agent Console은 마케터가 직접 용도에 맞게 AI를 생성, 관리, 배포할 수 있는 브레이즈 내 플랫폼입니다. 별도의 엔지니어링 기술이 없어도 BrazeAI Agent Console을 이용하면 몇 번의 클릭 만으로 AI를 생성하고, 학습시킬 수 있습니다.

이 기능은 마케터가 기술적 배경 없이도 AI를 생성하고 자사 데이터로 학습시킬 수 있습니다. 또한 기존 AI 기능처럼 프롬프트에 의존하는 단순 챗봇이 아닌, 반복적이고 복잡한 업무를 자동으로 수행하며 전략적 업무까지 처리할 수 있을것으로 기대됩니다.

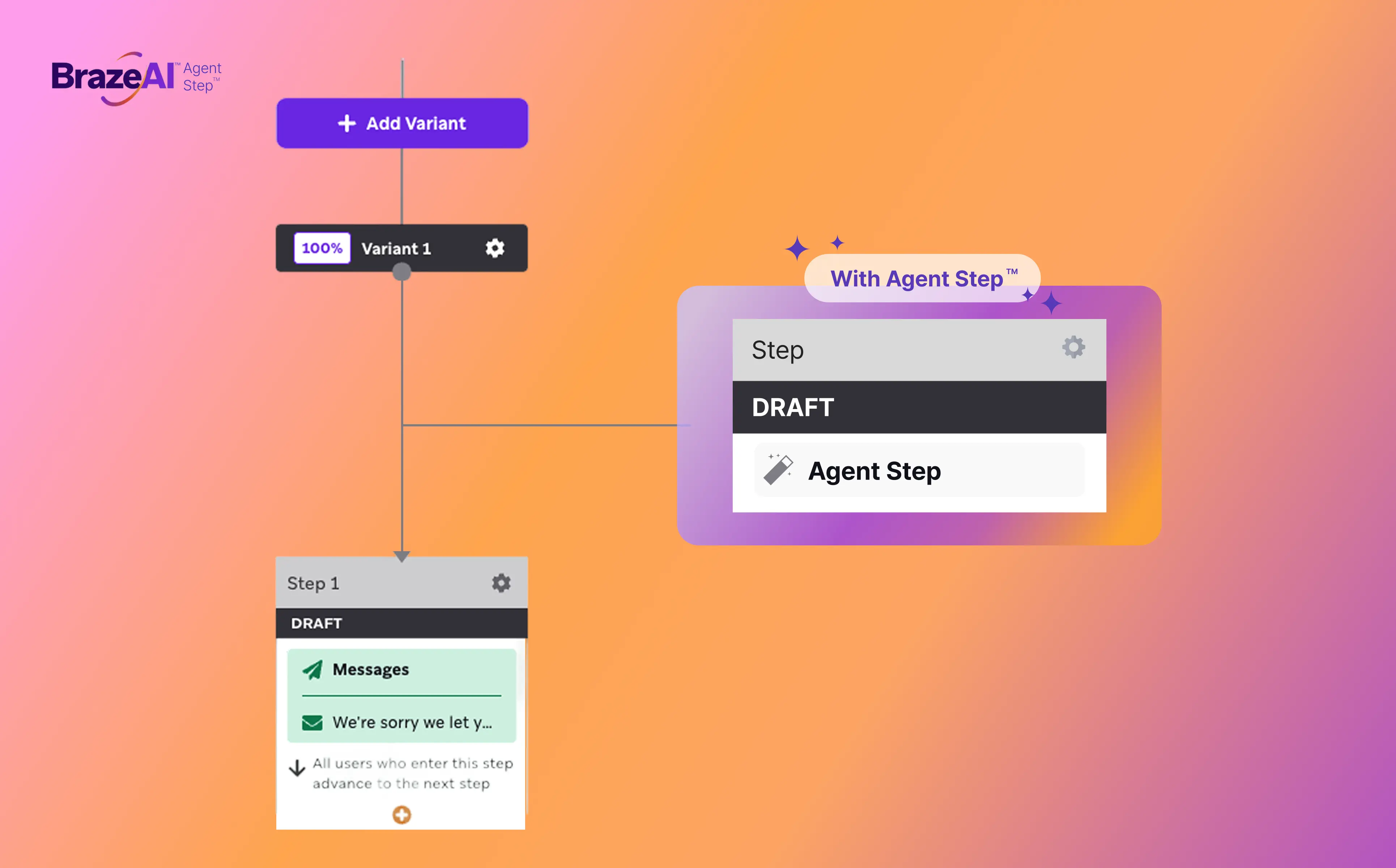

전체 고객 경험을 설계하는 AI

이제 Canvas내에서도 AI를 활용한 Canvas Step을 활용할 수 있습니다. Canvas의 Agent Step은 앞서 설명한 BrazeAI Agent Console을 이용하여, AI가 직접 의사결정하고 컨텐츠를 생성할 수 있는 Step입니다.

Agent Step은 크게 두 가지 용도로 활용 될 수 있습니다.

의사결정:

기존 유저 데이터와 문맥을 읽고, 직접 의사결정을 통해 해당 유저를 Canvas내에서 스코어링합니다. 해당 스코어를 바탕으로 유저를 다음 Step으로 보내거나, Canvas에서 Drop시킬 수 있습니다.

개인화:

개별 유저의 메시지 상호작용을 분석하여, 개인화된 메시지를 구성할 수 있습니다.

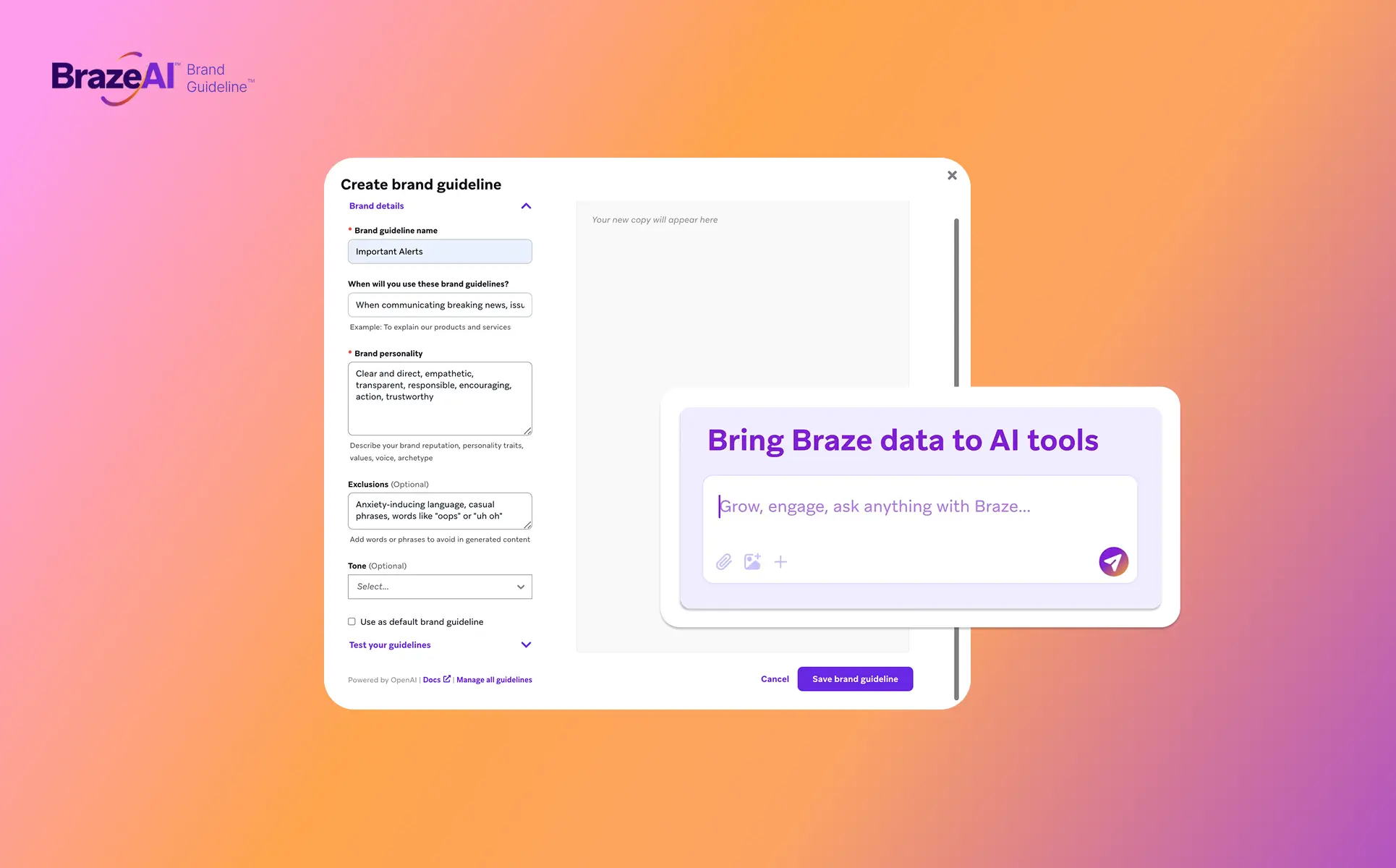

브랜드의 톤&매너를 준수하는 더욱 강화된 생성형 AI

AI 기반 카피라이팅 활용이 늘어나면서, 무작위한 AI 기반의 콘텐츠 형성이 아닌 브랜드 가이드라인을 준수한 콘텐츠 생성이 중요해지고 있습니다. 브레이즈는 이를 해결하기 위해 브랜드 가이드라인 기반 프롬프트 사전 설정 기능을 출시했습니다.

많은 마케터들이 AI를 사용하면서 겪는 공통적인 불편함이 있습니다. "AI가 생성한 문구가 우리 브랜드 느낌이 아니라서 결국 다시 써야 한다"는 점입니다. 프롬프트를 매번 다르게 입력하거나, 생성된 결과를 일일이 검토하고 수정하는 일은 오히려 업무를 늘립니다.

Braze AI의 Brandguideline 기능을 통해 브랜드 가이드라인을 미리 설정해두면, AI가 브랜드에 맞는 톤으로 메시지를 작성해줍니다. 또한 자주 쓰는 AI엔진을 Braze와 연동하여 더 쉽고 간편하게 수정 시간을 줄이고 즉시 사용 가능한 메시지를 얻을 수 있습니다.

해당 기능은 현재 Global Access 단계로, 브레이즈 대시보드에서 바로 사용할 수 있습니다. 지금 Brand Guideline를 사용하여 더 쉽고 간편하게 CRM 메시지를 기획해보세요.

Braze는 Forge 2025에서 AI로 인해 마케터 역할이 진화될 것이라고 의견을 밝혔습니다.

AI 시대에서 마케터의 역할은 축소되는 것이 아니라 확장되며, 기계적인 업무에서 벗어나 전략적 지휘자로서 더 본질적인 업무에 집중하게 될 것입니다. 따라서 단순한 가속화를 넘어 업무 방식의 근본적 변화가 필요하고 부가가치가 낮은 업무는 자동화되지만, 전략 수립과 품질 관리는 여전히 인간의 영역으로 남을 것이다.

이처럼 BrazeAI를 포함한 AI 기술들이 마케팅 실무에 깊숙이 스며들며, 마케터는 단순 작업을 자동화 하여 반복 작업으로부터 자유로워질 수 있을것으로 기대됩니다.

AI 시대의 마케터는 전략적 지휘자로서 전략 수립, 고객 경험 설계, 브랜드 일관성 유지 같은 고차원적 업무에 집중하게 될 것입니다. 결국 AI는 마케터를 대체하는 것이 아니라, 더 본질적인 가치를 만드는 일에 몰입할 수 있도록 돕는 도구가 될 것입니다.

다음 글에서는 Forge 2025에서 새롭게 공개된 신규 BrazeAI 기능 외에도 기존에 존재하던 AI 기능들에 대한 글로 찾아뵙겠습니다.